Tin tức

Tổng quan về Kết quả MLPerf™ Inference v2.0 trên Máy chủ Dell

Dell Technologies đã tham gia tích cực vào việc đệ trình điểm chuẩn Suy luận MLCommons™ kể từ ngày đầu tiên. Chúng tôi đã hoàn thành năm vòng đệ trình suy luận.

Blog này cung cấp tổng quan về các kết quả mới nhất của trung tâm dữ liệu đóng MLPerf Inference v2.0, sức mạnh trung tâm dữ liệu đóng, biên kín và các danh mục năng lượng biên kín trên máy chủ Dell từ Phòng thí nghiệm đổi mới AI & HPC của chúng tôi . Nó cho thấy hiệu suất suy luận và năng lượng (hiệu suất trên mỗi watt) tối ưu cho các máy chủ dựa trên GPU của Dell (DSS 8440, PowerEdge R750xa, PowerEdge XE2420, PowerEdge XE8545 và PowerEdge XR12). Bạn có thể tìm thấy blog trước về kết quả hiệu suất MLPerf Inference v1.1 tại đây .

Cái gì mới?

- Có 3.800 kết quả hiệu suất cho vòng này so với 1.800 kết quả hiệu suất cho v1.1. Ngoài ra, 885 hệ thống trong phiên bản 2.0 so với 424 hệ thống trong phiên bản 1.1 cho thấy số hệ thống được gửi cho vòng này nhiều hơn gấp đôi.

- Đối với điểm chuẩn 3D U-Net , bộ dữ liệu hiện được sử dụng là bộ Phân đoạn khối u thận KiTs 2019 .

- Tính năng dừng sớm đã được giới thiệu trong vòng này để thay thế số lượng truy vấn tối thiểu xác định bằng một hàm xác định động khi không cần chạy thêm để xác định mức tăng hiệu suất bổ sung.

Kết quả trong nháy mắt

Dell Technologies đã gửi 167 kết quả cho các hạng mục khác nhau. Nhóm Dell đã thực hiện 86 lần gửi cho hạng mục trung tâm dữ liệu đóng, 28 lần gửi vào hạng mục năng lượng của trung tâm dữ liệu đóng và 53 lần gửi vào hạng mục biên đóng. Đối với danh mục trung tâm dữ liệu đã đóng, nhóm Dell đã gửi nhiều kết quả thứ hai. Trên thực tế, Dell Technologies đã gửi kết quả từ 17 cấu hình hệ thống khác nhau với các công cụ suy luận NVIDIA TensorRT và NVIDIA Triton . Trong số 17 cấu hình này, máy chủ PowerEdge XE2420 với GPU T4 và A30 và PowerEdge XR12máy chủ với GPU A2 là hai hệ thống mới chưa từng được gửi trước đây. Ngoài ra, Dell Technologies đã đệ trình kịch bản Multiterm được giới thiệu lại. Chỉ Dell Technologies gửi kết quả cho các hệ điều hành máy chủ khác nhau.

Kết quả đáng chú ý

Kết quả đáng chú ý bao gồm:

- Máy chủ PowerEdge XE8545 và R750xa mang lại kết quả Số Một về hiệu suất trên mỗi máy gia tốc với GPU NVIDIA A100. Các trường hợp sử dụng cho phân loại hàng đầu này bao gồm Phân loại hình ảnh, Phát hiện đối tượng, Chuyển lời nói thành văn bản, Hình ảnh y tế, Xử lý ngôn ngữ tự nhiên và Đề xuất.

- Máy chủ DSS 8440 mang lại kết quả Số Hai về hiệu năng hệ thống cho nhiều điểm chuẩn bao gồm Chuyển giọng nói thành văn bản, Phát hiện đối tượng, Xử lý ngôn ngữ tự nhiên và Phân đoạn hình ảnh y tế đối với các trường hợp sử dụng trong số tất cả các lần gửi.

- Máy chủ PowerEdge R750xa mang lại kết quả Số Một về hiệu năng hệ thống cao nhất cho nhiều điểm chuẩn bao gồm Phân loại hình ảnh, Phát hiện đối tượng, Chuyển giọng nói thành văn bản, Xử lý ngôn ngữ tự nhiên và các trường hợp sử dụng Đề xuất trong số tất cả các máy chủ GPU dựa trên PCIe.

- Máy chủ PowerEdge XE8545 mang lại kết quả Số một về độ trễ đa luồng thấp nhất với GPU Đa phiên bản NVIDIA (MIG) trong danh mục biên cho các trường hợp sử dụng Phân loại hình ảnh và Phát hiện đối tượng.

- Máy chủ PowerEdge XE2420 mang lại kết quả Number On e cho kết quả suy luận GPU T4 cao nhất cho các trường hợp sử dụng Phân loại hình ảnh, Chuyển giọng nói thành văn bản và Đề xuất.

- Máy chủ PowerEdge XR12 mang lại kết quả Số Một về hiệu suất cao nhất trên mỗi watt với GPU NVIDIA A2 mang lại sức mạnh cho các trường hợp sử dụng Phân loại hình ảnh, Phát hiện đối tượng, Chuyển giọng nói thành văn bản, Xử lý ngôn ngữ tự nhiên và Đề xuất.

Kết quả điểm chuẩn MLPerf Inference v2.0

Các biểu đồ sau đây làm nổi bật các chỉ số hiệu suất cho các kịch bản Máy chủ và Ngoại tuyến trên các điểm chuẩn khác nhau từ MLCommons. Dell Technologies trình bày kết quả như một phương pháp để khách hàng của chúng tôi xác định các tùy chọn phù hợp với nhu cầu ứng dụng học sâu của họ. Ngoài ra, dữ liệu hiệu suất này đóng vai trò là điểm tham chiếu để cho phép định cỡ các cụm học sâu. Dell Technologies cố gắng gửi càng nhiều kết quả càng tốt để đưa ra câu trả lời nhằm đảm bảo rằng các câu hỏi của khách hàng được giải quyết.

Đối với kịch bản Máy chủ, chỉ số hiệu suất là số truy vấn mỗi giây (QPS). Đối với kịch bản Ngoại tuyến, chỉ số hiệu suất là Mẫu ngoại tuyến mỗi giây. Nói chung, các số liệu đại diện cho thông lượng và thông lượng cao hơn cho thấy kết quả tốt hơn. Trong các biểu đồ sau, trục Y là trục được chia tỷ lệ theo cấp số nhân biểu thị thông lượng và trục X biểu thị các hệ thống được thử nghiệm (SUT) và các mô hình tương ứng của chúng. Các SUT được mô tả trong phần phụ lục.

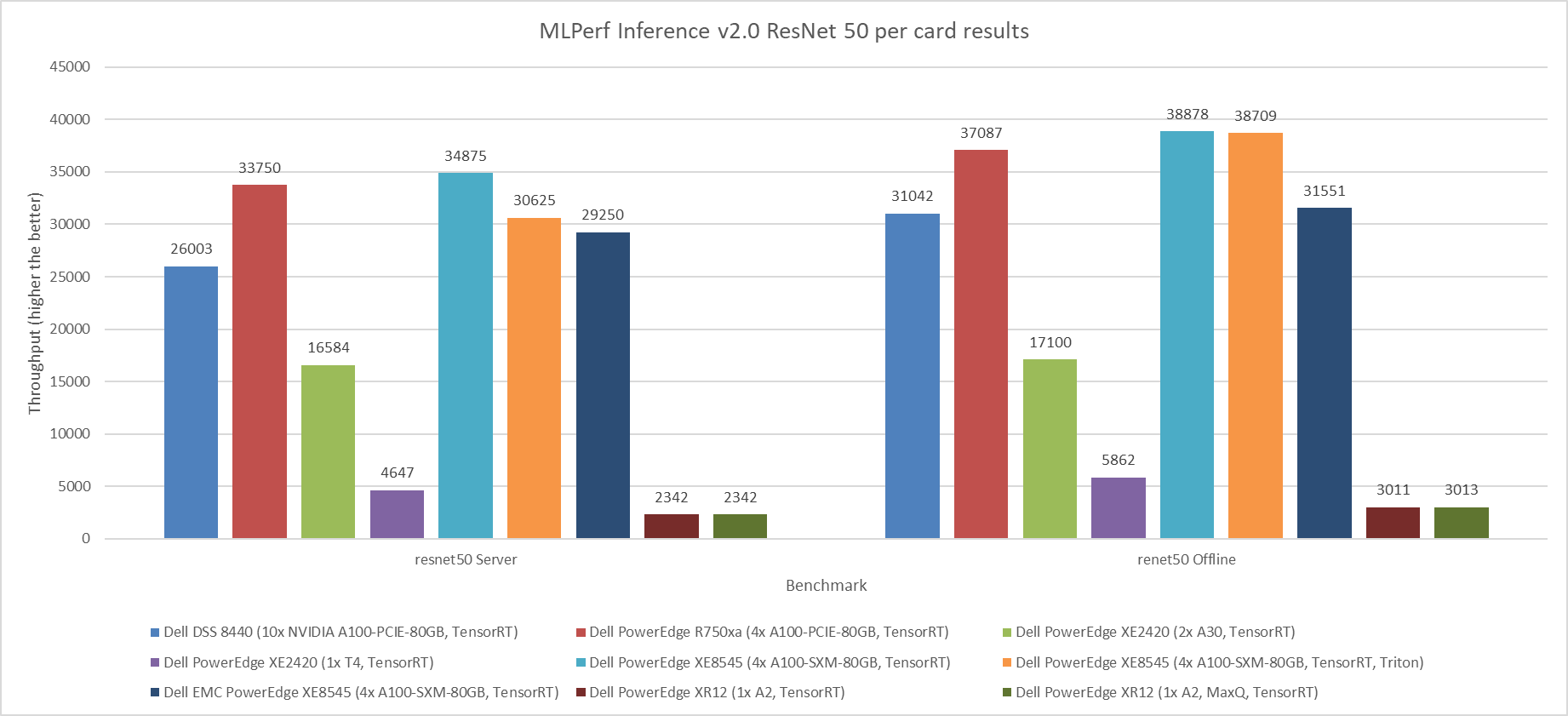

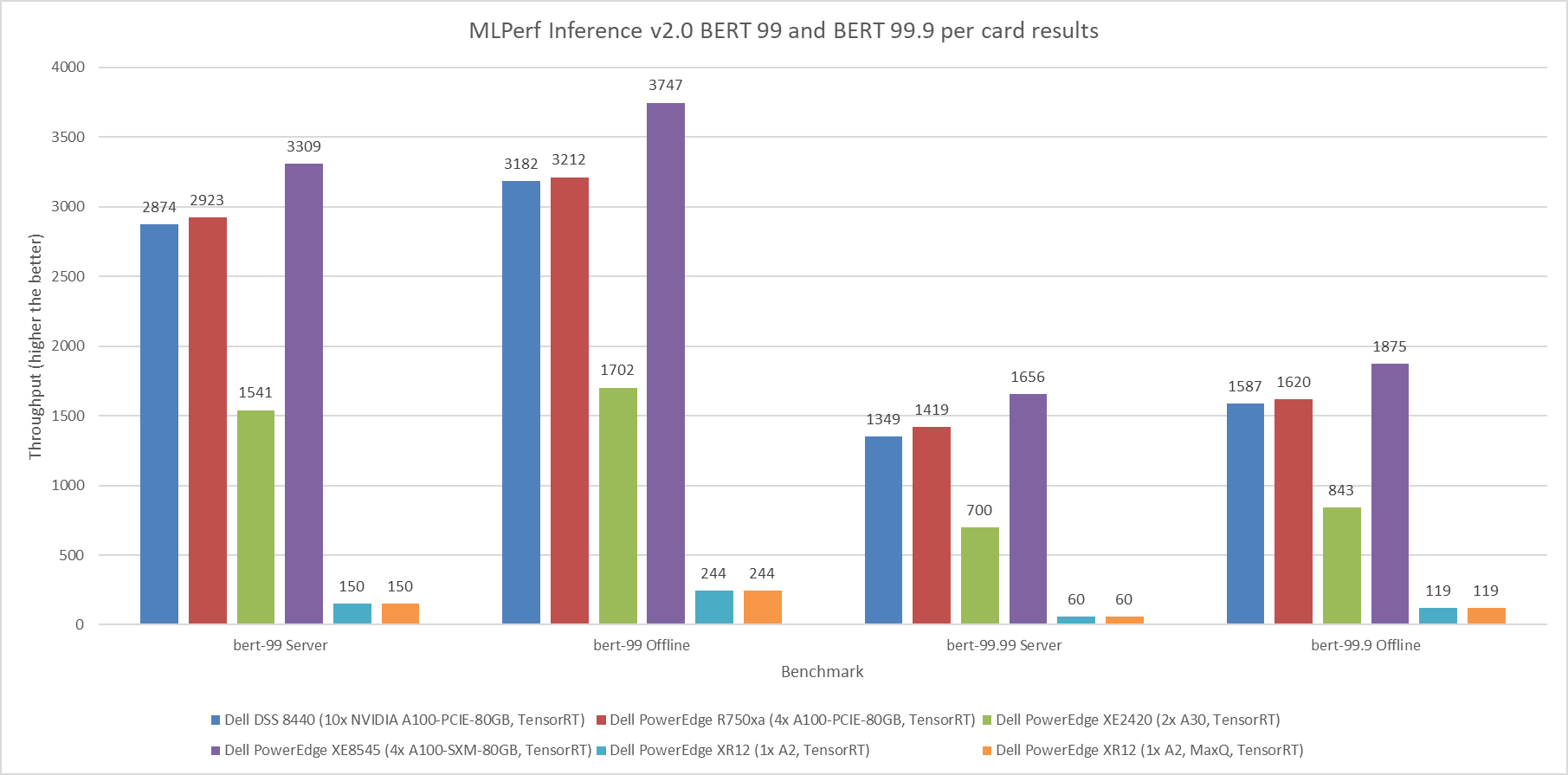

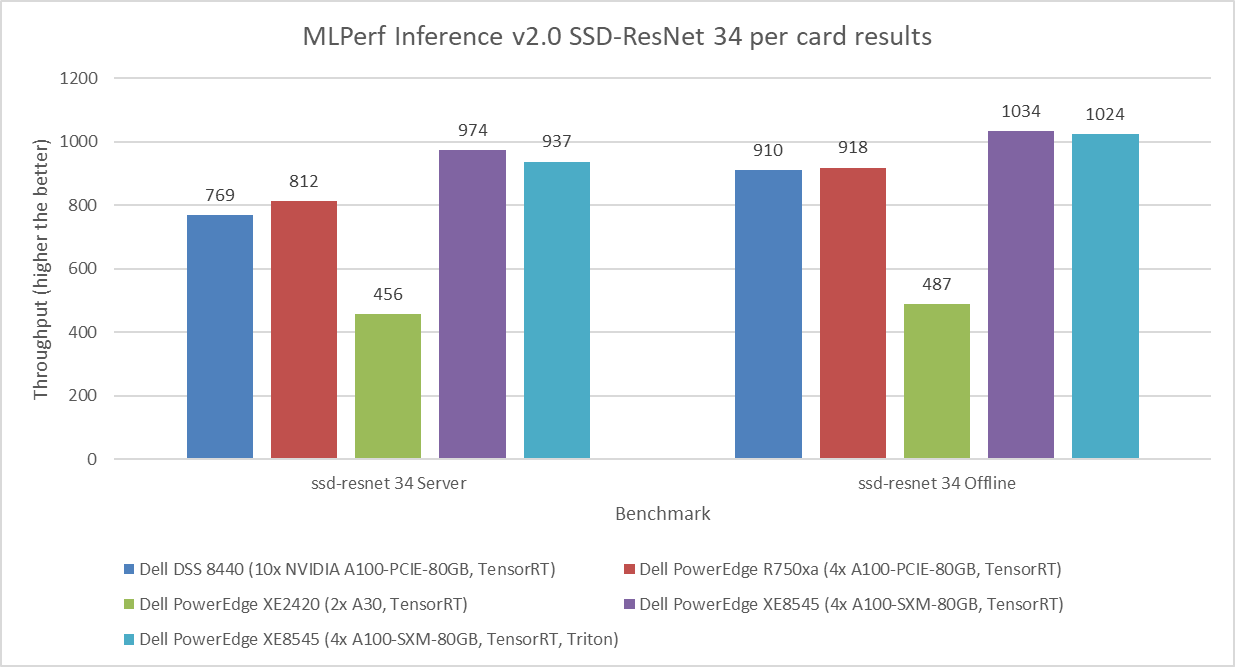

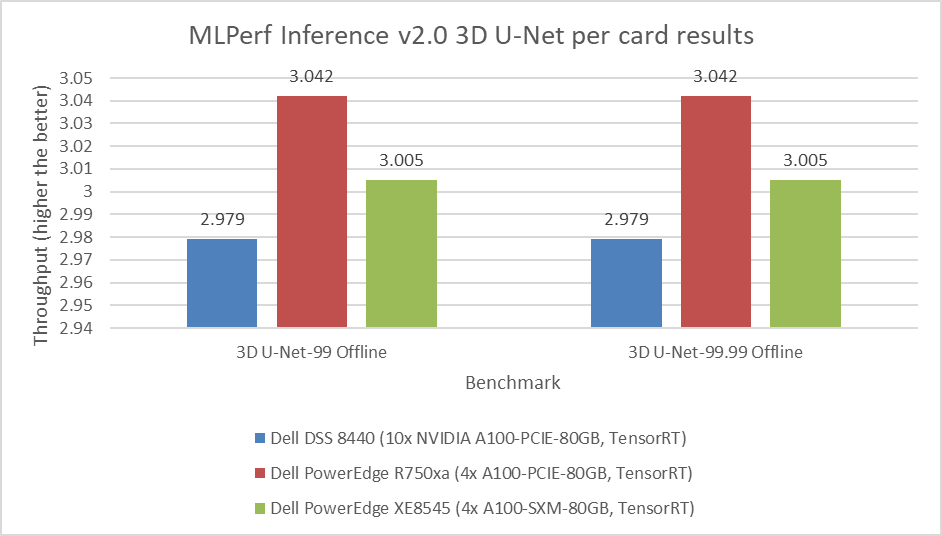

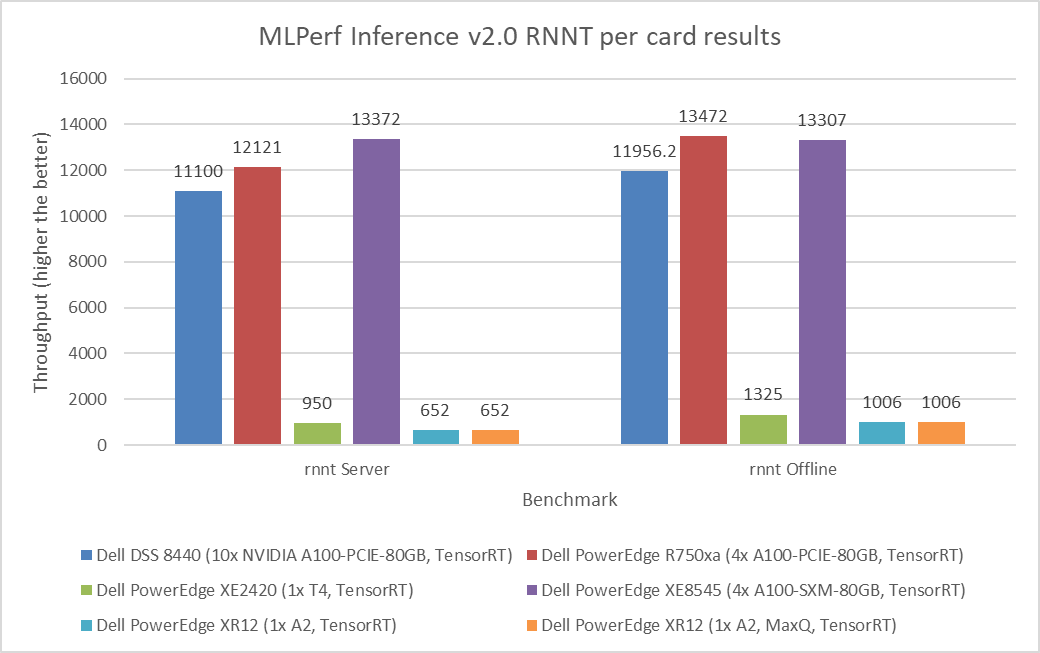

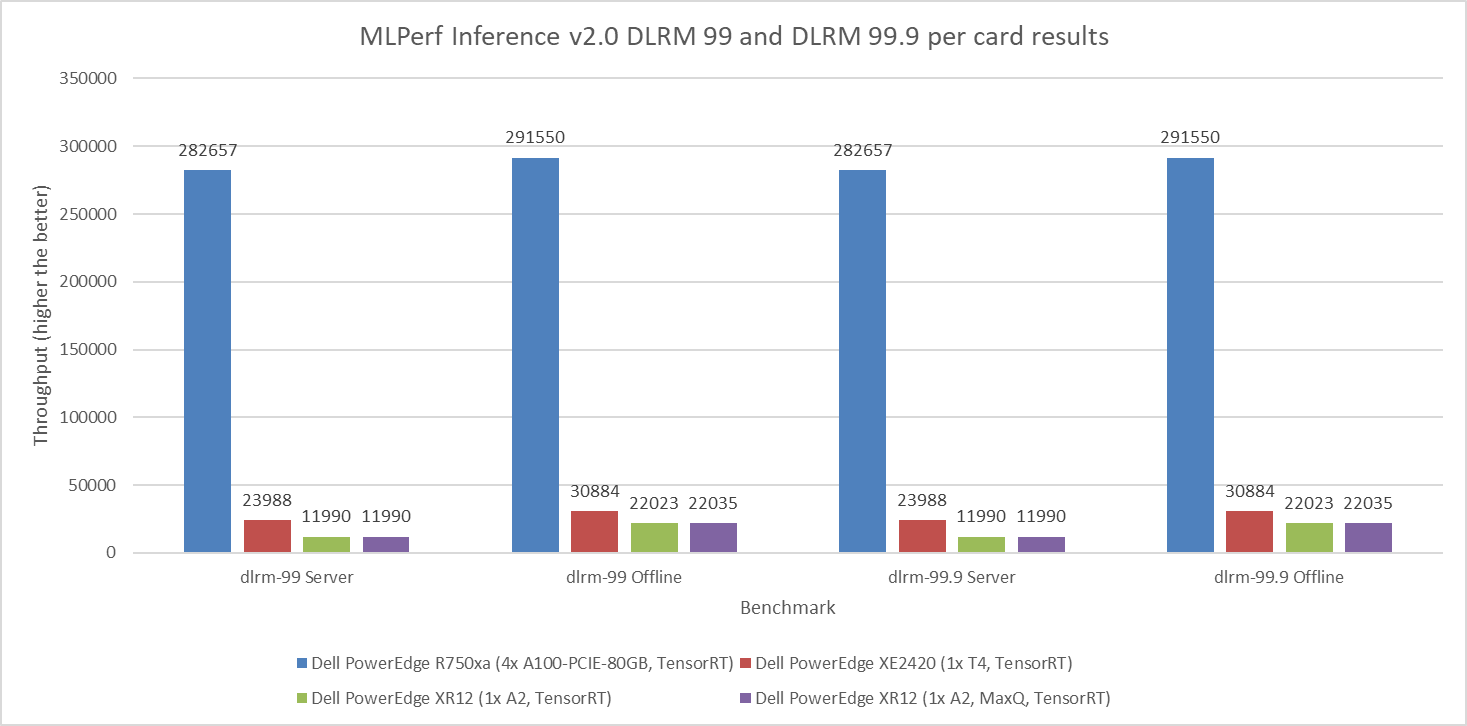

Hình 1 đến Hình 6 hiển thị hiệu suất trên mỗi thẻ của các SUT khác nhau trên các chế độ ResNet 50, BERT, SSD, 3dUnet, RNNT và DLRM tương ứng trong các kịch bản Máy chủ và Ngoại tuyến:

Hình 1: MLPerf Inference v2.0 ResNet 50 trên mỗi kết quả thẻ

Hình 2: MLPerf Inference v2.0 BERT mặc định và độ chính xác cao trên mỗi kết quả thẻ

Hình 3: Kết quả MLPerf Inference v2.0 SSD-ResNet 34 trên mỗi thẻ

Hình 4: Kết quả MLPerf Inference v2.0 3D U-Net trên mỗi thẻ

Hình 5: MLPerf Inference v2.0 RNNT trên mỗi kết quả thẻ

Hình 6: MLPerf Inference v2.0 DLRM mặc định và độ chính xác cao trên mỗi kết quả thẻ

quan sát

Các kết quả trong blog này đã được gửi chính thức và được chấp nhận bởi tổ chức MLCommons. Những kết quả này đã vượt qua các bài kiểm tra tuân thủ, được đánh giá ngang hàng và tuân thủ các ràng buộc do MLCommons thực thi. Khách hàng và đối tác có thể tái tạo kết quả của chúng tôi bằng cách làm theo các bước sau để chạy MLPerf Inference v2.0 trong kho lưu trữ GitHub của mình .

Đệ trình từ Dell Technologies bao gồm khoảng 140 kết quả hiệu suất và 28 kết quả hiệu suất và sức mạnh. Trên nhiều tác vụ khối lượng công việc khác nhau bao gồm Phân loại hình ảnh, Phát hiện đối tượng, Phân đoạn hình ảnh y tế, Chuyển lời nói thành văn bản, Xử lý ngôn ngữ và Đề xuất, hiệu suất máy chủ từ Dell Technologies rất hứa hẹn.

Các máy chủ Dell hoạt động với kết quả năng lượng và hiệu suất tối ưu. Chúng được cấu hình với các GPU khác nhau, chẳng hạn như:

- NVIDIA A30 Tenor Core GPU

- NVIDIA A100 (PCIe và SXM)

- NVIDIA T4 Tenor Core GPU

- NVIDIA A2 Tensor Core GPU, mới được phát hành

Bạn có thể tìm thêm thông tin về hiệu suất cho các cấu hình cụ thể không được thảo luận trong blog này trong kết quả v1.1 hoặc v1.0 .

Nội dung gửi bao gồm các kết quả từ các chương trình phụ trợ suy luận khác nhau, chẳng hạn như NVIDIA TensorRT và NVIDIA Triton . Phụ lục cung cấp một bản tóm tắt về toàn bộ ngăn xếp phần cứng và phần mềm.

Sự kết luận

Blog này định lượng hiệu suất của các máy chủ Dell trong vòng gửi MLPerf Inference v2.0. Người đọc có thể sử dụng những kết quả này để đưa ra quyết định mua hàng và lập kế hoạch sáng suốt cho nhu cầu khối lượng công việc AI của họ.

ruột thừa

ngăn xếp phần mềm

Máy chủ suy luận NVIDIA Triton là một công cụ phần mềm suy luận nguồn mở hỗ trợ triển khai và thực thi các mô hình AI trên quy mô lớn trong sản xuất. Triton không chỉ hoạt động với tất cả các khung chính mà còn với các phần phụ trợ có thể tùy chỉnh, cho phép các nhà phát triển tập trung hơn nữa vào phát triển AI của họ. Nó là một công cụ linh hoạt vì nó hỗ trợ mọi loại suy luận và có thể được triển khai trên mọi nền tảng bao gồm CPU, GPU, trung tâm dữ liệu, đám mây hoặc biên. Ngoài ra, Triton hỗ trợ triển khai nhanh chóng và đáng tin cậy các mô hình AI trên quy mô lớn bằng cách tích hợp tốt với Kubernetes, Kubeflow, Prometheus và Grafana. Triton hỗ trợ các giao thức HTTP/REST và GRPC cho phép các máy khách từ xa yêu cầu tham chiếu cho bất kỳ mô hình nào mà máy chủ quản lý.

NVIDIA TensorRT SDK cung cấp khả năng suy luận học sâu hiệu suất cao bao gồm trình tối ưu hóa suy luận và thời gian chạy. Nó được cung cấp bởi CUDA và cung cấp một giải pháp thống nhất để triển khai trên nhiều nền tảng khác nhau bao gồm cả biên hoặc trung tâm dữ liệu. TensorRT hỗ trợ các khung chính bao gồm PyTorch, TensorFlow, ONNX và MATLAB. Nó có thể nhập các mô hình được đào tạo trong các khung này bằng cách sử dụng các trình phân tích cú pháp tích hợp. Để suy luận, TensorRT thực hiện các đơn đặt hàng cường độ nhanh hơn so với các đối tác chỉ có CPU của nó.

NVIDIA MIG có thể phân vùng GPU thành nhiều phiên bản giúp mở rộng tài nguyên điện toán giữa những người dùng. MIG cho phép hiệu suất có thể dự đoán được và mức sử dụng GPU tối đa bằng cách chạy các tác vụ đồng thời trên các phiên bản khác nhau với các tài nguyên dành riêng cho điện toán, bộ nhớ và băng thông bộ nhớ.

cấu hình SUT

Bảng sau đây mô tả SUT từ vòng gửi suy luận trung tâm dữ liệu này:

Bảng 1: Cấu hình hệ thống MLPerf Inference v2.0 cho máy chủ DSS 8440 và PowerEdge R750xa

| Nền tảng | TenorRT DSS 8440 10xA100 | TenorRT R750xa 4xA100 |

| ID hệ thống MLPerf | DSS8440_A100_PCIE_80GBx10_TRT | R750xa_A100_PCIE_80GBx4_TRT |

| Hệ điều hành | CentOS 8.2 | |

| CPU | CPU Intel Xeon Vàng 6248R @ 3.00 GHz | CPU Intel Xeon Vàng 6338 @ 2.00 GHz |

| Kỉ niệm | 768 GB | 1TB |

| GPU | NVIDIA A100 | |

| Yếu tố hình thức GPU | PCIe | |

| số lượng GPU | 10 | 4 |

| ngăn xếp phần mềm | TenorRT 8.4.0

CUDA 11.6 cuDNN 8.3.2 Trình điều khiển 510.39.01 DALI 0.31.0 |

|

Bảng 2: Cấu hình hệ thống MLPerf Inference v2.0 cho máy chủ PowerEdge XE2420

| Nền tảng | Máy kéo căng PowerEdge XE2420 1xA30 | Máy kéo căng PowerEdge XE2420 2xA30 | PowerEdge XE2420 1xA30 TensorRT MaxQ | Máy kéo căng PowerEdge XE2420 1xAT4 |

| ID hệ thống MLPerf | XE2420_A30x1_TRT | XE2420_A30x2_TRT | XE2420_A30x1_TRT_MaxQ | XE2420_T4x1_TRT |

| Hệ điều hành | Ubuntu 20.04.4 | CentOS 8.2.2004 | ||

| CPU | CPU Intel Xeon Vàng 6252 @ 2.10 GHz | CPU Intel Xeon Gold 6252N @ 2,30 GHz | CPU Intel Xeon Bạc 4216 @ 2.10 GHz | CPU Intel Xeon Vàng 6238 @ 2.10 GHz |

| Kỉ niệm | 1TB | 64 GB | 256 GB | |

| GPU | NVIDIA A30 | NVIDIA T4 | ||

| Yếu tố hình thức GPU | PCIe | |||

| số lượng GPU | 1 | 2 | 1 | 1 |

| ngăn xếp phần mềm | TenorRT 8.4.0

CUDA 11.6 cuDNN 8.3.2 Trình điều khiển 510.39.01 DALI 0.31.0 |

|||

Bảng 3: Cấu hình hệ thống MLPerf Inference v2.0 cho máy chủ PowerEdge XE8545

| Nền tảng | Máy kéo PowerEdge XE8545 4xA100 | PowerEdge XE8545 4xA100 TenorRT, Triton | PowerEdge XE8545 1xA100 MIG 1x1g.10g TensorRT

|

| ID hệ thống MLPerf | XE8545_A100_SXM_80GBx4_TRT | XE8545_A100_SXM_80GBx4_TRT_Triton | XE8545_A100_SXM_80GB_1xMIG_TRT |

| Hệ điều hành | Ubuntu 20.04.3 | ||

| CPU | AMD EPYC 7763 | ||

| Kỉ niệm | 1TB | ||

| GPU | NVIDIA A100-SXM-80GB | NVIDIA A100-SXM-80 GB (1x1g.10gb MIG) | |

| Yếu tố hình thức GPU | SXM | ||

| số lượng GPU | 4 | 1 | |

| ngăn xếp phần mềm | TenorRT 8.4.0

CUDA 11.6 CuDNN 8.3.2 Trình điều khiển 510.47.03 DALI 0.31.0 |

||

| Triton 22.01 | |||

Bảng 4: Cấu hình hệ thống MLPerf Inference v2.0 cho máy chủ PowerEdge XR12

| Nền tảng | Máy kéo căng PowerEdge XR12 1xA2 | PowerEdge XR12 1xA2 TensorRT MaxQ |

| ID hệ thống MLPerf | XR12_A2x1_TRT | XR12_A2x1_TRT_MaxQ |

| Hệ điều hành | CentOS 8.2 | |

| CPU | CPU Intel Xeon Gold 6312U @ 2,40 GHz | |

| Kỉ niệm | 256 GB | |

| GPU | NVIDIA A2 | |

| Yếu tố hình thức GPU | PCIe | |

| số lượng GPU | 1 | |

| ngăn xếp phần mềm | TenorRT 8.4.0

CUDA 11.6 cuDNN 8.3.2 Trình điều khiển 510.39.01 DALI 0.31.0 |

|

Bài viết mới cập nhật

Thuần hóa sự hỗn loạn của công nghệ: Giải pháp phục hồi sáng tạo của Dell

Sự cố CNTT nghiêm trọng ảnh hưởng đến 8,5 triệu hệ ...

Dell PowerScale và Marvel hợp tác để tạo ra quy trình làm việc truyền thông tối ưu

Hiện đang ở thế hệ thứ 9, giải pháp lưu trữ Dell ...

Bảo mật PowerScale OneFS SyncIQ

Trong thế giới sao chép dữ liệu, việc đảm bảo tính ...

Danh sách kiểm tra cơ sở bảo mật PowerScale

Là một biện pháp bảo mật tốt nhất, chúng tôi khuyến ...