Cơ sở hạ tầng NVIDIA & các thành phần phần mềm

Giới thiệu

Phần này mô tả các thành phần phần mềm AI và tăng tốc phần cứng chính của NVIDIA được sử dụng trong kiến trúc giải pháp AI chung.

Bộ tăng tốc NVIDIA

Các GPU NVIDIA sau đây nằm trong số các thành phần tăng tốc NVIDIA được sử dụng trong kiến trúc giải pháp AI tổng quát này.

NVIDIA H100 Tenor Core GPU

GPU NVIDIA H100 Tensor Core mang lại hiệu suất, khả năng mở rộng và bảo mật chưa từng có cho mọi khối lượng công việc. Với Hệ thống chuyển mạch NVLInk thế hệ thứ tư của NVIDIA, GPU NVIDIA H100 tăng tốc khối lượng công việc AI với Công cụ biến áp chuyên dụng cho các mô hình ngôn ngữ nghìn tỷ tham số. GPU NVIDIA H100 sử dụng những cải tiến đột phá trong kiến trúc NVIDIA Hopper để cung cấp AI đàm thoại đầu ngành, tăng tốc các mô hình ngôn ngữ lớn gấp 30 lần so với thế hệ trước.

Đối với các công việc nhỏ, GPU NVIDIA H100 có thể được phân vùng thành các phân vùng GPU Đa phiên bản (MIG) có kích thước phù hợp. Với Điện toán bí mật Hopper, sức mạnh tính toán có thể mở rộng này có thể bảo mật các ứng dụng nhạy cảm trên cơ sở hạ tầng trung tâm dữ liệu dùng chung. Việc bao gồm bộ phần mềm NVIDIA AI Enterprise giúp giảm thời gian phát triển và đơn giản hóa việc triển khai khối lượng công việc AI, đồng thời biến GPU NVIDIA H100 trở thành nền tảng trung tâm dữ liệu HPC và AI đầu cuối mạnh mẽ nhất.

GPU NVIDIA L40

Bộ tăng tốc GPU NVIDIA L40 là giải pháp đồ họa PCI Express Gen4 10,5 inch có chiều cao đầy đủ, chiều dài đầy đủ (FHFL), khe cắm kép dựa trên Kiến trúc NVIDIA Ada Lovelace mới nhất. Thẻ được làm mát thụ động và có khả năng cung cấp công suất bo mạch tối đa 300 W.

GPU NVIDIA L40 hỗ trợ dò tia được tăng tốc phần cứng mới nhất, các tính năng AI mang tính cách mạng, tạo bóng tiên tiến và khả năng mô phỏng mạnh mẽ cho nhiều trường hợp sử dụng đồ họa và điện toán trong triển khai trung tâm dữ liệu và máy chủ biên. Hỗ trợ này bao gồm NVIDIA Omniverse, chơi game trên đám mây, kết xuất hàng loạt, máy trạm ảo và đào tạo học sâu cũng như khối lượng công việc suy luận.

Là một phần của nền tảng máy chủ NVIDIA OVX, GPU NVIDIA L40 mang lại hiệu suất đồ họa, dò tia và mô phỏng ở mức cao nhất cho NVIDIA Omniverse. Với bộ nhớ GDDR6 48 GB, ngay cả những ứng dụng đồ họa nặng nhất cũng chạy với mức hiệu suất cao nhất.

NVIDIA L4 Tenor Core GPU

GPU NVIDIA Ada Lovelace L4 Tensor Core mang đến khả năng tăng tốc toàn cầu và tiết kiệm năng lượng cho video, AI, máy tính để bàn ảo hóa và các ứng dụng đồ họa trong doanh nghiệp, trên đám mây và ở vùng biên. Với nền tảng AI của NVIDIA và phương pháp tiếp cận toàn bộ, GPU NVIDIA L4 được tối ưu hóa để suy luận trên quy mô lớn cho nhiều ứng dụng AI, bao gồm đề xuất, trợ lý hình đại diện AI dựa trên giọng nói, AI tổng hợp, tìm kiếm trực quan và tự động hóa trung tâm liên lạc để cung cấp những trải nghiệm cá nhân tốt nhất.

GPU NVIDIA L4 là bộ tăng tốc NVIDIA hiệu quả nhất cho mục đích sử dụng chính. Các máy chủ được trang bị GPU NVIDIA L4 cung cấp hiệu suất video AI cao hơn tới 120 lần và hiệu suất AI tổng thể cao hơn 2,5 lần so với các giải pháp CPU, cũng như hiệu suất đồ họa cao hơn bốn lần so với thế hệ GPU trước đó. Tính linh hoạt và hệ số dạng cấu hình thấp, một khe cắm, tiết kiệm năng lượng của GPU NVIDIA L4 khiến nó trở nên lý tưởng cho việc triển khai toàn cầu, bao gồm cả các vị trí biên.

NVIDIA NVLink và NVSwitch

NVIDIA NVLink là một kết nối nhanh, có khả năng mở rộng, hỗ trợ các hệ thống đa nút, đa GPU với khả năng giao tiếp tốc độ cao, liền mạch giữa mọi GPU. Thế hệ thứ tư của công nghệ NVIDIA NVLink cung cấp băng thông cao hơn 1,5 lần và khả năng mở rộng được cải thiện cho các cấu hình hệ thống đa GPU. Một GPU NVIDIA H100 Tensor Core duy nhất hỗ trợ tối đa 18 kết nối NVLink với tổng băng thông là 900 gigabyte mỗi giây (GB/giây), gấp bảy lần băng thông của PCIe Gen5.

Để có khả năng mở rộng lớn hơn nữa, NVIDIA NVSwitch xây dựng dựa trên khả năng giao tiếp tiên tiến của NVIDIA NVLink để cung cấp băng thông cao hơn và giảm độ trễ cho khối lượng công việc tính toán chuyên sâu. Để kích hoạt các hoạt động tập thể, tốc độ cao, mỗi NVIDIA NVSwitch có 64 cổng NVIDIA NVLink được trang bị các công cụ cho Giao thức giảm tổng hợp phân cấp có thể mở rộng NVIDIA (SHARP) để giảm thiểu trong mạng và tăng tốc phát đa hướng.

Phần mềm trí tuệ nhân tạo NVIDIA

Các giải pháp phần mềm doanh nghiệp của NVIDIA được thiết kế để cung cấp cho quản trị viên CNTT, nhà khoa học dữ liệu, kiến trúc sư và nhà thiết kế quyền truy cập vào các công cụ họ cần để dễ dàng quản lý và tối ưu hóa các hệ thống tăng tốc của họ.

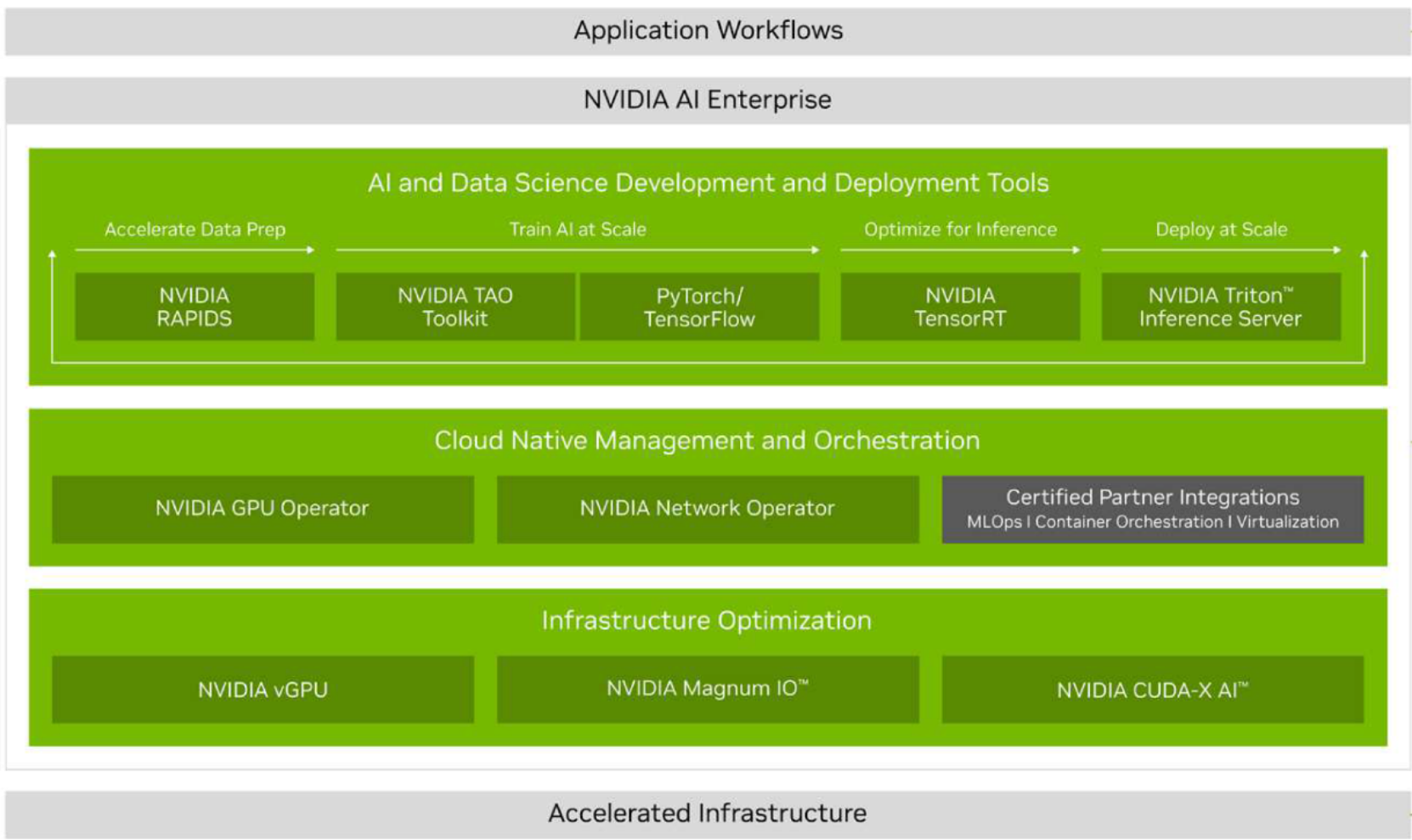

Doanh nghiệp AI của NVIDIA

NVIDIA AI Enterprise, lớp phần mềm của nền tảng NVIDIA AI, tăng tốc quy trình khoa học dữ liệu, đồng thời hợp lý hóa quá trình phát triển và triển khai AI sản xuất bao gồm AI tổng quát, thị giác máy tính, AI lời nói, v.v. Nền tảng phần mềm AI an toàn, ổn định, dựa trên đám mây này bao gồm hơn 100 khung, mô hình được đào tạo trước và các công cụ giúp tăng tốc xử lý dữ liệu, đơn giản hóa việc đào tạo và tối ưu hóa mô hình cũng như triển khai hợp lý.

- Chuẩn bị dữ liệu —Cải thiện thời gian xử lý dữ liệu lên tới 5 lần đồng thời giảm chi phí vận hành xuống 4 lần với Trình tăng tốc NVIDIA RAPIDS cho Apache Spark.

- Đào tạo AI —Tạo các mô hình tùy chỉnh, chính xác trong vài giờ, thay vì vài tháng, sử dụng Bộ công cụ NVIDIA TAO và các mô hình được đào tạo trước.

- Tối ưu hóa cho suy luận —Tăng tốc hiệu suất ứng dụng lên tới 40 lần so với các nền tảng chỉ sử dụng CPU trong quá trình suy luận với NVIDIA TensorRT.

- Triển khai trên quy mô lớn —Đơn giản hóa và tối ưu hóa việc triển khai các mô hình AI trên quy mô lớn và trong sản xuất với NVIDIA Triton Inference Server.

Có sẵn trên đám mây, trung tâm dữ liệu và ở biên, NVIDIA AI Enterprise cho phép các tổ chức phát triển một lần và chạy ở mọi nơi. Do NVIDIA duy trì toàn bộ ngăn xếp, nên các tổ chức có thể tin tưởng vào các bản vá và đánh giá bảo mật thường xuyên, độ ổn định của API cũng như khả năng tiếp cận với các chuyên gia AI của NVIDIA và các nhóm hỗ trợ để đảm bảo hoạt động kinh doanh liên tục và các dự án AI luôn đi đúng hướng.

Hình 2. NVIDIA AI Enterprise

NVIDIA AI Enterprise bao gồm NVIDIA NeMo, một khung để xây dựng, tùy chỉnh và triển khai các mô hình AI tổng quát với hàng tỷ tham số. Khung NVIDIA NeMo cung cấp quy trình làm việc tăng tốc để đào tạo với các kỹ thuật xử lý song song 3D. Nó cung cấp một số lựa chọn kỹ thuật tùy chỉnh và được tối ưu hóa để suy luận ở quy mô lớn của các mô hình quy mô lớn cho các ứng dụng ngôn ngữ và hình ảnh, với cấu hình đa GPU và đa nút. NVIDIA NeMo giúp việc phát triển mô hình AI tổng quát trở nên dễ dàng, tiết kiệm chi phí và nhanh chóng cho các doanh nghiệp.

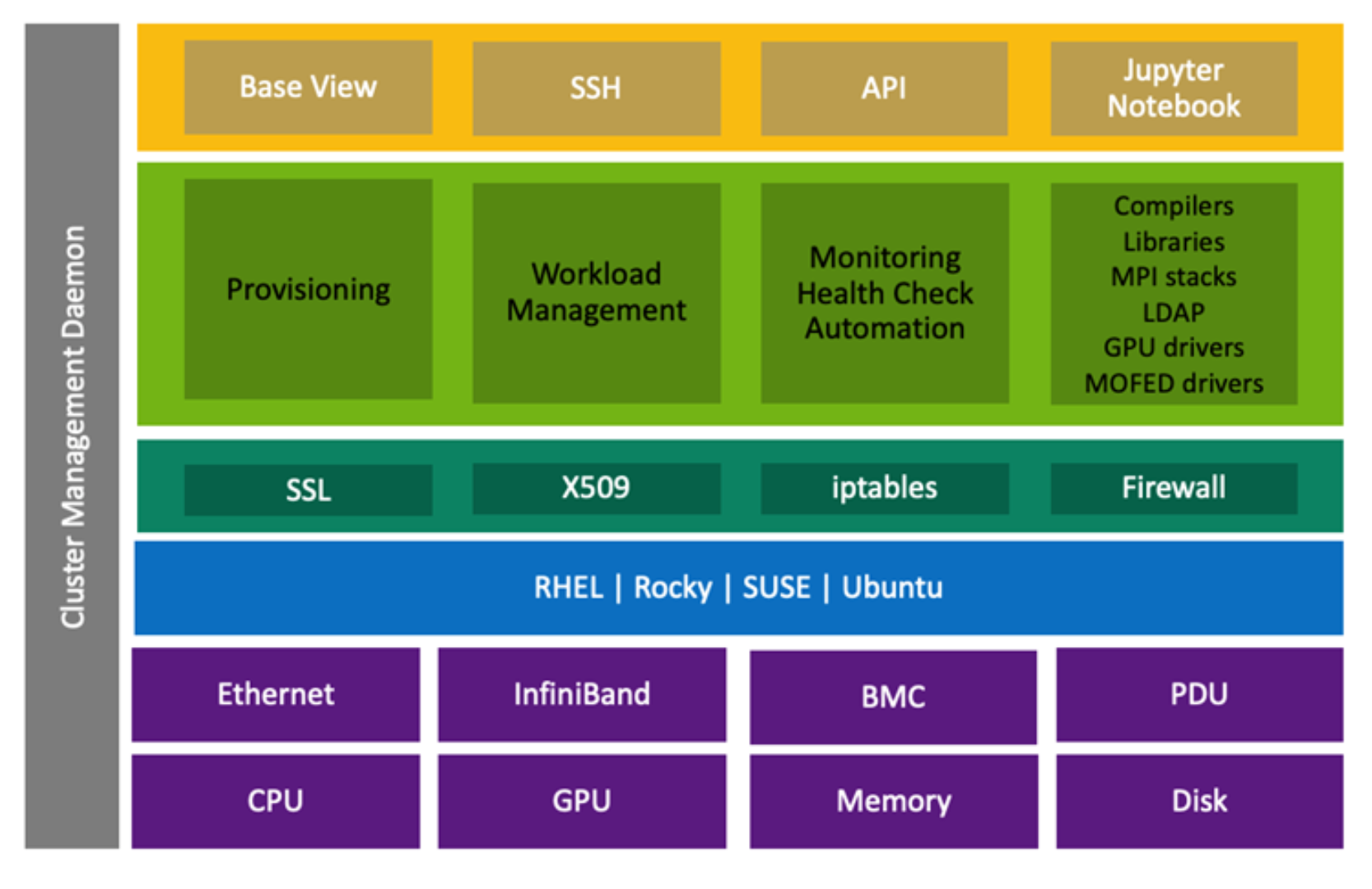

Trình quản lý lệnh cơ sở NVIDIA

NVIDIA BCM là trình quản lý cụm cơ sở hạ tầng AI của NVIDIA. Nó tạo điều kiện vận hành liền mạch quá trình phát triển AI trên quy mô lớn bằng cách cung cấp các tính năng như cung cấp hệ điều hành, nâng cấp chương trình cơ sở, cấu hình mạng và lưu trữ, lập lịch tác vụ đa GPU và đa nút cũng như giám sát hệ thống, từ đó tối đa hóa việc sử dụng và hiệu suất của kiến trúc phần cứng cơ bản.

Hình 3. NVIDIA Base Command Manager

NVIDIA BCM hỗ trợ tự động cung cấp và quản lý các thay đổi trong các nút trong suốt vòng đời của cụm.

Với khung có thể mở rộng và tùy chỉnh, nó có khả năng tích hợp liền mạch với nhiều trình quản lý khối lượng công việc HPC, bao gồm Slurm IBM Spectrum LSF, OpenPBS, Univa Grid Engine và các trình quản lý khác. Nó cung cấp hỗ trợ rộng rãi cho các công nghệ container bao gồm Docker, Harbor, Kubernetes và các nhà khai thác. Nó cũng có một khung quản lý sức khỏe mạnh mẽ bao gồm các số liệu, kiểm tra sức khỏe và hành động.

Bài viết mới cập nhật

Dell Storage Engines: Tăng tốc suy luận AI với PowerScale và ObjectScale

Giải pháp chuyển tải bộ nhớ đệm KV của Dell cho ...

Bảo vệ Nhà máy AI

Áp dụng phương pháp tiếp cận kiến trúc để bảo mật ...

Tiến lên mạnh mẽ với Dell PowerMax: Vượt mặt Hitachi VSP 5000

Dell PowerMax mang lại khả năng phục hồi, hiệu suất và ...

Đẩy nhanh đổi mới AI: Sức mạnh của quyền truy cập mở

Từ các mô hình tiên tiến đến các ứng dụng cấp ...