Kiến trúc phần mềm cho Nền tảng Kore.ai XO

Giới thiệu

Kore.ai cung cấp sản phẩm AI đàm thoại dành cho doanh nghiệp dành cho các nhà khoa học dữ liệu và kỹ sư máy học để phát triển và xuất bản các ứng dụng AI. Nó có thể được triển khai trong Kubernetes dưới dạng nhóm hoặc dưới dạng vùng chứa độc lập. Tài liệu này cung cấp cái nhìn tổng quan về kiến trúc và các thành phần chính của nền tảng. Nó cũng mô tả cách doanh nghiệp có thể sử dụng từng phần để nâng cao và mở rộng chức năng của hệ thống hiện tại, tiếp cận nhiều khách hàng hơn, giúp nhân viên của họ làm việc dễ dàng hơn, chuyển từ giao diện người dùng sang UX đàm thoại và rút ngắn thời gian tạo ra giá trị.

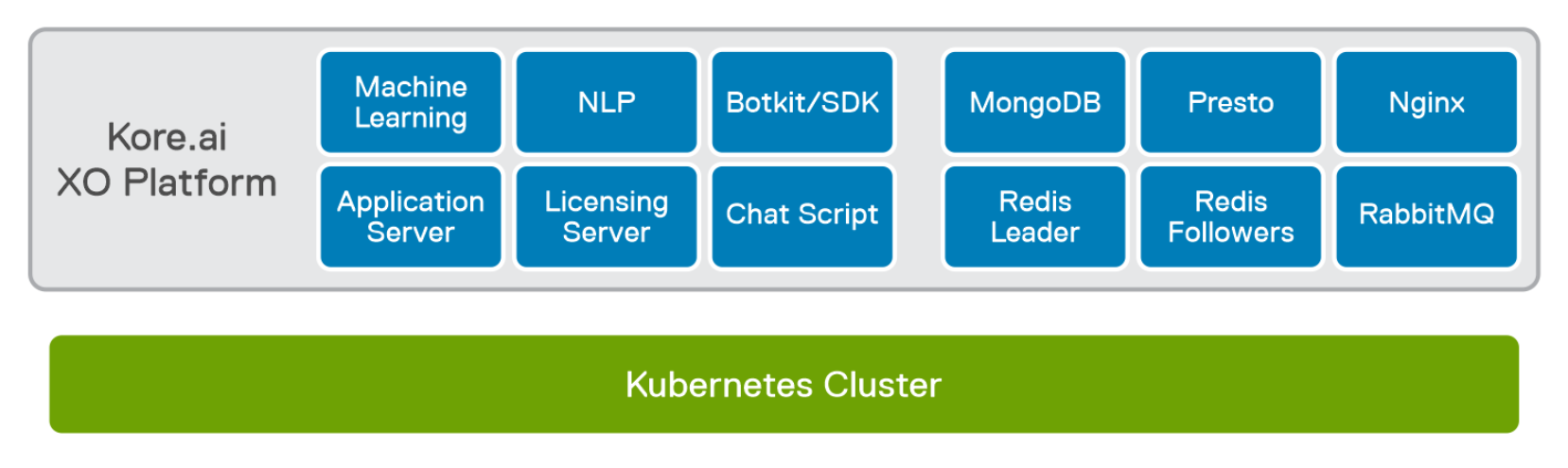

Hình 2. Kiến trúc phần mềm cho Nền tảng Kore.ai XO

Các thành phần chính của Nền tảng Kore.ai XO bao gồm:

- Máy chủ ứng dụng hiển thị các điểm cuối API REST cho các hệ thống con khác nhau của ứng dụng. API REST cung cấp các điểm cuối để lưu trữ các định nghĩa tác vụ và bot truy xuất, đồng thời quản lý thông tin ngữ cảnh, dịch vụ mã hóa, điểm cuối cho các kênh webhook, web và di động. Nó cho phép tích hợp với các kênh như Twilio, Alexa, Workplace for Facebook và trình nghe HTTP để xử lý các yêu cầu về IVR. Nó được phát triển bằng Nginx và Node.js

- Máy chủ IDProxy cung cấp bảo mật và xác thực bằng cách tích hợp SSO và OAuth. Nó hiển thị điểm cuối được định cấu hình làm URL gọi lại cho cả hai xác thực.

- Máy chủ RabbitMQ cung cấp Trình môi giới tin nhắn Giao thức xếp hàng tin nhắn nâng cao (AMQP) cho các hệ thống con nội bộ và liên lạc dịch vụ.

- Bot Service Runtime xử lý tin nhắn đến và gửi tin nhắn đi cho bot, kênh web và kênh di động. Nó cung cấp dịch vụ hẹn giờ độc lập để xử lý các tác vụ đã lên lịch và cảnh báo do người dùng định cấu hình.

- ChatScript là một công cụ NPL để xử lý các tin nhắn đến và xác định mục đích.

- Bots Service Admin là một dịch vụ độc lập lấy hồ sơ người dùng doanh nghiệp từ LDAP hoặc Active Directory và cập nhật chúng trong nền tảng Kore.ai. Nó cũng chạy các yêu cầu API cho các dịch vụ web phụ trợ.

- Hộp cát cung cấp môi trường thực thi JavaScript để chạy các tập lệnh do nhà phát triển cung cấp trong khi xử lý các mẫu thông báo và nút tập lệnh.

- Key Server là một máy chủ API quản lý việc mã hóa và giải mã khóa.

- Presto chịu trách nhiệm tìm nạp dữ liệu phân tích (bảng điều khiển và màn hình phân tích trong giao diện người dùng) và nhật ký kiểm tra.

- Machine Learning chịu trách nhiệm đào tạo mô hình bot và dự đoán ý định dựa trên mô hình được đào tạo.

- Công cụ Câu hỏi thường gặp có nhiệm vụ dự đoán câu trả lời cho các bộ sưu tập kiến thức.

- BotsServiceAlerts là dịch vụ xử lý và gửi tin nhắn được tạo bởi đăng ký tác vụ cảnh báo.

- ProcessFlowRuntime là một dịch vụ cung cấp môi trường để chạy các luồng mà nhà phát triển thiết kế.

- MongoDB cung cấp cơ sở dữ liệu cho Nền tảng XO.

Bảo vệ

Nền tảng Kore.ai XO tuân theo các nguyên tắc tiêu chuẩn và được thiết lập tốt về bảo mật và tuân thủ bất kể ngành nào.

Nền tảng này cung cấp mã hóa toàn bộ tin nhắn trợ lý ảo trên máy chủ. Tất cả dữ liệu ứng dụng còn lại trong cơ sở dữ liệu, Chỉ mục tìm kiếm và bộ lưu trữ SAN đều được mã hóa. Nền tảng này cũng cung cấp mã hóa toàn bộ tất cả các tin nhắn trợ lý ảo trong quá trình truyền tải. Nền tảng này sử dụng HTTPS qua Bảo mật lớp chuyển tiếp (TLS) bằng tiêu chuẩn AES 256.

Các giải pháp SSO tiêu chuẩn ngành được sử dụng để cấp cho người dùng được quản lý quyền truy cập an toàn vào cửa hàng ứng dụng doanh nghiệp của tổ chức và các ứng dụng sử dụng các nhà cung cấp danh tính hiện có.

Triển khai hình ảnh Docker và Helm

Các thành phần trước có sẵn dưới dạng hình ảnh Docker thông qua Kore.ai. Docker image được cài đặt thông qua Helm trên nền tảng Kubernetes.

Khối lượng liên tục

Kore.ai sử dụng các ổ đĩa liên tục để lưu dữ liệu cần thiết và kết nối với các nguồn dữ liệu bên ngoài như NFS.

PVC được tạo bằng cách sử dụng Block Storage cho các tập sau bằng lớp lưu trữ Kubernetes mặc định. Các đĩa mà ổ đĩa chạy trên đó phải có hiệu suất tối thiểu 1000 IOPS (hoặc cao hơn). Kore.ai khuyến nghị nên sử dụng ổ cứng thể rắn (SSD) khi có thể.

Bảng 1. Chi tiết khối lượng liên tục

|

Tên yêu cầu khối lượng liên tục |

Kích cỡ |

Chế độ truy cập |

Được sử dụng bởi |

|

chung |

30 GB |

RWX |

Tất cả các cấu hình triển khai |

|

mongodb-dữ liệu-mongodb-0 |

50GB |

RWO/RWX |

nhóm mongdb-0 |

|

mongodb-dữ liệu-mongodb-1 |

50GB |

RWO/RWX |

nhóm mongdb-1 |

|

mongodb-dữ liệu-mongodb-2 |

50GB |

RWO/RWX |

nhóm mongdb-2 |

|

redis-data-redis-0 |

50GB |

RWO/RWX |

nhóm redis-0 |

|

redis-data-redis-1 |

50GB |

RWO/RWX |

nhóm redis-1 |

|

redis-data-redis-2 |

50GB |

RWO/RWX |

nhóm redis-2 |

|

rabbitmq-data-rabbitmq-0 |

10 GB |

RWO/RWX |

nhóm thỏmq-0 |

|

rabbitmq-data-rabbitmq-1 |

10 GB |

RWO/RWX |

nhóm thỏmq-0 |

Cấu hình mạng

Kore.ai không yêu cầu cân nhắc đặc biệt về mạng. Việc triển khai dựa trên Kubernetes sử dụng bộ cân bằng tải và kiểm soát xâm nhập để quản lý quyền truy cập vào quá trình triển khai.

Cấp phép

Kore.ai cung cấp các tùy chọn định giá dựa trên mức sử dụng để phù hợp với nhu cầu của bạn. Giá cả có thể dựa trên yêu cầu hoặc phiên. Mọi tin nhắn nhận được từ người dùng cuối và thông báo chủ động do Trợ lý ảo gửi tới người dùng cuối đều được coi là yêu cầu. Phiên là cuộc trò chuyện giữa người dùng và Trợ lý ảo trong khoảng thời gian 15 phút hoặc cho đến khi kết thúc tương tác, tùy điều kiện nào đến trước. Một phiên có thể bao gồm số lượng tin nhắn bất kỳ từ người dùng cuối và Trợ lý ảo. Ngoài ra, Kore.ai còn cung cấp các gói tùy chỉnh cho các doanh nghiệp lớn có nhu cầu cụ thể. Liên hệ với đại diện bán hàng Dell của bạn để biết chi tiết về việc cấp phép sản phẩm Kore.ai.

AI đàm thoại trên cơ sở hạ tầng của Dell

Giới thiệu

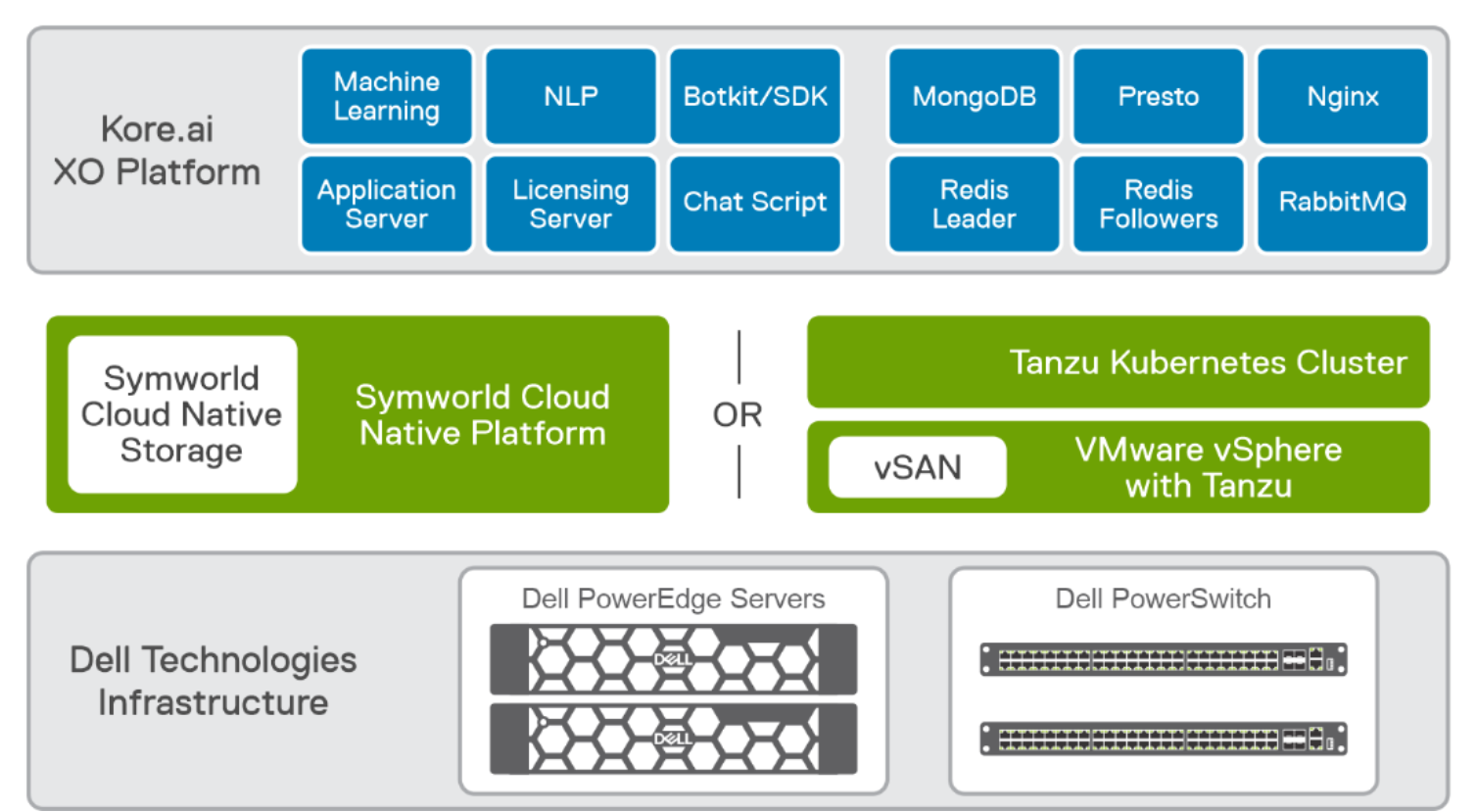

Dell Technologies đã hợp tác chặt chẽ với Kore.ai để cung cấp AI đàm thoại thông qua giải pháp được thiết kế và xác thực chung nhằm giúp các doanh nghiệp tận dụng lợi ích của việc hiểu ngôn ngữ tự nhiên được tối ưu hóa bằng AI. Chúng tôi đã xác thực Kore.ai trên Kubernetes với hai thiết kế đã được xác thực của chúng tôi:

- Thiết kế đã được xác thực cho AI với VMware, kết hợp VMware vSphere với Tanzu

- Thiết kế đã được xác thực cho Analytics—Data Lakehouse, kết hợp với Nền tảng gốc đám mây của Symworld

Hình 3. Thiết kế đã được xác thực cho AI – AI đàm thoại

Thiết kế được xác thực cho AI với VMware kết hợp cơ sở hạ tầng của Dell Technologies, VMware vSphere với Tanzu. Thiết kế đã được xác thực này là một nền tảng ảo hóa cho phép doanh nghiệp quản lý các cụm của cả vùng chứa Kubernetes theo yêu cầu cùng với các máy ảo truyền thống, cung cấp khả năng quản lý vòng đời hoàn chỉnh của các tài nguyên điện toán và lưu trữ đó. Thiết kế đã được xác thực này cũng bao gồm hỗ trợ cho GPU NVIDIA và NVIDIA AI Enterprise. Kore.ai không sử dụng GPU kể từ khi xuất bản tài liệu này.

Thiết kế đã được xác thực cho Analytics—Data Lakehouse kết hợp Nền tảng gốc đám mây của Symworld cho lớp Kubernetes. Symworld Cloud Native Storage cung cấp Lớp lưu trữ Kubernetes bằng cách khám phá các ổ đĩa được gắn vào máy chủ PowerEdge. Các ứng dụng yêu cầu Ổ đĩa liên tục sẽ sử dụng Lớp lưu trữ Kubernetes này.

Máy chủ PowerEdge cung cấp tài nguyên điện toán cho nền tảng Kore.ai XO. PowerSwitches cung cấp mạng. Bộ nhớ cục bộ trong các máy chủ PowerEdge, được cung cấp thông qua VMware vSAN hoặc Symworld Cloud Native Storage, đủ để cung cấp bộ nhớ cho Nền tảng Kore.ai XO.

Ngoài ra, các mô-đun bổ sung cho Nền tảng XO như Hỗ trợ tìm kiếm có thể yêu cầu quyền truy cập và sử dụng lượng lớn dữ liệu. Trong những trường hợp đó, chúng tôi khuyên bạn nên sử dụng Dell ECS để tương thích với S3 hoặc Dell PowerScale. Mặc dù không được xác thực rõ ràng như một phần của giải pháp này với các trường hợp sử dụng đã chọn, những phần mở rộng này và các phần mở rộng khác đối với kiến trúc có thể được coi là hỗ trợ nhiều trường hợp sử dụng hơn.

Lưu ý: Bạn có thể sử dụng các Thiết kế được Dell xác thực khác cho nền tảng container, bao gồm Red Hat OpenShift, với kết quả tương tự. Tuy nhiên, Dell Technologies chưa xác thực các nền tảng container này cho AI đàm thoại kể từ khi xuất bản sách trắng này.

Nền tảng Kore.ai XO

Giới thiệu

Phần này cung cấp các đề xuất về kích thước cho Nền tảng Kore.ai XO.

Xem xét một số yếu tố để xác định quy mô triển khai Nền tảng Kore.ai XO, chẳng hạn như số phiên trò chuyện đồng thời và số lượng tin nhắn trong phiên. Với thiết kế mô-đun và dịch vụ vi mô, Nền tảng Kore.ai XO có thể được mở rộng dễ dàng tùy theo yêu cầu của khách hàng.

Phiên hội thoại được định nghĩa là sự tương tác không bị gián đoạn giữa bot và người dùng. Người dùng bao gồm những khách hàng tương tác với Nền tảng Kore.ai XO và các đại lý sử dụng nền tảng này để được hỗ trợ. Các phiên này được sử dụng trong nhiều bảng điều khiển phân tích trong nền tảng Bot Builder và Bot Admin Console. Chúng được tạo ra cho mọi tương tác với trợ lý ảo.

Khuyến nghị về CPU và bộ nhớ

Kore.ai là một kiến trúc microservice với một số thành phần mô-đun như RabbitMQ, Redis, Presto và MongoDB. Mỗi thành phần này có thể được thu nhỏ dựa trên mức độ sử dụng. Các yêu cầu về CPU và bộ nhớ cho từng thành phần này được tổng hợp và cung cấp trong bang 2.

Yêu cầu lưu trữ

Kore.ai sử dụng các mô hình được đào tạo trước và công cụ quy tắc để xác định mục đích yêu cầu của người dùng. Không có bộ dữ liệu lớn nào phải được đào tạo nên không có yêu cầu lưu trữ đáng kể. Bộ lưu trữ flash cấp doanh nghiệp trong máy chủ PowerEdge đủ để đáp ứng yêu cầu IOP của Kore.ai.

Chúng tôi khuyên bạn nên triển khai ba kích thước cho thiết kế đã được xác thực của mình:

- Triển khai sản xuất tối thiểu —Việc triển khai sẵn sàng sản xuất ở quy mô tối thiểu được khuyến nghị cho các tổ chức đang bắt đầu triển khai AI đàm thoại để cải thiện tương tác giữa khách hàng và nhân viên.

- Triển khai chính thống —Việc triển khai chính thống được khuyến nghị cho các tổ chức đã thiết lập nhu cầu và trường hợp sử dụng trợ lý ảo. Các tổ chức này thường có lượng khách hàng lớn và bao gồm nhiều kênh để tương tác với người dùng cuối (chẳng hạn như trò chuyện trên web, thoại và mạng xã hội).

- Triển khai hiệu suất cao —Việc triển khai hiệu suất cao được khuyến nghị cho các doanh nghiệp lớn phục vụ khách hàng của họ thông qua giọng nói và trò chuyện (chẳng hạn như ngân hàng). Việc triển khai này bao gồm một số kênh để tương tác với người dùng cuối và hỗ trợ khách hàng thông qua hỗ trợ bằng giọng nói, IVR, SMS, email và tương tác trên web.

Bảng sau đây mô tả kích thước được đề xuất cho ba lần triển khai:

Bang 2. Kích thước được đề xuất cho Nền tảng Kore.ai XO

|

Triển khai |

Số phiên đồng thời |

Yêu cầu về CPU và bộ nhớ |

|

Sản xuất tối thiểu |

100 |

|

|

Xu hướng |

2000 |

|

|

Hiệu suất cao |

5500 |

|

Bài viết mới cập nhật

Thuần hóa sự hỗn loạn của công nghệ: Giải pháp phục hồi sáng tạo của Dell

Sự cố CNTT nghiêm trọng ảnh hưởng đến 8,5 triệu hệ ...

Dell PowerScale và Marvel hợp tác để tạo ra quy trình làm việc truyền thông tối ưu

Hiện đang ở thế hệ thứ 9, giải pháp lưu trữ Dell ...

Bảo mật PowerScale OneFS SyncIQ

Trong thế giới sao chép dữ liệu, việc đảm bảo tính ...

Danh sách kiểm tra cơ sở bảo mật PowerScale

Là một biện pháp bảo mật tốt nhất, chúng tôi khuyến ...