Tổng quan về công nghệ

VMware

VMware vSphere 8 bao gồm các tính năng sau để hỗ trợ khối lượng công việc AI và machine learning:

- Hỗ trợ thế hệ GPU mới nhất của NVIDIA, bao gồm hỗ trợ cho NVIDIA MIG dựa trên phân vùng không gian.

- Nâng cao hiệu suất liên lạc giữa thiết bị với thiết bị, dựa trên chức năng NVIDIA GPUDirect hiện có bằng cách bật Dịch vụ dịch địa chỉ (ATS) và Dịch vụ kiểm soát truy cập (ACS) ở lớp bus PCIe trong hạt nhân ESXi.

- Hỗ trợ các nhóm thiết bị để đào tạo đa GPU và đa nút. Nhóm thiết bị cho phép máy ảo sử dụng các thiết bị phần cứng bổ sung dễ dàng hơn. Các thiết bị GPU và NIC thông minh NVIDIA được hỗ trợ trong vSphere 8. Các nhóm thiết bị được thêm vào máy ảo bằng cách sử dụng quy trình Thêm thiết bị PCI mới hiện có . Các nhóm thiết bị hỗ trợ cấu hình tự động máy ảo và tạo các nút công nhân trong Tanzu. vSphere DRS và vSphere HA nhận biết các nhóm thiết bị và đặt máy ảo một cách thích hợp để đáp ứng nhóm thiết bị.

- Cấp phép VMware vSphere cho mỗi ổ cắm CPU. Giấy phép có sẵn cho các phiên bản sau:

- Tiêu chuẩn vSphere

- vSphere Enterprise Plus

- vSphere Essentials

- vSphere Essentials Plus

Thiết kế đã được xác thực này yêu cầu phiên bản vSphere Enterprise Plus. NVIDIA vGPU và các bộ chuyển mạch ảo phân tán (cần thiết để cân bằng tải trong Tanzu) yêu cầu phiên bản Enterprise Plus.

VMware vSphere với Tanzu

vSphere với Tanzu cho phép quản trị viên biến vSphere thành nền tảng để chạy khối lượng công việc Kubernetes ngay trên lớp ảo hóa. Khi được bật trên cụm vSphere, vSphere với Tanzu cung cấp khả năng chạy khối lượng công việc Kubernetes trực tiếp trên máy chủ ESXi và tạo các cụm Kubernetes ngược dòng trong nhóm tài nguyên chuyên dụng.

Quản trị viên vSphere có thể kích hoạt các cụm vSphere hiện có cho Quản lý khối lượng công việc để tạo cụm Tanzu Kubernetes trong máy chủ ESXi là một phần của cụm. Cụm Tanzu Kubernetes là bản phân phối đầy đủ của nền tảng điều phối vùng chứa Kubernetes mã nguồn mở do VMware xây dựng, ký kết và hỗ trợ. Tanzu Kubernetes Grid (TKG) cung cấp dịch vụ và vận hành cụm Tanzu Kubernetes trên vSphere.

Tanzu Kubernetes Grid (TKG), có sẵn với VMware vSphere 8, hỗ trợ ảo hóa GPU NVIDIA thông qua NVIDIA AI Enterprise. Với TKG, GPU ảo được tự động cung cấp và định cấu hình trên các nút công nhân của Tanzu Kubernetes Cluster và được cung cấp cho các bộ chứa khối lượng công việc AI.

VMware vSphere với Tanzu có thể được cấp phép thông qua vSphere+ hoặc Tanzu Kubernetes Operations. Để biết thêm thông tin, hãy xem So sánh dòng sản phẩm VMware vSphere và VMware Tanzu cho Tài liệu hoạt động Kubernetes .

Hệ sinh thái VMware Kubernetes

VMware cung cấp một số sản phẩm thuộc danh mục Tanzu để nâng cao khả năng của vSphere trên Tanzu. Những sản phẩm này cho phép quản trị viên xây dựng, chạy và quản lý khối lượng công việc AI cùng với các ứng dụng hiện đại và liên tục mang lại giá trị cho khách hàng. Tùy thuộc vào phiên bản Tanzu , các sản phẩm phần mềm này được đóng gói cùng với VMware vSphere với Tanzu và được VMware hỗ trợ đầy đủ. Một số sản phẩm chính có thể áp dụng cho thiết kế đã được xác nhận này bao gồm:

- Harbor —Một cơ quan đăng ký vùng chứa gốc trên nền tảng đám mây, mã nguồn mở, đáng tin cậy để lưu trữ, ký và quét nội dung. Harbor mở rộng phân phối Docker nguồn mở bằng cách thêm các chức năng như bảo mật, kiểm soát danh tính và quản lý.

- Tanzu Kubernetes Grid —Bao gồm các tệp nhị phân đã ký cho Harbor mà bạn có thể triển khai trên cụm dịch vụ dùng chung để cung cấp dịch vụ đăng ký vùng chứa cho các cụm Tanzu Kubernetes khác.

- Prometheus —Bộ công cụ cảnh báo và giám sát hệ thống nguồn mở. Prometheus thu thập và lưu trữ số liệu dưới dạng dữ liệu chuỗi thời gian, nghĩa là thông tin số liệu được lưu trữ cùng với dấu thời gian mà nó được ghi lại, cùng với các cặp khóa-giá trị tùy chọn. Tanzu Kubernetes Grid bao gồm các tệp nhị phân đã ký cho Prometheus mà bạn có thể triển khai trên các cụm Tanzu Kubernetes để theo dõi tình trạng và dịch vụ của cụm.

- Grafana —Phần mềm nguồn mở cho phép bạn trực quan hóa và phân tích dữ liệu số liệu do Prometheus thu thập trên cụm Tanzu Kubernetes. Tanzu Kubernetes Grid bao gồm gói Grafana mà bạn có thể triển khai trên các cụm.

- VMware NSX Advanced Load Balancer —NSX Advanced Load Balancer (trước đây gọi là Avi Networks) với Dịch vụ đám mây có cân bằng tải đa đám mây, tường lửa ứng dụng web và dịch vụ xâm nhập vùng chứa. Kiến trúc mở rộng quy mô, được xác định bằng phần mềm của NSX Advanced Load Balancer cung cấp khả năng tự động điều chỉnh theo yêu cầu của bộ cân bằng tải đàn hồi. Bộ cân bằng tải phần mềm phân tán và các ứng dụng phụ trợ có thể tăng hoặc giảm quy mô để đáp ứng việc giám sát lưu lượng truy cập theo thời gian thực.

NSX Advanced Load Balancer cung cấp khả năng truy cập mạng và cân bằng tải cho các cụm Tanzu Kubernetes. Bạn có thể sử dụng nó để cân bằng tải các trường hợp sử dụng AI, chẳng hạn như ứng dụng Vận hành máy học hoặc khối lượng công việc suy luận.

- Tanzu Mission Control —Một trung tâm tập trung để quản lý Kubernetes đơn giản, đa đám mây, đa cụm. Tanzu Mission Control cung cấp khả năng quản lý chính sách tập trung cho phép quản trị viên áp dụng các chính sách nhất quán, chẳng hạn như quyền truy cập và bảo mật, cho một nhóm cụm và không gian tên trên quy mô lớn. Nó cung cấp khả năng quản lý vòng đời cho các cụm Kubernetes cho phép quản trị viên cung cấp, mở rộng quy mô, nâng cấp và xóa các cụm Lưới Tanzu Kubernetes.

Phần mềm bổ sung sau đây có sẵn từ VMware để quản lý và điều phối khối lượng công việc của vùng chứa. Các công cụ phần mềm này giải quyết vấn đề phát triển ứng dụng có mục đích chung và không được xác thực như một phần của thiết kế đã được xác thực này.

- Nền tảng ứng dụng VMware Tanzu là một nền tảng nhận biết ứng dụng, mô-đun cung cấp một bộ công cụ phong phú dành cho nhà phát triển và một lộ trình sản xuất để xây dựng và triển khai phần mềm một cách nhanh chóng và an toàn trên mọi đám mây công cộng tuân thủ hoặc cụm Kubernetes tại chỗ.

- Khả năng quan sát của Tanzu cho phép giám sát Kubernetes với khả năng hiển thị toàn bộ các nút, nhóm và vùng chứa. Nó cung cấp cái nhìn sâu sắc tức thì về tình trạng nền tảng Dịch vụ ứng dụng Tanzu trên các nền tảng và tác động của mã trong quá trình sản xuất.

- Tanzu Service Mesh cung cấp khả năng kết nối, bảo mật và thông tin chuyên sâu, nâng cao, từ đầu đến cuối cho các ứng dụng hiện đại—trên người dùng cuối ứng dụng, vi dịch vụ, API và dữ liệu—cho phép tuân thủ Mục tiêu cấp độ dịch vụ cũng như các quy định về quyền riêng tư và bảo vệ dữ liệu.

- Danh mục ứng dụng VMware là một lựa chọn có thể tùy chỉnh gồm các thành phần ứng dụng nguồn mở được đóng gói sẵn, đáng tin cậy, được duy trì liên tục và được kiểm tra xác minh để sử dụng trong môi trường sản xuất.

- Tanzu Build Service tự động hóa việc tạo, quản lý và quản trị vùng chứa ở quy mô doanh nghiệp, đồng thời tăng cường bảo mật và giảm rủi ro từ việc tiếp xúc với lỗ hổng bảo mật thông thường.

Tanzu Data Services là danh mục phần mềm cơ sở dữ liệu, nhắn tin và bộ nhớ đệm theo yêu cầu trên VMware Tanzu dành cho các nhóm phát triển xây dựng các ứng dụng hiện đại.

VMware vSAN 8

vSAN là giải pháp lưu trữ được xác định bằng phần mềm của VMware, được xây dựng từ đầu cho máy ảo vSphere. Nó trừu tượng hóa và tổng hợp các ổ đĩa được gắn cục bộ trong cụm vSphere để tạo ra giải pháp lưu trữ mà bạn có thể cung cấp và quản lý từ vCenter và máy khách vSphere. vSAN được nhúng trong bộ ảo hóa, do đó, việc lưu trữ và điện toán cho máy ảo được phân phối từ cùng một nền tảng máy chủ x86 chạy bộ ảo hóa.

vSAN là công ty dẫn đầu thị trường về cơ sở hạ tầng HCI. Các ứng dụng truyền thống như Microsoft SQL Server và SAP HANA cũng như các ứng dụng thế hệ tiếp theo như khối lượng công việc AI có thể chạy trên vSAN. Các mô hình liên quan đến việc triển khai, vận hành và bảo trì cơ sở hạ tầng truyền thống bao gồm nhiều công cụ tách rời khác nhau và thường là các bộ kỹ năng chuyên biệt. Cách tiếp cận siêu hội tụ của vSphere và vSAN đơn giản hóa các tác vụ này bằng cách sử dụng các công cụ quen thuộc để triển khai, vận hành và quản lý cơ sở hạ tầng đám mây riêng.

Kiến trúc lưu trữ nhanh vSAN 8 (ESA) là cải tiến lớn mới nhất hiện có cho cụm vSphere 8. vSAN 8 ESA sử dụng hệ thống tệp được tối ưu hóa để tận dụng tối đa các thiết bị lưu trữ NVMe được chứng nhận và mạng 25 Gbps+ nhằm cải thiện đáng kể hiệu suất và dung lượng so với các phiên bản trước. vSAN 7 hiện được gọi là Kiến trúc lưu trữ gốc (OSA).

VMware vSAN được cấp phép cho mỗi ổ cắm CPU. Nó có sẵn trong các phiên bản sau: Standard, Advanced, Enterprise và Enterprise Plus. Đối với thiết kế đã được xác thực này, chúng tôi khuyên dùng giấy phép vSAN Enterprise. Cần có vSphere Enterprise Plus và VMware Tanzu Standard để sử dụng nền tảng Data Persistence. Nền tảng Data Persistence chỉ khả dụng trong vSAN Enterprise và Enterprise Plus.

NVIDIA

Doanh nghiệp trí tuệ nhân tạo NVIDIA

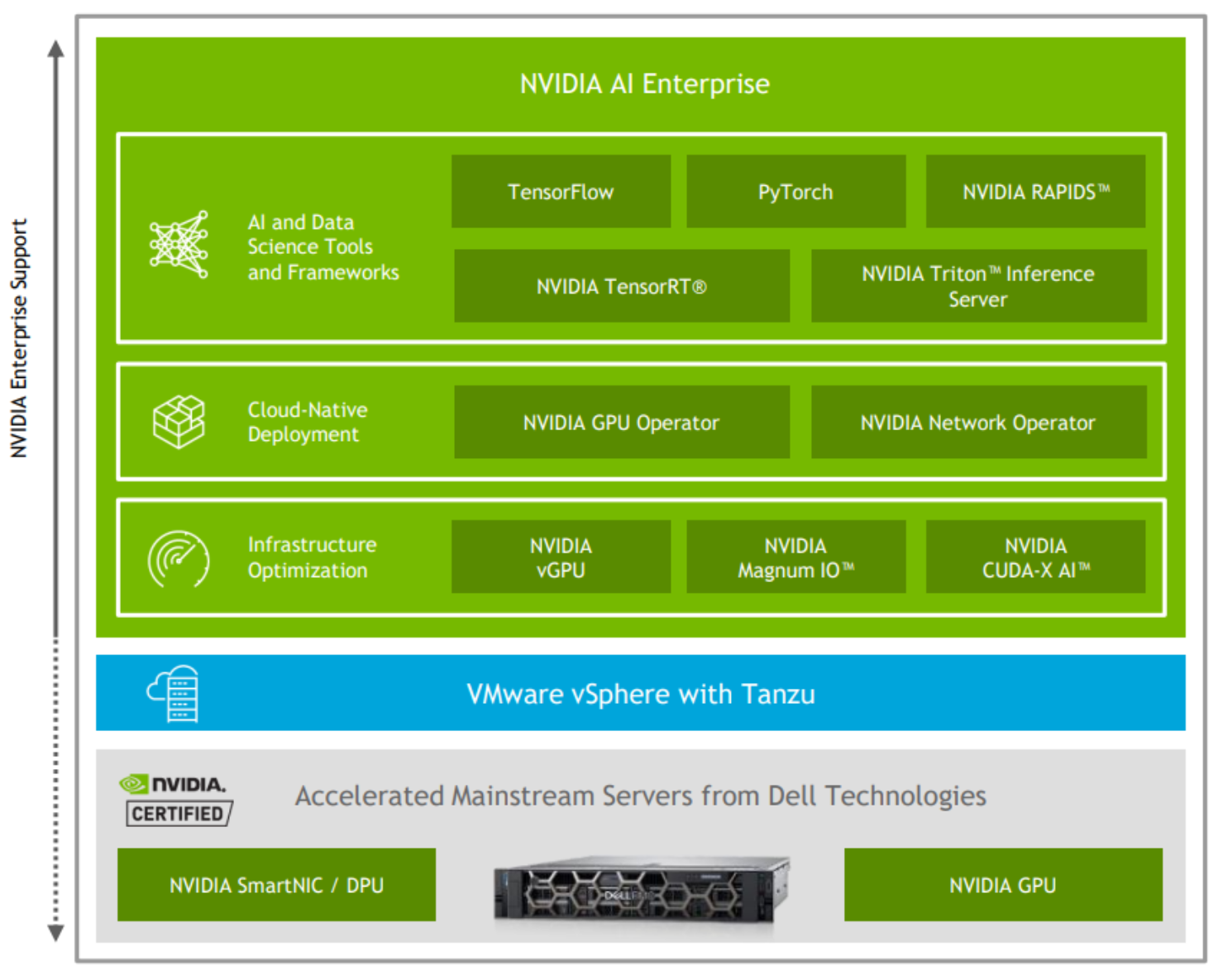

NVIDIA AI Enterprise là bộ phần mềm phân tích dữ liệu và AI gốc từ đầu đến cuối, dựa trên nền tảng đám mây. Nó được NVIDIA tối ưu hóa, chứng nhận và hỗ trợ để chạy độc quyền trên VMware vSphere với Hệ thống được NVIDIA chứng nhận, như minh họa trong hình sau:

Hình 2. NVIDIA AI Enterprise—bộ AI toàn diện

NVIDIA AI Enterprise bao gồm các công nghệ và phần mềm hỗ trợ chính của NVIDIA để triển khai, quản lý và mở rộng quy mô khối lượng công việc AI một cách nhanh chóng trong đám mây lai hiện đại. NVIDIA cấp phép và hỗ trợ NVIDIA AI Enterprise.

Phần mềm trong bộ NVIDIA AI Enterprise được tổ chức thành các lớp sau:

- Phần mềm tối ưu hóa cơ sở hạ tầng:

- NVIDIA vGPU —Phần mềm NVIDIA vGPU tạo ra các GPU ảo có thể được chia sẻ trên nhiều máy ảo, cho phép CNTT sử dụng các lợi ích quản lý và bảo mật của ảo hóa cũng như hiệu suất của GPU NVIDIA.

- Bộ công cụ NVIDIA CUDA —Bộ công cụ CUDA bao gồm các thư viện được tăng tốc GPU, các công cụ gỡ lỗi và tối ưu hóa, trình biên dịch C/C++ và thư viện thời gian chạy để xây dựng và triển khai ứng dụng AI của bạn.

- NVIDIA Magnum IO —Magnum IO stack chứa các thư viện mà nhà phát triển cần để tạo và tối ưu hóa ứng dụng IO trên toàn bộ ngăn xếp, bao gồm:

- Kết nối mạng trên NVIDIA NVLink

- Ethernet

- InfinBand

- API lưu trữ

- Tính toán trong mạng để tăng tốc hoạt động đa nút

- Quản lý IO của phần cứng mạng

- Phần mềm Triển khai Cloud-Native cần thiết để hỗ trợ VMware Tanzu:

- NVIDIA GPU Operator sử dụng khung toán tử trong Kubernetes để tự động hóa việc quản lý tất cả các thành phần phần mềm NVIDIA cần thiết để cung cấp GPU. Các thành phần này bao gồm trình điều khiển NVIDIA (để bật CUDA), plug-in thiết bị Kubernetes cho GPU, NVIDIA Container Runtime, ghi nhãn nút tự động, giám sát dựa trên DCGM và các thành phần khác.

- NVIDIA Network Operator sử dụng khung toán tử trong Kubernetes để quản lý các thành phần liên quan đến mạng nhằm hỗ trợ kết nối mạng, RDMA và GPUDirect nhanh chóng cho khối lượng công việc trong cụm Kubernetes. Nhà điều hành mạng làm việc với Nhà điều hành GPU để kích hoạt RDMA GPU-Direct trên các hệ thống tương thích.

- Khung khoa học dữ liệu và AI bao gồm các vùng chứa đã được xác thực sau trên VMware vSphere:

- NVIDIA RAPIDS là một khung học máy nguồn mở. RAPIDS mang lại khả năng tối ưu hóa GPU cho các vấn đề được giải quyết theo cách truyền thống bằng cách sử dụng các công cụ như Hadoop hoặc Scikit-learn và gấu trúc. RAPIDS là một công cụ hữu ích để làm việc với các định dạng dữ liệu dạng bảng và các định dạng dữ liệu khác; nó cũng là một công cụ thiết yếu để chuẩn bị dữ liệu, định dạng dữ liệu và ghi nhãn dữ liệu. RAPIDS là thành phần quan trọng để bắt đầu bất kỳ quy trình AI nào yêu cầu xử lý trước dữ liệu.

- TensorFlow là một framework mã nguồn mở dành cho machine learning được triển khai bằng sự kết hợp giữa các công cụ C++ và NVIDIA CUDA. Được phát triển lần đầu tiên bởi Google, nó đã trở thành một công cụ phổ biến để học sâu kể từ khi ra mắt vào năm 2015. Bộ chứa TensorFlow được cung cấp có hỗ trợ đầy đủ cho GPU, cũng như các khả năng đa GPU và đa nút cùng với khả năng tối ưu hóa GPU đã được NVIDIA thử nghiệm.

- PyTorch là một Khung học tập sâu Python mã nguồn mở. Facebook đã tạo ra PyTorch, giống như Tensorflow, là một framework AI hàng đầu. Các bộ chứa PyTorch được xuất bản thông qua NVIDIA AI Enterprise bao gồm phần mềm cần thiết để chạy khối lượng công việc GPU đơn, đa GPU hoặc đa nút.

- NVIDIA TensorRT chuyển đổi các mô hình được phát triển trong các khung như TensorFlow và PyTorch bằng cách biên dịch chúng thành định dạng được tối ưu hóa để suy luận trên nền tảng thời gian chạy cụ thể. Khi biên dịch một mô hình bằng TensorRT, các tính năng bao gồm tối ưu hóa độ chính xác bit, tối ưu hóa đồ thị mạng thần kinh và điều chỉnh tự động sẽ mang lại một mô hình suy luận hiệu quả hơn. Lợi ích về hiệu suất có thể đáng kể tùy thuộc vào loại mô hình đang được phát triển. Nói chung, các mô hình được biên dịch bằng TensorRT chiếm ít bộ nhớ hơn và thực hiện các tác vụ suy luận nhanh hơn định dạng ban đầu.

- NVIDIA Triton Inference Server là phần mềm phục vụ mô hình nguồn mở giúp đơn giản hóa việc triển khai các mô hình AI sản xuất trên quy mô lớn. Nó cho phép các nhóm triển khai các mô hình AI đã được đào tạo từ bất kỳ khung nào, bao gồm các mô hình TensorRT được tối ưu hóa trên bất kỳ cơ sở hạ tầng dựa trên GPU, đa GPU hoặc CPU nào. Khi các mô hình được đào tạo lại, nhân viên CNTT có thể dễ dàng triển khai các bản cập nhật mà không cần khởi động lại máy chủ suy luận hoặc làm gián đoạn ứng dụng gọi điện. Triton hỗ trợ nhiều loại suy luận bao gồm thời gian thực, hàng loạt và truyền phát. Nó cũng hỗ trợ các tổ hợp mô hình hiệu quả nếu quy trình của bạn có nhiều mô hình chia sẻ đầu vào và đầu ra, chẳng hạn như trong AI đàm thoại.

Cấp phép và hỗ trợ doanh nghiệp

NVIDIA AI Enterprise được cấp phép cho mỗi ổ cắm CPU và có thể được mua thông qua Phần mềm & Thiết bị ngoại vi của Dell. Bạn có thể mua các sản phẩm NVIDIA AI Enterprise dưới dạng giấy phép vĩnh viễn với các dịch vụ hỗ trợ hoặc dưới dạng đăng ký hàng năm hoặc nhiều năm. Giấy phép vĩnh viễn cung cấp quyền sử dụng phần mềm NVIDIA AI Enterprise vô thời hạn, không hết hạn. Bạn phải mua NVIDIA AI Enterprise với giấy phép vĩnh viễn với các dịch vụ hỗ trợ một năm, ba năm hoặc năm năm. Dịch vụ hỗ trợ một năm cũng có sẵn để gia hạn. Để biết thêm thông tin, hãy xem Hướng dẫn đóng gói, định giá và cấp phép dành cho doanh nghiệp NVIDIA AI .

Dịch vụ Hỗ trợ NVIDIA dành cho bộ phần mềm NVIDIA AI Enterprise cung cấp khả năng truy cập liền mạch vào các bản vá, cập nhật, nâng cấp và hỗ trợ kỹ thuật toàn diện về phần mềm.

GPU NVIDIA Ampe

Công nghệ Tensor Core trong kiến trúc Ampere đã mang lại hiệu suất tăng đáng kể cho khối lượng công việc AI. Thử nghiệm quy mô lớn và nghiên cứu điển hình về khách hàng chứng minh rằng GPU Ampere dựa trên Tensor Core có thể giảm đáng kể thời gian đào tạo. Hai loại GPU Ampere có sẵn cho khối lượng công việc điện toán:

- GPU NVIDIA A100 —GPU Tensor Core này có thể đạt được khả năng tăng tốc lớn cho khối lượng công việc đào tạo. Các chuyên gia CNTT được hưởng lợi từ việc giảm độ phức tạp trong vận hành bằng cách sử dụng một công nghệ duy nhất dễ dàng tích hợp và quản lý cho các trường hợp sử dụng này. GPU A100 là thẻ Gen4 PCI Express (PCIe) 10,5 inch hai khe cắm dựa trên GPU NVIDIA Ampere A100. Nó sử dụng tản nhiệt thụ động để làm mát. A100 PCIe hỗ trợ các tác vụ tính toán có độ chính xác kép (FP64), độ chính xác đơn (FP32) và độ chính xác một nửa (FP16). Nó cũng hỗ trợ bộ nhớ ảo hợp nhất và công cụ di chuyển trang.

- GPU NVIDIA A30 —GPU Tensor Core này là GPU điện toán phổ thông linh hoạt nhất dành cho suy luận AI và khối lượng công việc phổ thông của doanh nghiệp. Nó hỗ trợ nhiều phép toán chính xác, cung cấp một bộ tăng tốc duy nhất để đẩy nhanh mọi khối lượng công việc. Được xây dựng để suy luận AI trên quy mô lớn, cùng một tài nguyên điện toán có thể nhanh chóng đào tạo lại các mô hình AI bằng TF32, cũng như tăng tốc các ứng dụng điện toán hiệu năng cao (HPC) bằng cách sử dụng Lõi Tensor FP64. Lõi Tensor MIG và FP64 kết hợp với băng thông bộ nhớ nhanh 933 GB/s trong mức công suất thấp 165 W, tất cả đều chạy trên thẻ PCIe tối ưu cho các máy chủ phổ thông.

GPU A100 và A30 hỗ trợ tính năng MIG, cho phép quản trị viên phân vùng một GPU thành nhiều phiên bản, mỗi phiên bản được cách ly hoàn toàn với bộ nhớ, bộ đệm và điện toán băng thông cao riêng. Thẻ PCIe A100 hỗ trợ cấu hình MIG với tối đa bảy phiên bản GPU trên mỗi GPU A100, trong khi GPU A30 hỗ trợ tối đa bốn phiên bản GPU. Để biết thêm thông tin, hãy xem phần về GPU ảo trong hướng dẫn thiết kế GPU ảo hóa cho AI với VMware và NVIDIA .

ConnectX SmartNIC

ConnectX-6 Dx SmartNIC là thẻ giao diện mạng đám mây an toàn và tiên tiến giúp tăng tốc các ứng dụng trung tâm dữ liệu quan trọng như ảo hóa, SDN/NFV, dữ liệu lớn, máy học, bảo mật mạng và lưu trữ. ConnectX-6 hỗ trợ Truy cập bộ nhớ trực tiếp từ xa (RDMA) qua Ethernet hội tụ (RoCE), giao thức mạng cần thiết để đào tạo nhiều nút với GPUDirect RDMA. Trong thiết kế đã được xác thực này, chúng tôi sử dụng ConnectX-6 Lx cho kết nối Ethernet 25 Gb/s và tùy chọn ConnectX-6 Dx cho kết nối Ethernet 100 Gb/s.

Hệ thống được NVIDIA chứng nhận

Để thành công với các sáng kiến máy học và AI, doanh nghiệp cần có cơ sở hạ tầng điện toán mạch lạc hiện đại, cung cấp chức năng, hiệu suất, bảo mật và khả năng mở rộng. Các tổ chức cũng được hưởng lợi khi họ có thể thực hiện cả khối lượng công việc phát triển và sản xuất bằng công nghệ phổ biến. Với Hệ thống được chứng nhận NVIDIA từ Dell Technologies, doanh nghiệp có thể tự tin lựa chọn phần cứng được tối ưu hóa hiệu suất chạy các giải pháp phần mềm VMware và NVIDIA—tất cả đều được hỗ trợ bởi sự hỗ trợ cấp doanh nghiệp.

Dell Technologies sản xuất nhiều loại máy chủ PowerEdge đủ tiêu chuẩn là Hệ thống được NVIDIA chứng nhận. Các hệ thống được NVIDIA chứng nhận được trang bị GPU NVIDIA Ampere A100 và A30 Tensor Core cũng như bộ điều hợp mạng NVIDIA Mellanox ConnectX-6 mới nhất.

Một nhóm nhỏ Hệ thống được NVIDIA chứng nhận sẽ trải qua chứng nhận bổ sung, bao gồm chứng nhận GPU VMware, để đảm bảo khả năng tương thích với NVIDIA AI Enterprise. Hệ thống được NVIDIA chứng nhận tương thích với NVIDIA AI Enterprise tuân thủ các phương pháp thiết kế tốt nhất của NVIDIA và đã vượt qua các bài kiểm tra chứng nhận nhằm giải quyết nhiều trường hợp sử dụng trên cơ sở hạ tầng VMware vSphere. Các trường hợp sử dụng này bao gồm đào tạo deep learning, suy luận AI, thuật toán khoa học dữ liệu, phân tích video thông minh, bảo mật cũng như giảm tải mạng và lưu trữ cho cả cụm nút đơn và cụm đa nút.

Công nghệ Dell

Máy chủ Dell PowerEdge

Các máy chủ Dell PowerEdge mới nhất được chứng nhận cho VMware vSphere 8 và vSAN 8. Các máy chủ dựa trên PowerEdge Intel sử dụng bộ xử lý Intel Xeon Scalable thế hệ thứ 4 mới nhất. Các tính năng chính khác bao gồm:

- Intel Advanced Vector Extensions 512 (Intel AVX-512), có thể tăng tốc quá trình học máy cổ điển và các khối lượng công việc khác trong quy trình làm việc AI từ đầu đến cuối, chẳng hạn như chuẩn bị dữ liệu. Nó có thể tăng tốc khối lượng công việc trong bộ nhớ với tối đa 32 DDR5 RDIMMS với tốc độ lên tới 4800 MT/giây, sử dụng tám kênh bộ nhớ cho mỗi CPU

- Hỗ trợ hai GPU có chiều rộng gấp đôi hoặc sáu GPU có chiều rộng đơn cho khối lượng công việc cần tăng tốc

- Các tùy chọn lưu trữ bao gồm các tùy chọn SAS3/SAS4/SATA và NVMe Gen4/NVME Gen5

- Nhiều cấu hình Riser Gen4 và Gen5

Các máy chủ dựa trên PowerEdge AMD sử dụng bộ xử lý EPYC thế hệ thứ 4 mới nhất Bộ xử lý AMD EPYC thế hệ thứ 4. Các tính năng chính khác bao gồm:

- Hiệu suất thế hệ được nâng cao mạnh mẽ trên nhiều khối lượng công việc và thể hiện hiệu suất chuẩn TPCx-AI dẫn đầu.

- Tăng tốc khối lượng công việc trong bộ nhớ với tối đa 24 DDR5 RDIMMS với tốc độ lên tới 4800 MT/giây, sử dụng tối đa 12 kênh bộ nhớ cho mỗi CPU

- Hỗ trợ GPU bao gồm 2 x chiều rộng đôi hoặc 6 x chiều rộng đơn cho khối lượng công việc cần tăng tốc

- Các tùy chọn lưu trữ bao gồm SAS3/SAS4/SATA, NVMe Gen4/NVME Gen5

- Nhiều cấu hình Riser Gen4 và Gen5

Bảng sau liệt kê các máy chủ PowerEdge được hỗ trợ bởi NVIDIA AI Enterprise và số lượng GPU Ampere được hỗ trợ với từng kiểu máy chủ:

Bảng 2. Máy chủ PowerEdge được hỗ trợ

Các máy chủ PowerEdge này là Hệ thống được NVIDIA chứng nhận và đã được chứng minh thông qua một loạt các bài kiểm tra hiệu suất và chức năng nghiêm ngặt. Kết quả thử nghiệm xác nhận rằng các máy chủ này có thể mang lại hiệu suất cao cả trong các điểm chuẩn suy luận và huấn luyện cụm đa nút đơn nút và nối mạng. Ngoài ra, các máy chủ này còn được chứng nhận tương thích với NVIDIA AI Enterprise thông qua thử nghiệm và xác nhận bổ sung.

Bộ lưu trữ Dell PowerScale

Bộ lưu trữ PowerScale giúp mở khóa cấu trúc trong dữ liệu và giải quyết các thách thức của việc quản lý dữ liệu phi cấu trúc. PowerScale là sự phát triển tiếp theo của OneFS—hệ điều hành hỗ trợ nền tảng NAS mở rộng quy mô. Họ PowerScale bao gồm các nút Dell Isilon và các nút PowerScale, với PowerScale OneFS chạy trên tất cả chúng. Kiến trúc được xác định bằng phần mềm của OneFS mang lại sự đơn giản ở quy mô lớn, thông tin chi tiết thông minh và khả năng có dữ liệu ở bất kỳ nơi nào cần thiết. Cho dù lưu trữ chia sẻ tệp hay thư mục chính hay cung cấp quyền truy cập dữ liệu hiệu suất cao cho các ứng dụng như phân tích, kết xuất video và khoa học đời sống, PowerScale có thể mở rộng hiệu suất, công suất và hiệu quả một cách liền mạch để xử lý mọi khối lượng công việc dữ liệu phi cấu trúc.

Trong thiết kế đã được xác thực này, chúng tôi sử dụng PowerScale làm bộ lưu trữ cho hồ dữ liệu—kho lưu trữ dữ liệu cho dữ liệu phi cấu trúc mà bạn có thể sử dụng để đào tạo mạng thần kinh. Bộ lưu trữ NAS mở rộng quy mô PowerScale All-Flash là giải pháp lý tưởng, mang lại hiệu suất phân tích và khả năng xử lý đồng thời cực cao trên quy mô lớn để cung cấp nhất quán các thuật toán học sâu ngốn nhiều dữ liệu nhất.

GPUDirect Storage, một công nghệ của NVIDIA, cho phép đường dẫn dữ liệu trực tiếp giữa bộ nhớ cục bộ hoặc từ xa, như NVMe hoặc NVMe qua Fabric (NVMe-oF) và bộ nhớ GPU. GPUDirect Storage tránh các bản sao bổ sung thông qua bộ đệm thoát trong bộ nhớ CPU. Nó cho phép công cụ truy cập bộ nhớ trực tiếp (DMA) gần bộ lưu trữ di chuyển dữ liệu trên đường dẫn trực tiếp vào hoặc ra khỏi bộ nhớ GPU – tất cả đều không gây gánh nặng cho CPU hoặc GPU. PowerScale hỗ trợ Lưu trữ trực tiếp GPU.

Bộ lưu trữ Dell PowerStore

PowerStore là một thiết bị lưu trữ hiện đại được thiết kế cho kỷ nguyên dữ liệu. Kiến trúc duy nhất của PowerStore cho khối, tệp và VMware vVols sử dụng các công nghệ mới nhất để hỗ trợ nhiều khối lượng công việc truyền thống và hiện đại ở cấp độ doanh nghiệp – từ cơ sở dữ liệu quan hệ, đến các ứng dụng ERP và EMR, ứng dụng gốc trên đám mây và khối lượng công việc dựa trên tệp như như kho nội dung và thư mục chính. Khả năng đáp ứng ứng dụng, mạng đa giao thức và tính đa dạng lưu trữ đa định dạng (khối lượng vật lý và ảo, bộ chứa và tệp truyền thống) trong một thiết bị 2U duy nhất mang lại sự linh hoạt cho phép kinh doanh và giúp CNTT đơn giản hóa và củng cố cơ sở hạ tầng của họ.

Quản trị viên có thể chọn triển khai PowerStoreOS ở cấu hình cơ bản trực tiếp trên phần cứng PowerStore hoặc trong VM chạy trên bộ ảo hóa VMware tích hợp tùy chọn của PowerStore, cung cấp thêm một lớp cách ly, thông minh và trừu tượng hóa khác.

Công tắc Dell PowerSwitch

Trong thiết kế đã được xác thực này, chúng tôi sử dụng các thiết bị chuyển mạch Dell sau:

- Công tắc PowerSwitch S5232F-ON cho kết nối mạng 100 GbE. Bằng cách sử dụng bộ chuyển mạch S5332F-ON, bạn có thể xây dựng cấu trúc lá/cột sống của trung tâm dữ liệu hiệu suất cao, tiết kiệm chi phí với các cổng 32 x 100 GbE QSFP28. Nó hỗ trợ Môi trường cài đặt mạng mở (ONIE) để cài đặt hệ điều hành mạng mà không cần chạm.

- Công tắc PowerSwitch S5248F-ON cho kết nối mạng 25 GbE. Nó có 48 x 25 GbE SFP28 cổng, 4 x 100 GbE QSFP28 cổng và 2 x 100 GbE QFSP28-DD cổng. Nó hỗ trợ ONIE để cài đặt hệ điều hành mạng mà không cần chạm.

- Bộ chuyển đổi PowerSwitch N3248TE-ON hoặc PowerSwitch S4148T cho kết nối ngoài băng tần (OOB) 1 GbE.

Giải pháp xây dựng

Bản tóm tắt

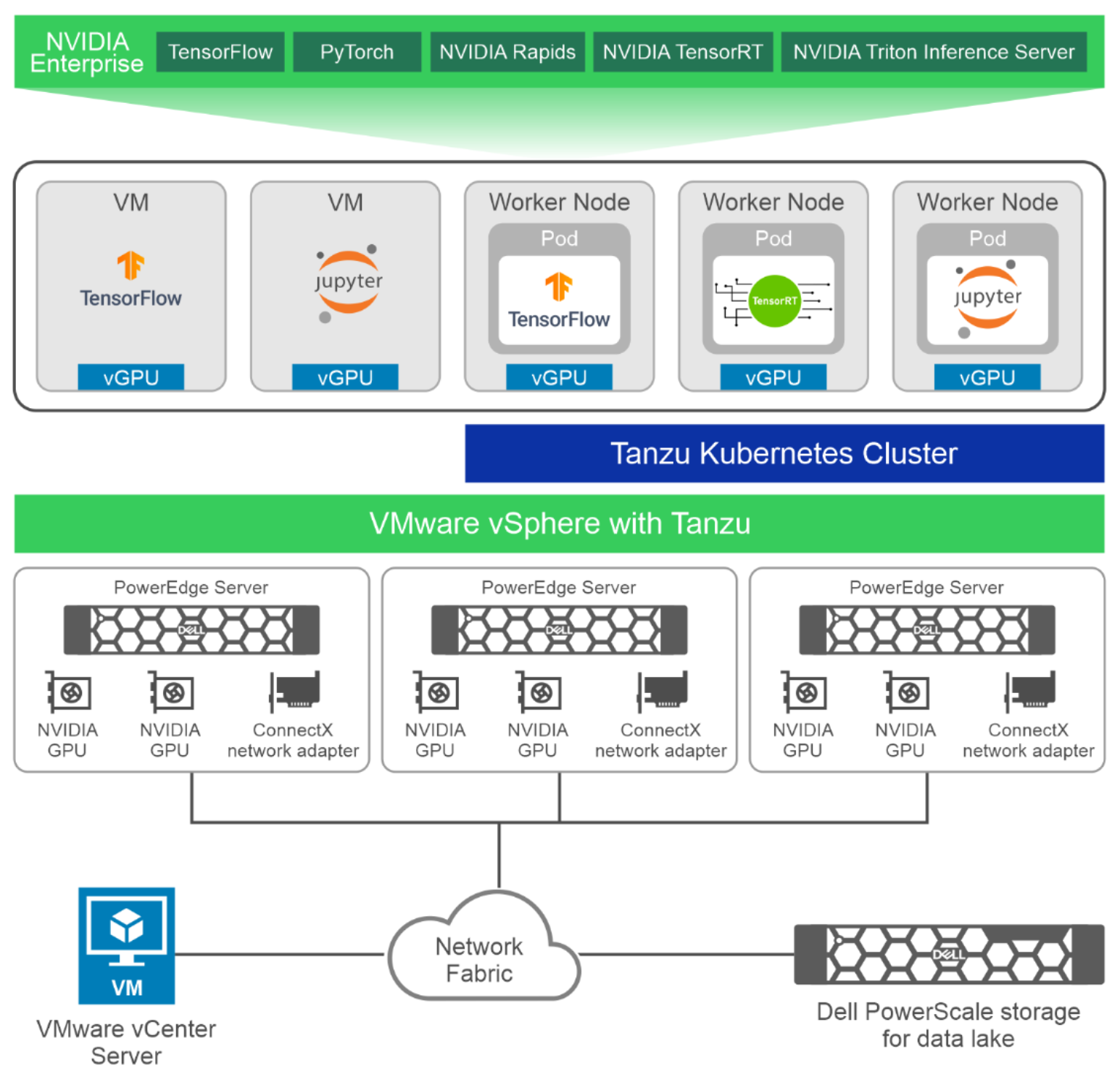

Với sự hỗ trợ của VMware vSphere cho GPU ảo hóa, quản trị viên CNTT có thể chạy khối lượng công việc AI như đào tạo mạng thần kinh, suy luận hoặc phát triển mô hình cùng với các ứng dụng trung tâm dữ liệu tiêu chuẩn của họ. Hình dưới đây cho thấy kiến trúc cấp cao cho thiết kế đã được xác thực này với các máy chủ PowerEdge R760, mỗi máy chủ có hai GPU NVIDIA A100 và bộ điều hợp mạng ConnectX, như một phần của cụm VMware vSphere. Các máy ảo có vGPU chạy các bộ chứa từ NVIDIA AI Enterprise. Thiết kế đã được xác thực này cho phép khối lượng công việc AI chạy dưới dạng nhóm VM hoặc Kubernetes trong cụm Tanzu Kubernetes.

Hình 3. Kiến trúc cấp cao với máy chủ PowerEdge R760 và bộ lưu trữ PowerScale

Các khía cạnh chính của thiết kế được xác nhận này bao gồm:

- Máy chủ điện toán —Các máy chủ PowerEdge R760 và R7625 là một phần của thiết kế đã được xác thực này.

- GPU —GPU NVIDIA A100 và A30 có thể được sử dụng cho AI và machine learning. Chúng tôi khuyên dùng GPU A100 cho các mô hình đào tạo mạng thần kinh lớn đòi hỏi hiệu năng cao và GPU A30 cho suy luận AI và khối lượng công việc phổ thông của doanh nghiệp. Số lượng GPU được hỗ trợ trong một máy chủ tùy thuộc vào kiểu máy chủ như trong Bảng 2 .

- Bộ lưu trữ —vSAN là bộ lưu trữ được khuyến nghị cho máy ảo. Chúng tôi khuyên bạn nên lưu trữ PowerStore để lưu trữ hồ dữ liệu, nghĩa là lưu trữ dữ liệu cần thiết cho quá trình đào tạo mạng thần kinh. Bộ lưu trữ PowerScale cũng có thể được sử dụng để lưu trữ dữ liệu cho khối lượng công việc AI trong phân vùng NFS.

- Cơ sở hạ tầng mạng —Khách hàng có thể có cơ sở hạ tầng mạng Ethernet 25 Gb hoặc cơ sở hạ tầng mạng Ethernet 100 Gb. Chúng tôi khuyên dùng 25 GbE cho khối lượng công việc có thể sử dụng cơ sở hạ tầng mạng hiện có mà không cần đầu tư vào cơ sở hạ tầng mạng 100 Gb. Thiết kế này phù hợp với các công việc đào tạo mạng thần kinh có thể chạy trên một nút duy nhất (sử dụng tối đa hai GPU) cũng như cho các công việc phát triển mô hình và suy luận tận dụng khả năng phân vùng GPU.

Chúng tôi khuyên dùng 100 GbE cho khối lượng công việc yêu cầu đào tạo mô hình quy mô lớn bằng cách sử dụng tập dữ liệu lớn (thường là tập dữ liệu dựa trên hình ảnh hoặc video có độ phân giải cao).

- Ảo hóa và điều phối vùng chứa —GPU có thể được ảo hóa và cung cấp cho các máy ảo chạy trên máy chủ VMware ESXi được triển khai trên máy chủ PowerEdge. Đối với khối lượng công việc được đóng gói, dịch vụ Tanzu Kubernetes Grid được bật trên cụm vSphere. Các nút công nhân Kubernetes có thể được tạo bằng tài nguyên GPU ảo. Khối lượng công việc AI có thể được triển khai dưới dạng nhóm trên các dịch vụ triển khai chạy trên cụm Tanzu Kubernetes.

- Quản lý bằng VMware vCenter —VMware vCenter Server có thể được triển khai dưới dạng VM trong trung tâm dữ liệu của bạn. vCenter rất quan trọng đối với việc triển khai, vận hành và bảo trì môi trường vSAN. Vì lý do này, Dell Technologies khuyến nghị nên triển khai vCenter trên cụm quản lý có tính sẵn sàng cao, tồn tại bên ngoài cụm điện toán.

Để biết thêm thông tin về thiết kế đã được xác thực, bao gồm các cấu hình chi tiết được đề xuất, các cân nhắc về thiết kế và tổng quan về triển khai, hãy xem hướng dẫn thiết kế Ảo hóa GPU cho AI với VMware và NVIDIA .

Kết quả xác nhận

Bản tóm tắt

Dựa trên kiến trúc được mô tả trong sách trắng này, nhóm Giải pháp Tích hợp Dell đã sử dụng Phòng thí nghiệm Đổi mới HPC & AI của Dell Technologies để tiến hành các nghiên cứu xác thực và hiệu suất của GPU ảo hóa trên VMware vSphere.

Chúng tôi cũng mô tả hiệu suất của MIG bằng cách sử dụng cả suy luận và đào tạo mô hình ResNet. Kết quả cũng cho thấy mức sử dụng GPU tăng lên khi sử dụng phân vùng GPU cho khối lượng công việc, chẳng hạn như suy luận, không yêu cầu toàn bộ GPU.

Các chuyên gia khoa học dữ liệu đã vượt qua các giới hạn của cơ sở hạ tầng CNTT và tạo ra môi trường CNTT ngầm trong nhiều năm. Dell Technologies, VMware và NVIDIA đã đáp ứng bằng nhiều cải tiến về tính toán, tùy chọn lưu trữ dữ liệu và kết nối mạng tốc độ cao để đáp ứng thách thức đó bằng các giải pháp tích hợp đầy đủ. Trong sách trắng này, chúng tôi trình bày cách bạn có thể quản lý những tiến bộ này trong công nghệ phần cứng hiệu quả hơn, đồng thời duy trì mức tăng hiệu suất ấn tượng trong môi trường ảo hóa bằng phiên bản mới nhất của phần mềm ảo hóa VMware.

Không nơi nào có những tiến bộ về hiệu suất cho khoa học dữ liệu nhanh bằng sự phát triển của các bộ tăng tốc phần cứng dựa trên công nghệ từng được sử dụng chủ yếu để xử lý đồ họa. Thế hệ GPU Ampere mới nhất của NVIDIA cung cấp hiệu suất cao hơn tới 20 lần so với thế hệ GPU NVIDIA trước đó. GPU NVIDIA A100 có thể được phân vùng lên đến bảy phiên bản GPU để tự động điều chỉnh theo nhu cầu thay đổi. Với bộ phần mềm NVIDIA AI Enterprise, các nhà khoa học dữ liệu có các công cụ và khuôn khổ phù hợp cho toàn bộ vòng đời khoa học dữ liệu của họ.

Thiết kế được xác thực của Dell để ảo hóa GPU cho AI với VMware và NVIDIA cung cấp sự kết hợp giữa GPU ảo hóa, phần mềm doanh nghiệp AI và điều phối vùng chứa cung cấp cho các chuyên gia CNTT các công cụ và quy trình nhất quán để quản lý toàn bộ trung tâm dữ liệu của họ, đồng thời cho phép nhà khoa học dữ liệu tập trung vào chuẩn bị dữ liệu và phát triển mô hình mà không cần lo lắng về cơ sở hạ tầng.

Bài viết mới cập nhật

Thuần hóa sự hỗn loạn của công nghệ: Giải pháp phục hồi sáng tạo của Dell

Sự cố CNTT nghiêm trọng ảnh hưởng đến 8,5 triệu hệ ...

Dell PowerScale và Marvel hợp tác để tạo ra quy trình làm việc truyền thông tối ưu

Hiện đang ở thế hệ thứ 9, giải pháp lưu trữ Dell ...

Bảo mật PowerScale OneFS SyncIQ

Trong thế giới sao chép dữ liệu, việc đảm bảo tính ...

Danh sách kiểm tra cơ sở bảo mật PowerScale

Là một biện pháp bảo mật tốt nhất, chúng tôi khuyến ...