Kiến trúc giải pháp của DELL và NVIDIA

Kiến trúc cấp cao

Dell Technologies và NVIDIA đã dẫn đầu trong việc cung cấp những đổi mới chung cho AI và điện toán hiệu năng cao trong nhiều năm. Với dự án này, chúng tôi đã cùng nhau thiết kế một giải pháp tập trung vào quy trình công việc đầy đủ cho phép các doanh nghiệp tạo và chạy các mô hình AI tổng quát ở mọi quy mô—từ thử nghiệm AI đến sản xuất AI.

Kiến trúc là mô-đun, có thể mở rộng và cân bằng hiệu suất với hiệu quả. Tính mô-đun cho phép kiến trúc hỗ trợ nhiều quy trình công việc AI khác nhau, như được giải thích trong các phần sau.

Tinh thần mô đun

Nền tảng của kiến trúc chung này là tính mô-đun, cung cấp một thiết kế linh hoạt phục vụ cho vô số trường hợp sử dụng, lĩnh vực và yêu cầu tính toán. Cơ sở hạ tầng AI thực sự theo mô-đun được thiết kế để có thể thích ứng và phù hợp với tương lai, với các thành phần có thể được kết hợp và kết hợp dựa trên các yêu cầu cụ thể của dự án. Giải pháp Dell-NVIDIA sử dụng phương pháp này, cho phép các doanh nghiệp tập trung vào các khía cạnh nhất định của khối lượng công việc AI tổng quát khi xây dựng cơ sở hạ tầng của họ. Phương pháp mô-đun này được thực hiện thông qua các thiết kế trường hợp sử dụng cụ thể để đào tạo, điều chỉnh mô hình và suy luận giúp sử dụng hiệu quả từng loại điện toán. Mỗi thiết kế bắt đầu với đơn vị tối thiểu cho từng trường hợp sử dụng, với các tùy chọn để mở rộng.

Ngăn xếp phần mềm mô-đun cũng rất quan trọng để cho phép các nhà nghiên cứu AI, nhà khoa học dữ liệu, kỹ sư dữ liệu và những người dùng khác thiết kế cơ sở hạ tầng của họ một cách nhanh chóng và đạt được thời gian nhanh chóng để định giá. Giải pháp Dell-NVIDIA sử dụng phần mềm NVIDIA AI tốt nhất, với các giải pháp của đối tác để xây dựng một nền tảng AI có thể thích ứng và được hỗ trợ ở mỗi lớp—từ hệ điều hành đến bộ lập lịch cho đến nhiều Hoạt động AI (AIOps) và Hoạt động Học máy (MLOps) ) các giải pháp.

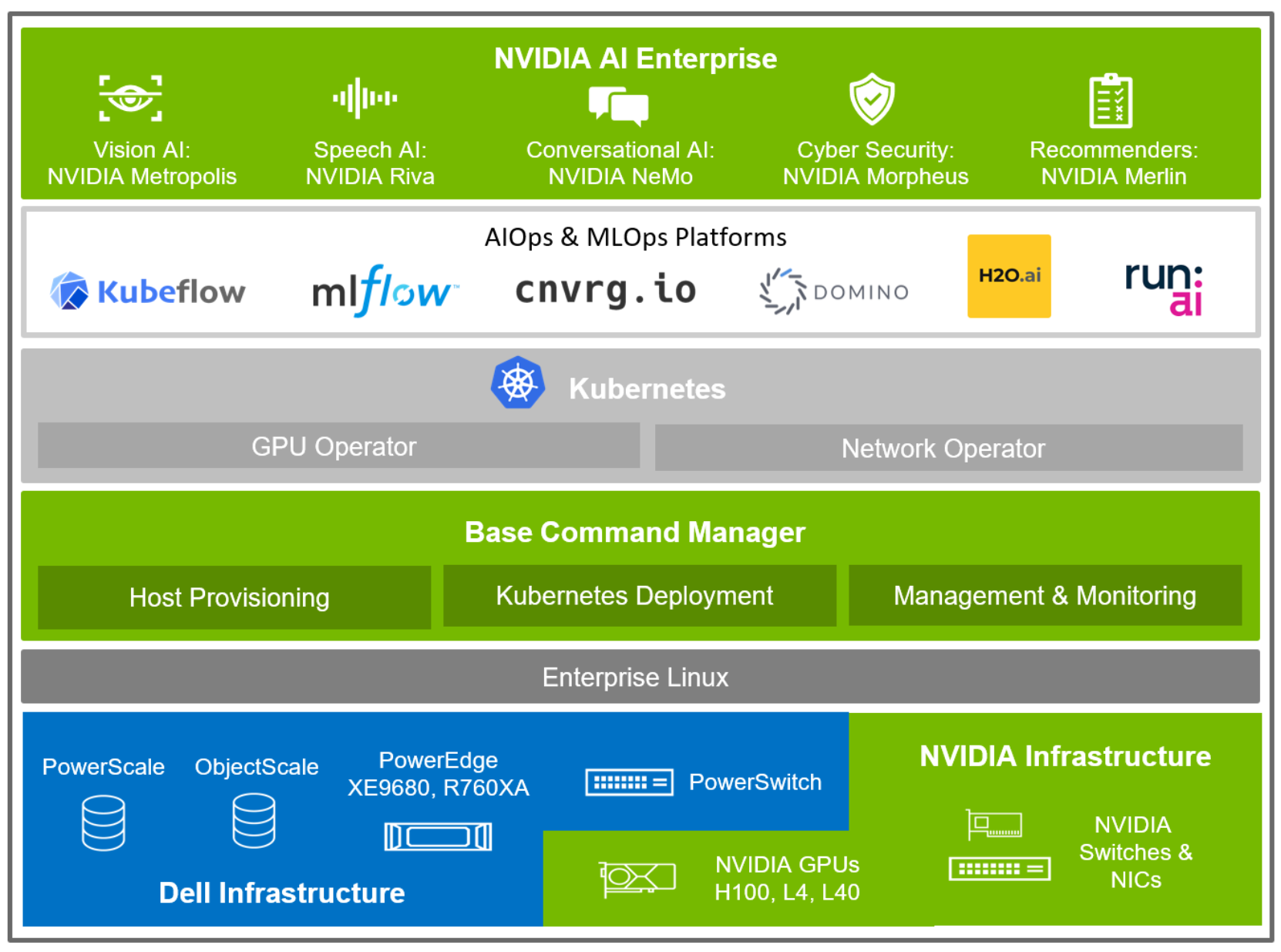

Hình dưới đây cho thấy chế độ xem cấp cao về kiến trúc giải pháp, nhấn mạnh vào ngăn xếp phần mềm, từ lớp cơ sở hạ tầng cho đến phần mềm ứng dụng AI:

Hình 1. Kiến trúc giải pháp và ngăn xếp phần mềm

Ở cấp độ cao, kiến trúc giải pháp bắt đầu với các thành phần phần cứng cơ bản của Dell Technologies và NVIDIA, được kết hợp theo các hoán vị tập trung vào khối lượng công việc AI cụ thể, chẳng hạn như đào tạo, tinh chỉnh và suy luận. Sách trắng này mô tả các thành phần phần cứng riêng lẻ trong phần sau.

Mỗi mặt phẳng điều khiển hoặc phần tử điện toán đều hỗ trợ Red Hat Enterprise Linux hoặc Ubuntu làm hệ điều hành, hệ điều hành này được tải sẵn trình điều khiển GPU NVIDIA và Kiến trúc thiết bị điện toán hợp nhất (CUDA) để sử dụng kim loại trần.

NVIDIA Base Command Manager (BCM) đóng vai trò là trình quản lý cụm bằng cách cài đặt phần mềm trên các hệ thống máy chủ trong cụm, triển khai Kubernetes và giám sát trạng thái cụm. Cung cấp máy chủ là cốt lõi của một cụm hoạt động tốt, với khả năng tải hệ điều hành, trình điều khiển, chương trình cơ sở và phần mềm quan trọng khác trên mỗi hệ thống máy chủ. Việc triển khai Kubernetes bao gồm cài đặt GPU Operator và Network Operator, một phần quan trọng của việc hỗ trợ kết cấu mạng và GPU. NVIDIA BCM hỗ trợ cả quản lý máy chủ lưu trữ trạng thái và không trạng thái, theo dõi từng hệ thống, tình trạng của hệ thống và thu thập các số liệu mà quản trị viên có thể xem trong thời gian thực hoặc có thể tổng hợp thành báo cáo.

Ở lớp trên cùng của giải pháp, là phần mềm NVIDIA AI Enterprise giúp tăng tốc quy trình khoa học dữ liệu và hợp lý hóa quá trình phát triển và triển khai AI sản xuất bao gồm AI tổng quát, thị giác máy tính, AI lời nói, v.v. Cho dù ban đầu phát triển một mô hình AI mới hay sử dụng một trong các quy trình AI tham chiếu làm mẫu để bắt đầu, NVIDIA AI Enterprise đều cung cấp phần mềm toàn diện, ổn định, an toàn đang phát triển nhanh chóng và được NVIDIA hỗ trợ đầy đủ.

Với Kubernetes được triển khai trong giải pháp, có thể cài đặt một số giải pháp MLOps khác nhau, cho dù là các giải pháp nguồn mở như Kubeflow và MLFlow hay các giải pháp được hỗ trợ nổi bật như cnvrg.io, Domino, H2O.ai, Run:ai, v.v. . Mỗi giải pháp này có thể được triển khai để hoạt động trong kịch bản đám mây đa cụm và đám mây lai.

Mô-đun kiến trúc

Kiến trúc giải pháp AI tổng quát giải quyết ba quy trình công việc chính:

- Suy luận mô hình lớn

- Tùy chỉnh mô hình lớn (tinh chỉnh và P-tuning)

- Đào tạo người mẫu lớn

Mỗi quy trình công việc này có các yêu cầu về điện toán, lưu trữ, mạng và phần mềm riêng biệt. Thiết kế giải pháp là mô-đun và mỗi thành phần có thể được điều chỉnh quy mô độc lập tùy thuộc vào yêu cầu ứng dụng và quy trình làm việc của khách hàng. Ngoài ra, một số mô-đun là tùy chọn hoặc có thể hoán đổi với các giải pháp tương đương hiện có trong cơ sở hạ tầng AI của một tổ chức, chẳng hạn như mô-đun MLOps và Chuẩn bị dữ liệu ưa thích của họ hoặc mô-đun dữ liệu ưa thích của họ. Bảng sau đây hiển thị các mô-đun chức năng trong kiến trúc giải pháp:

Bảng 1. Các mô-đun kiến trúc chức năng cho giải pháp AI tổng quát

|

mô-đun |

Sự miêu tả |

|

Đào tạo |

Mô-đun dành cho các máy chủ được tối ưu hóa AI để đào tạo, được cung cấp bởi các máy chủ PowerEdge XE9680 và XE8640 với GPU NVIDIA H100 |

|

suy luận |

Mô-đun dành cho các máy chủ được tối ưu hóa AI để suy luận, được cung cấp bởi các máy chủ PowerEdge XE9680 với các máy chủ NVIDIA H100 hoặc R760xa với GPU NVIDIA L40 hoặc L4 |

|

Sự quản lý |

Mô-đun để quản lý cụm và hệ thống, bao gồm một nút đầu cho NVIDIA BCM, được cung cấp bởi các máy chủ PowerEdge R660. |

|

MLOps và Chuẩn bị dữ liệu |

Mô-đun dành cho hoạt động máy học và chuẩn bị dữ liệu để chạy phần mềm MLOps, cơ sở dữ liệu và các tác vụ dựa trên CPU khác để chuẩn bị dữ liệu, được cung cấp bởi máy chủ PowerEdge R660 |

|

Dữ liệu |

Mô-đun dành cho Bộ lưu trữ đính kèm mạng (NAS) thông lượng cao, mở rộng quy mô do Dell PowerScale cung cấp, cùng với bộ lưu trữ đối tượng mở rộng quy mô thông lượng cao do Dell ECS và ObjectScale cung cấp |

|

InfiniBand |

Mô-đun dành cho giao tiếp giữa GPU với GPU có độ trễ rất thấp, băng thông cao, được cung cấp bởi bộ chuyển mạch NVIDIA QM9700 InfiniBand |

|

Ethernet |

Mô-đun cho thông lượng cao và giao tiếp băng thông cao giữa các mô-đun khác trong giải pháp được cung cấp bởi Dell PowerSwitch Z9432F-ON |

Khả năng mở rộng

Trong kiến trúc giải pháp, các mô-đun chức năng có thể được thu nhỏ theo các trường hợp sử dụng và yêu cầu về năng lực. Ví dụ: đơn vị mô-đun đào tạo tối thiểu để đào tạo mô hình lớn bao gồm tám máy chủ PowerEdge XE9680 với 64 GPU NVIDIA H100.

Như một ví dụ lý thuyết, mô-đun đào tạo với mô-đun InfiniBand có thể đào tạo mô hình tham số 175B trong 112 ngày. Để minh họa khả năng mở rộng, sáu bản sao của các mô-đun này có thể huấn luyện cùng một mô hình trong 19 ngày. Một ví dụ khác, nếu bạn đang đào tạo một mô hình tham số 40B, thì hai bản mô-đun đào tạo là đủ để đào tạo mô hình trong 14 ngày.

Có một khái niệm về khả năng mở rộng tương tự cho mô-đun InfiniBand. Ví dụ: một mô-đun có hai công tắc QM9700 có thể hỗ trợ tối đa 24 máy chủ PowerEdge XE9680. Nếu tăng gấp đôi mô-đun InfiniBand, trong kiến trúc fat-tree, bạn có thể mở rộng quy mô lên tới 48 máy chủ PowerEdge XE9680. Mô-đun Ethernet và mô-đun Suy luận hoạt động tương tự nhau.

Mô-đun Dữ liệu được cung cấp bởi các giải pháp lưu trữ kiến trúc lưu trữ mở rộng quy mô, có thể mở rộng tuyến tính để đáp ứng các yêu cầu về hiệu suất và dung lượng, khi bạn tăng số lượng máy chủ và GPU trong mô-đun Đào tạo và Suy luận của mình.

Khả năng mở rộng và mô đun hóa là nội tại đối với thiết kế của Dell và NVIDIA dành cho trí tuệ nhân tạo tổng quát trên toàn bộ bảng.

Bảo vệ

Phương pháp tiếp cận bảo mật của Dell về bản chất là có sẵn—nó được tích hợp sẵn, không được bổ sung sau này và nó được tích hợp vào mọi bước trong Vòng đời Phát triển Bảo mật của Dell. Chúng tôi cố gắng liên tục phát triển các biện pháp kiểm soát, tính năng và giải pháp bảo mật PowerEdge của mình để đáp ứng bối cảnh mối đe dọa ngày càng gia tăng và chúng tôi tiếp tục củng cố bảo mật bằng Silicon Root of Trust.

Các tính năng bảo mật được tích hợp trong Nền tảng đàn hồi không gian mạng PowerEdge, được kích hoạt bởi Bộ điều khiển truy cập từ xa Dell (iDRAC) tích hợp. Có nhiều tính năng được thêm vào hệ thống trải dài từ kiểm soát truy cập đến mã hóa dữ liệu đến đảm bảo chuỗi cung ứng. Các tính năng này bao gồm quét BIOS trực tiếp, Tùy chỉnh khởi động an toàn UEFI, MFA ID bảo mật RSA, Quản lý khóa doanh nghiệp an toàn (SEKM), Xác minh thành phần bảo mật (SCV), Xóa hệ thống nâng cao, Đăng ký và gia hạn chứng chỉ tự động, Chọn mật mã và hỗ trợ CNSA. Tất cả các tính năng đều sử dụng rộng rãi trí thông minh và tự động hóa để giúp bạn vượt qua các mối đe dọa và cho phép mở rộng quy mô theo yêu cầu của các mô hình sử dụng ngày càng mở rộng.

Khi các doanh nghiệp chuyển sang AI sản xuất, việc duy trì một nền tảng AI an toàn và ổn định có thể là một thách thức. Thách thức này đặc biệt đúng đối với các doanh nghiệp đã xây dựng nền tảng AI của riêng họ bằng cách sử dụng các thư viện và khung AI nguồn mở, không được hỗ trợ. Để giải quyết mối lo ngại này và giảm thiểu gánh nặng duy trì nền tảng AI, đăng ký phần mềm NVIDIA AI Enterprise bao gồm giám sát liên tục các lỗ hổng bảo mật, khắc phục liên tục và các bản vá bảo mật cũng như thông báo ưu tiên về các lỗ hổng nghiêm trọng. Việc giám sát này giải phóng các nhà phát triển doanh nghiệp để tập trung vào việc xây dựng các ứng dụng AI đổi mới thay vì duy trì nền tảng phát triển AI của họ. Ngoài ra, việc duy trì tính ổn định của API có thể là một thách thức do có nhiều phụ thuộc vào nguồn mở. Với NVIDIA AI Enterprise, các doanh nghiệp có thể tin tưởng vào tính ổn định của API bằng cách sử dụng nhánh sản xuất do các chuyên gia AI của NVIDIA duy trì. Tiếp cận với các chuyên gia Hỗ trợ của NVIDIA có nghĩa là các dự án AI luôn đi đúng hướng.

Bài viết mới cập nhật

Tăng tốc khối lượng công việc của Hệ thống tệp mạng (NFS) của bạn với RDMA

Giao thức NFS hiện nay được sử dụng rộng rãi trong ...

Mẹo nhanh về dữ liệu phi cấu trúc – OneFS Protection Overhead

Gần đây đã có một số câu hỏi từ lĩnh vực ...

Giới thiệu Dell PowerScale OneFS dành cho Quản trị viên NetApp

Để các doanh nghiệp khai thác được lợi thế của công ...

Cơ sở hạ tầng CNTT: Mua hay đăng ký?

Nghiên cứu theo số liệu của IDC về giải pháp đăng ...