Tin tức

Ảo hóa GPU cho AI với VMware và NVIDIA Dựa trên Cơ sở hạ tầng Dell (2)

Tổng quan về công nghệ

VMware vSphere 8

VMware vSphere 8 bao gồm các tính năng sau để hỗ trợ AI và khối lượng công việc máy học:

- Hỗ trợ cho thế hệ GPU mới nhất của NVIDIA, bao gồm hỗ trợ cho MIG NVIDIA dựa trên phân vùng không gian.

- Nâng cao hiệu suất giao tiếp giữa thiết bị với thiết bị, dựa trên chức năng NVIDIA GPUDirect hiện có bằng cách bật Dịch vụ dịch địa chỉ (ATS) và Dịch vụ kiểm soát truy cập (ACS) ở lớp bus PCIe trong nhân ESXi.

- Hỗ trợ cho các nhóm thiết bị để đào tạo đa GPU và đa nút. Các nhóm thiết bị cho phép các máy ảo sử dụng các thiết bị phần cứng bổ sung dễ dàng hơn. Các thiết bị GPU và NIC thông minh NVIDIA được hỗ trợ trong vSphere 8. Các nhóm thiết bị được thêm vào máy ảo bằng cách sử dụng quy trình công việc Thêm thiết bị PCI mới hiện có . Các nhóm thiết bị hỗ trợ cấu hình tự động máy ảo và tạo các nút công nhân trong Tanzu. vSphere DRS và vSphere HA nhận thức được các nhóm thiết bị và đặt VM một cách thích hợp để đáp ứng nhóm thiết bị.

- Cấp phép VMware vSphere cho mỗi ổ cắm CPU. Cấp phép có sẵn cho các phiên bản sau:

- tiêu chuẩn vSphere

- vSphere Enterprise Plus

- vSphere Essentials

- vSphere Essentials Plus

Thiết kế đã được xác thực này yêu cầu phiên bản vSphere Enterprise Plus. NVIDIA vGPU và các công tắc ảo phân tán (cần thiết để cân bằng tải trong Tanzu) yêu cầu phiên bản Enterprise Plus.

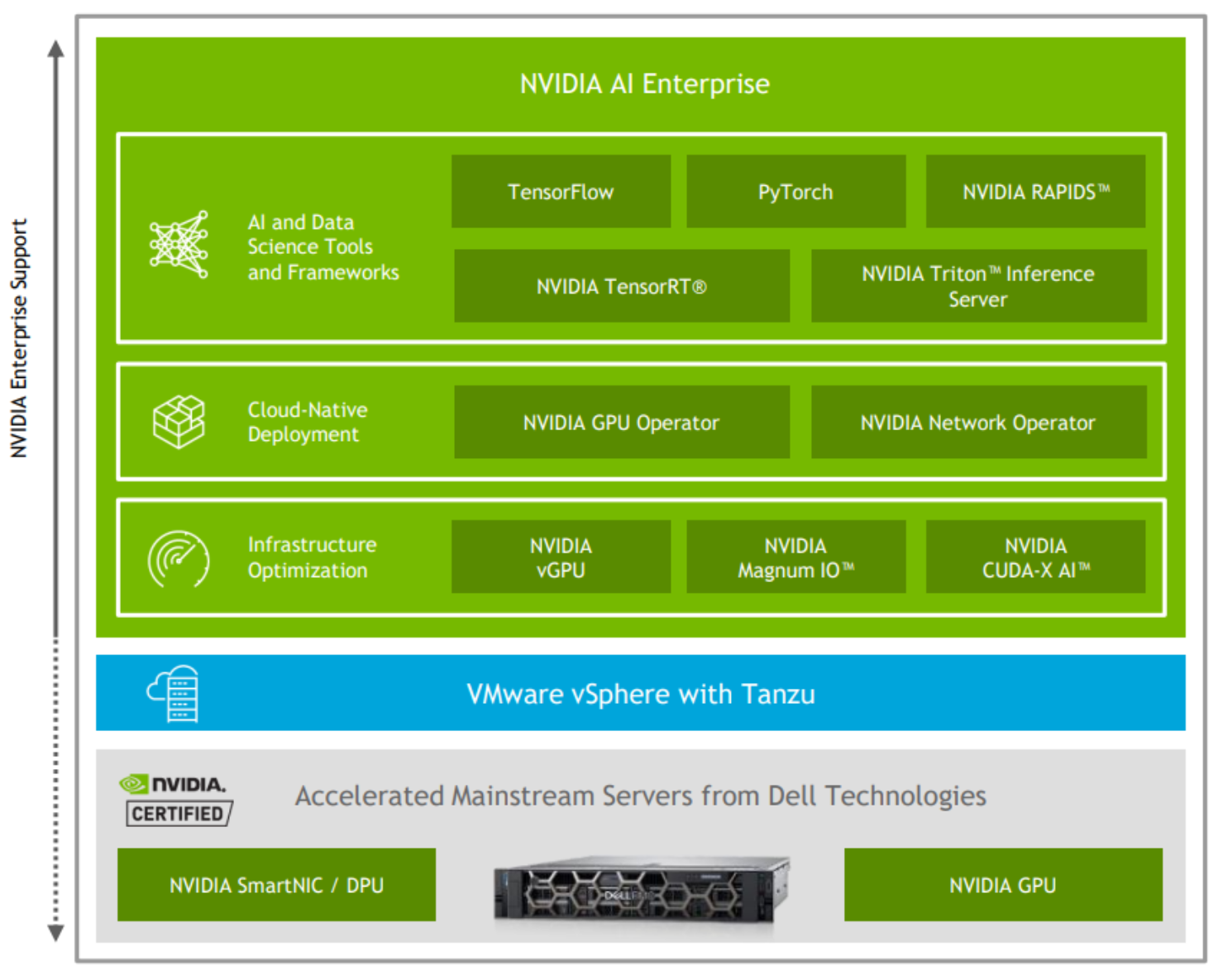

VMware vSphere với Tanzu

vSphere với Tanzu cho phép quản trị viên chuyển đổi vSphere thành một nền tảng để chạy khối lượng công việc Kubernetes nguyên bản trên lớp ảo hóa. Khi được bật trên cụm vSphere, vSphere with Tanzu cung cấp khả năng chạy khối lượng công việc Kubernetes trực tiếp trên máy chủ ESXi và tạo cụm Kubernetes ngược dòng trong nhóm tài nguyên chuyên dụng.

Quản trị viên vSphere có thể kích hoạt các cụm vSphere hiện có cho Quản lý khối lượng công việc, để tạo cụm Tanzu Kubernetes trong các máy chủ ESXi là một phần của cụm. Cụm Tanzu Kubernetes là một bản phân phối đầy đủ của nền tảng điều phối bộ chứa Kubernetes mã nguồn mở được VMware xây dựng, ký kết và hỗ trợ. Tanzu Kubernetes Grid (TKG) Cung cấp dịch vụ và vận hành cụm Tanzu Kubernetes trên vSphere.

Tanzu Kubernetes Grid (TKG), khả dụng với VMware vSphere 8, hỗ trợ ảo hóa GPU NVIDIA thông qua NVIDIA AI Enterprise. Với TKG, các GPU ảo được tự động cung cấp và định cấu hình trên các nút công nhân Tanzu Kubernetes Cluster và được cung cấp cho các bộ chứa khối lượng công việc AI.

VMware vSphere with Tanzu có thể được cấp phép thông qua vSphere+ hoặc Tanzu Kubernetes Operations. Để biết thêm thông tin, hãy xem So sánh dòng sản phẩm VMware vSphere và VMware Tanzu for Kubernetes Operations Documentation .

Hệ sinh thái VMware Kubernetes

VMware cung cấp một số sản phẩm trong danh mục Tanzu để nâng cao khả năng của vSphere trên Tanzu. Các sản phẩm này cho phép quản trị viên xây dựng, chạy và quản lý khối lượng công việc AI cùng với các ứng dụng hiện đại và liên tục mang lại giá trị cho khách hàng. Tùy thuộc vào phiên bản Tanzu , các sản phẩm phần mềm này đi kèm với VMware vSphere with Tanzu và được VMware hỗ trợ đầy đủ. Một số sản phẩm chính được áp dụng cho thiết kế đã được thẩm định này bao gồm:

- Harbor —Một cơ quan đăng ký vùng chứa gốc trên đám mây, nguồn mở, đáng tin cậy giúp lưu trữ, ký và quét nội dung. Harbor mở rộng phân phối Docker mã nguồn mở bằng cách thêm các chức năng như bảo mật, kiểm soát danh tính và quản lý.

- Lưới Tanzu Kubernetes —Bao gồm các tệp nhị phân đã ký cho Harbor mà bạn có thể triển khai trên cụm dịch vụ dùng chung để cung cấp dịch vụ đăng ký vùng chứa cho các cụm Tanzu Kubernetes khác.

- Prometheus —Một bộ công cụ giám sát và cảnh báo hệ thống mã nguồn mở. Prometheus thu thập và lưu trữ các chỉ số dưới dạng dữ liệu chuỗi thời gian, nghĩa là thông tin chỉ số được lưu trữ với dấu thời gian mà tại đó nó được ghi lại, cùng với các cặp khóa-giá trị tùy chọn. Tanzu Kubernetes Grid bao gồm các tệp nhị phân đã ký cho Prometheus mà bạn có thể triển khai trên các cụm Tanzu Kubernetes để theo dõi tình trạng và dịch vụ của cụm.

- Grafana —Phần mềm mã nguồn mở cho phép bạn trực quan hóa và phân tích dữ liệu chỉ số do Prometheus thu thập trên các cụm Tanzu Kubernetes. Tanzu Kubernetes Grid bao gồm gói Grafana mà bạn có thể triển khai trên các cụm.

- VMware NSX Advanced Load Balancer —NSX Advanced Load Balancer (trước đây gọi là Avi Networks) với Dịch vụ đám mây có tính năng cân bằng tải nhiều đám mây, tường lửa ứng dụng web và các dịch vụ truy cập bộ chứa. Kiến trúc mở rộng, được xác định bằng phần mềm của NSX Advanced Load Balancer cung cấp tính năng tự động thay đổi quy mô theo yêu cầu của các bộ cân bằng tải đàn hồi. Bộ cân bằng tải phần mềm phân tán và các ứng dụng phụ trợ có thể tăng hoặc giảm quy mô để đáp ứng với giám sát lưu lượng thời gian thực.

NSX Advanced Load Balancer cung cấp khả năng truy cập mạng và cân bằng tải cho các cụm Tanzu Kubernetes. Bạn có thể sử dụng nó để cân bằng tải các trường hợp sử dụng AI, chẳng hạn như các ứng dụng Vận hành máy học hoặc khối lượng công việc suy luận.

- Tanzu Mission Control —Một trung tâm tập trung để quản lý Kubernetes đơn giản hóa, đa đám mây, đa cụm. Tanzu Mission Control cung cấp khả năng quản lý chính sách tập trung cho phép quản trị viên áp dụng các chính sách nhất quán, chẳng hạn như quyền truy cập và bảo mật, cho một nhóm các cụm và không gian tên trên quy mô lớn. Nó cung cấp khả năng quản lý vòng đời cho các cụm Kubernetes cho phép quản trị viên cung cấp, thay đổi quy mô, nâng cấp và xóa các cụm Tanzu Kubernetes Grid.

Phần mềm bổ sung sau đây có sẵn từ VMware để quản lý và sắp xếp khối lượng công việc bộ chứa. Các công cụ phần mềm này đề cập đến việc phát triển ứng dụng cho mục đích chung và không được xác thực như một phần của thiết kế đã được xác thực này.

- Nền tảng ứng dụng VMware Tanzu là một nền tảng mô-đun, nhận biết ứng dụng, cung cấp một bộ công cụ dành cho nhà phát triển phong phú và một lộ trình sản xuất để xây dựng và triển khai phần mềm một cách nhanh chóng và an toàn trên mọi đám mây công cộng tuân thủ hoặc cụm Kubernetes tại chỗ.

- Khả năng quan sát Tanzu cho phép giám sát Kubernetes với khả năng hiển thị toàn bộ ngăn xếp của các nút, nhóm và vùng chứa. Nó cung cấp cái nhìn sâu sắc tức thì về sức khỏe của nền tảng Dịch vụ ứng dụng Tanzu trên các nền tảng và tác động của mã trong quá trình sản xuất.

- Tanzu Service Mesh cung cấp khả năng kết nối, bảo mật và thông tin chuyên sâu tiên tiến, đầu cuối cho các ứng dụng hiện đại—cho người dùng cuối của ứng dụng, vi dịch vụ, API và dữ liệu—cho phép tuân thủ Mục tiêu cấp độ dịch vụ cũng như các quy định về quyền riêng tư và bảo vệ dữ liệu.

- Danh mục ứng dụng VMware là một lựa chọn có thể tùy chỉnh của các thành phần ứng dụng mã nguồn mở được đóng gói sẵn, đáng tin cậy, được duy trì liên tục và kiểm tra có thể kiểm chứng để sử dụng trong môi trường sản xuất.

- Dịch vụ Tanzu Build tự động hóa việc tạo, quản lý và quản trị vùng chứa ở quy mô doanh nghiệp đồng thời tăng cường bảo mật và giảm thiểu rủi ro do Tiếp xúc với lỗ hổng bảo mật thông thường.

Dịch vụ dữ liệu Tanzu là một danh mục phần mềm bộ nhớ đệm, nhắn tin và cơ sở dữ liệu theo yêu cầu trên VMware Tanzu dành cho các nhóm phát triển đang xây dựng các ứng dụng hiện đại.

VMware vSAN 8

vSAN là một giải pháp lưu trữ do VMware xác định bằng phần mềm, được xây dựng từ đầu cho các máy ảo vSphere. Nó tóm tắt và tổng hợp các đĩa được gắn cục bộ trong một cụm vSphere để tạo ra một giải pháp lưu trữ mà bạn có thể cung cấp và quản lý từ vCenter và ứng dụng khách vSphere. vSAN được nhúng trong trình ảo hóa, do đó, việc lưu trữ và tính toán cho các máy ảo được phân phối từ cùng một nền tảng máy chủ x86 chạy trình ảo hóa.

vSAN là công ty dẫn đầu thị trường về cơ sở hạ tầng HCI. Các ứng dụng truyền thống như Microsoft SQL Server và SAP HANA cũng như các ứng dụng thế hệ tiếp theo như khối lượng công việc AI có thể chạy trên vSAN. Các mô hình liên quan đến việc triển khai, vận hành và bảo trì cơ sở hạ tầng truyền thống bao gồm nhiều công cụ được phân tách khác nhau và thường là các bộ kỹ năng chuyên biệt. Cách tiếp cận siêu hội tụ của vSphere và vSAN đơn giản hóa các tác vụ này bằng cách sử dụng các công cụ quen thuộc để triển khai, vận hành và quản lý cơ sở hạ tầng đám mây riêng.

vSAN 8 Express Storage Architecture (ESA) là cải tiến lớn mới nhất dành cho các cụm vSphere 8. vSAN 8 ESA sử dụng một hệ thống tệp được tối ưu hóa để tận dụng tối đa các thiết bị lưu trữ NVMe được chứng nhận và kết nối mạng 25 Gbps+ để cải thiện đáng kể hiệu suất và dung lượng so với các phiên bản trước. vSAN 7 hiện được gọi là Kiến trúc lưu trữ gốc (OSA).

VMware vSAN được cấp phép cho mỗi ổ cắm CPU. Nó có sẵn trong các phiên bản sau: Standard, Advanced, Enterprise và Enterprise Plus. Đối với thiết kế đã được xác thực này, chúng tôi khuyên dùng giấy phép vSAN Enterprise. Cần có vSphere Enterprise Plus và VMware Tanzu Standard để sử dụng nền tảng Data Persistence. Nền tảng Data Persistence chỉ khả dụng trong vSAN Enterprise và Enterprise Plus.

Bài viết mới cập nhật

Công bố các bản nâng cấp không gây gián đoạn dựa trên Drain (NDU)

Trong quy trình làm việc NDU, các nút được khởi động ...

Tăng tốc khối lượng công việc của Hệ thống tệp mạng (NFS) của bạn với RDMA

Giao thức NFS hiện nay được sử dụng rộng rãi trong ...

Mẹo nhanh về dữ liệu phi cấu trúc – OneFS Protection Overhead

Gần đây đã có một số câu hỏi từ lĩnh vực ...

Giới thiệu Dell PowerScale OneFS dành cho Quản trị viên NetApp

Để các doanh nghiệp khai thác được lợi thế của công ...