Giải pháp xây dựng

Bản tóm tắt

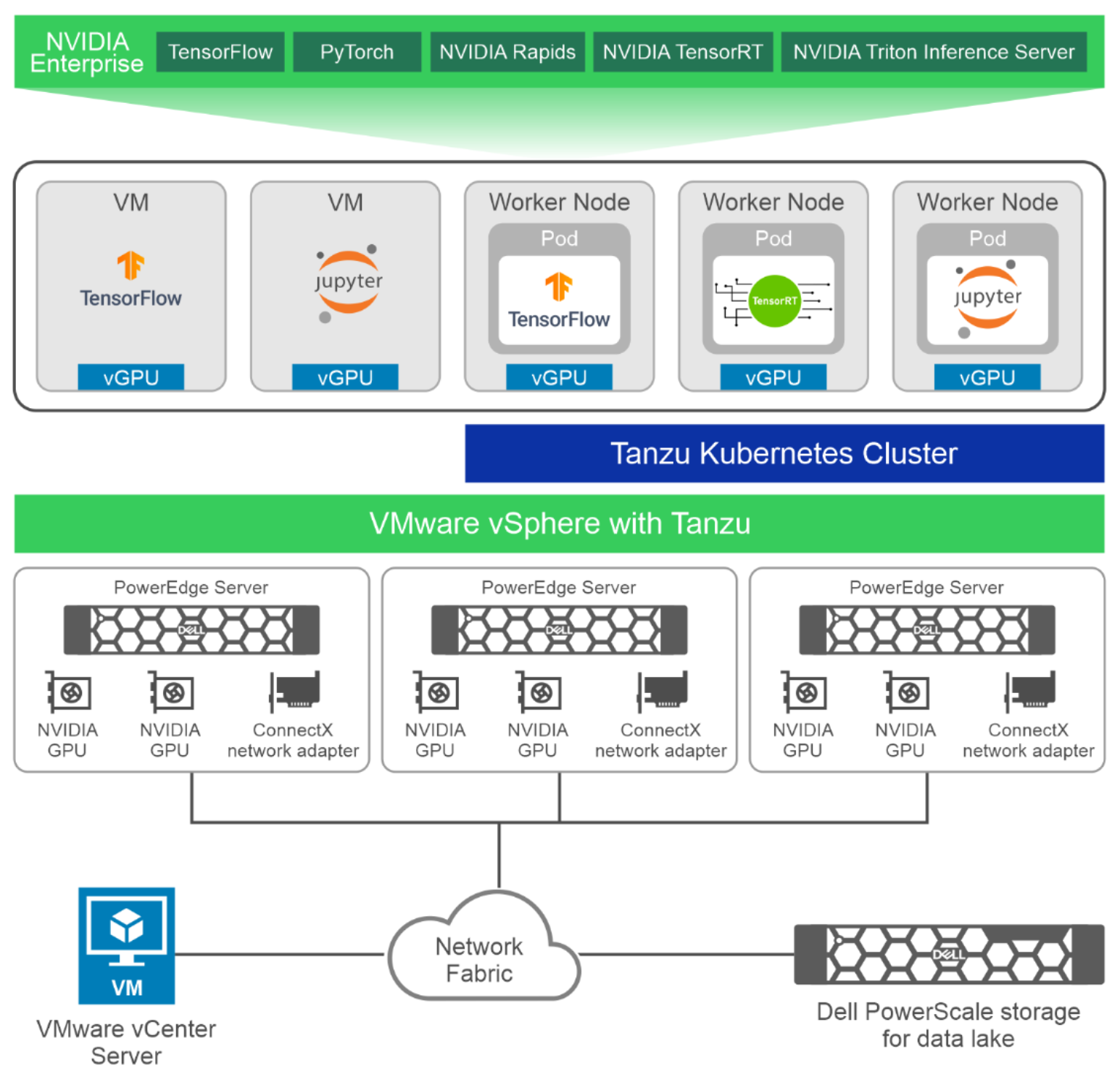

Với sự hỗ trợ của VMware vSphere dành cho GPU ảo hóa, quản trị viên CNTT có thể chạy khối lượng công việc AI như đào tạo mạng thần kinh, suy luận hoặc phát triển mô hình cùng với các ứng dụng trung tâm dữ liệu tiêu chuẩn của họ. Hình dưới đây thể hiện kiến trúc cấp cao cho thiết kế đã được xác thực này với các máy chủ PowerEdge R760, mỗi máy chủ có hai GPU NVIDIA A100 và bộ điều hợp mạng ConnectX, như một phần của cụm VMware vSphere. Máy ảo có vGPU chạy bộ chứa từ NVIDIA AI Enterprise. Thiết kế đã được xác thực này cho phép khối lượng công việc AI chạy dưới dạng nhóm VM hoặc Kubernetes trong cụm Tanzu Kubernetes.

Hình 3. Kiến trúc cấp cao với máy chủ PowerEdge R760 và bộ lưu trữ PowerScale

Các khía cạnh chính của thiết kế được xác nhận này bao gồm:

- Máy chủ điện toán —Máy chủ PowerEdge R760 và R7625 là một phần của thiết kế đã được kiểm chứng này.

- GPU —GPU NVIDIA A100 và A30 có thể được sử dụng cho AI và máy học. Chúng tôi khuyên dùng GPU A100 cho các mô hình đào tạo mạng thần kinh lớn đòi hỏi hiệu suất cao và GPU A30 cho khối lượng công việc chính của doanh nghiệp và suy luận AI. Số lượng GPU được hỗ trợ trong một máy chủ phụ thuộc vào kiểu máy chủ như trong Bảng 2 .

- Bộ nhớ —vSAN là bộ nhớ được đề xuất cho máy ảo. Chúng tôi khuyên dùng bộ lưu trữ PowerStore để lưu trữ hồ dữ liệu, nghĩa là lưu trữ dữ liệu cần thiết cho quá trình đào tạo mạng thần kinh. Lưu trữ PowerScale cũng có thể được sử dụng để lưu trữ dữ liệu cho khối lượng công việc AI trong phân vùng NFS.

- Cơ sở hạ tầng mạng —Khách hàng có thể có cơ sở hạ tầng mạng Ethernet 25 Gb hoặc cơ sở hạ tầng mạng Ethernet 100 Gb. Chúng tôi khuyên dùng 25 GbE cho khối lượng công việc có thể sử dụng cơ sở hạ tầng mạng hiện có mà không cần đầu tư vào cơ sở hạ tầng mạng 100 Gb. Thiết kế này phù hợp với các công việc đào tạo mạng thần kinh có thể chạy trên một nút (sử dụng tối đa hai GPU) và cho các công việc suy luận và phát triển mô hình tận dụng phân vùng GPU.

Chúng tôi khuyên dùng 100 GbE cho khối lượng công việc yêu cầu đào tạo mô hình quy mô lớn bằng cách sử dụng bộ dữ liệu lớn (thường là bộ dữ liệu dựa trên hình ảnh hoặc video có độ phân giải cao).

- Ảo hóa và điều phối vùng chứa —GPU có thể được ảo hóa và cung cấp cho các máy ảo chạy trên máy chủ VMware ESXi được triển khai trên máy chủ PowerEdge. Đối với khối lượng công việc được đóng gói, dịch vụ Tanzu Kubernetes Grid được bật trên cụm vSphere. Các nút công nhân Kubernetes có thể được tạo bằng tài nguyên GPU ảo. Khối lượng công việc AI có thể được triển khai dưới dạng nhóm trên các dịch vụ triển khai chạy trên cụm Tanzu Kubernetes.

- Quản lý với VMware vCenter —VMware vCenter Server có thể được triển khai như một máy ảo trong trung tâm dữ liệu của bạn. vCenter rất quan trọng đối với việc triển khai, vận hành và bảo trì môi trường vSAN. Vì lý do này, Dell Technologies khuyến nghị rằng vCenter nên được triển khai trên một cụm quản lý có tính sẵn sàng cao, tồn tại bên ngoài cụm điện toán.

Kết quả xác thực

Bản tóm tắt

Dựa trên kiến trúc được mô tả trong sách trắng này, nhóm Giải pháp Tích hợp của Dell đã sử dụng Phòng thí nghiệm Cải tiến Trí tuệ Nhân tạo & HPC của Dell Technologies để tiến hành các nghiên cứu xác thực và hiệu suất của GPU ảo hóa trên VMware vSphere.

Chúng tôi cũng đã mô tả hiệu suất của MIG bằng cách sử dụng cả đào tạo và suy luận mô hình ResNet. Kết quả cũng cho thấy mức sử dụng GPU tăng lên khi sử dụng phân vùng GPU cho khối lượng công việc, chẳng hạn như suy luận, không yêu cầu toàn bộ GPU.

Kết luận

Bản tóm tắt

Các chuyên gia khoa học dữ liệu đã và đang thúc đẩy các giới hạn của cơ sở hạ tầng CNTT và tạo ra các môi trường CNTT trong bóng tối trong nhiều năm. Dell Technologies, VMware và NVIDIA đã đáp ứng bằng nhiều cải tiến trong tính toán, tùy chọn lưu trữ dữ liệu và kết nối mạng tốc độ cao để đáp ứng thách thức đó bằng các giải pháp tích hợp đầy đủ. Trong sách trắng này, chúng tôi chỉ ra cách bạn có thể quản lý những tiến bộ này trong công nghệ phần cứng hiệu quả hơn, đồng thời duy trì mức tăng hiệu suất ấn tượng trong môi trường ảo hóa bằng cách sử dụng phiên bản mới nhất của phần mềm ảo hóa VMware.

Không ở đâu có những tiến bộ về hiệu suất cho khoa học dữ liệu nhanh như sự phát triển của các bộ tăng tốc phần cứng dựa trên công nghệ từng được sử dụng chủ yếu cho xử lý đồ họa. Thế hệ GPU Ampere mới nhất của NVIDIA cung cấp hiệu suất cao hơn tới 20 lần so với thế hệ GPU NVIDIA trước đó. GPU NVIDIA A100 có thể được phân vùng tối đa bảy phiên bản GPU để tự động điều chỉnh theo nhu cầu thay đổi. Với bộ phần mềm NVIDIA AI Enterprise, các nhà khoa học dữ liệu có các công cụ và khuôn khổ phù hợp cho toàn bộ vòng đời khoa học dữ liệu của họ.

Thiết kế đã được xác thực của Dell để ảo hóa GPU cho AI với VMware và NVIDIA cung cấp sự kết hợp giữa GPU ảo hóa, phần mềm doanh nghiệp AI và điều phối vùng chứa, mang đến cho các chuyên gia CNTT các công cụ và quy trình nhất quán để quản lý toàn bộ trung tâm dữ liệu của họ, đồng thời cho phép nhà khoa học dữ liệu tập trung vào chuẩn bị dữ liệu và phát triển mô hình mà không phải lo lắng về cơ sở hạ tầng.

Bài viết mới cập nhật

Công bố các bản nâng cấp không gây gián đoạn dựa trên Drain (NDU)

Trong quy trình làm việc NDU, các nút được khởi động ...

Tăng tốc khối lượng công việc của Hệ thống tệp mạng (NFS) của bạn với RDMA

Giao thức NFS hiện nay được sử dụng rộng rãi trong ...

Mẹo nhanh về dữ liệu phi cấu trúc – OneFS Protection Overhead

Gần đây đã có một số câu hỏi từ lĩnh vực ...

Giới thiệu Dell PowerScale OneFS dành cho Quản trị viên NetApp

Để các doanh nghiệp khai thác được lợi thế của công ...