Tin tức

Hiệu suất học sâu với điểm chuẩn MLPerf Inference v0.7

MLPerf là bộ công cụ đo điểm chuẩn để đo lường hiệu suất của khối lượng công việc Machine Learning (ML). Nó tập trung vào các khía cạnh quan trọng nhất của vòng đời ML:

- Đào tạo —Bộ điểm chuẩn đào tạo MLPerf đo lường tốc độ hệ thống có thể đào tạo các mô hình ML.

- Suy luận —Điểm chuẩn suy luận MLPerf đo lường tốc độ hệ thống có thể thực hiện suy luận ML bằng cách sử dụng mô hình được đào tạo trong các tình huống triển khai khác nhau.

Blog này trình bày các kết quả đóng của trung tâm dữ liệu suy luận MLPerf v0.7 trên các máy chủ Dell EMC PowerEdge R7525 và DSS8440 với GPU NVIDIA chạy điểm chuẩn suy luận MLPerf . Kết quả của chúng tôi cho thấy hiệu suất suy luận tối ưu cho các hệ thống và cấu hình mà chúng tôi đã chọn để chạy điểm chuẩn suy luận.

Trong khung đánh giá suy luận MLPerf, trình tạo tải LoadGen gửi các truy vấn suy luận đến hệ thống đang được thử nghiệm (SUT). Trong trường hợp của chúng tôi, SUT là các máy chủ PowerEdge R7525 và DSS8440 được lựa chọn cẩn thận với nhiều cấu hình GPU khác nhau. SUT sử dụng phần phụ trợ (ví dụ: TensorRT, TensorFlow hoặc PyTorch) để thực hiện suy luận và gửi kết quả trở lại LoadGen.

MLPerf đã xác định bốn kịch bản khác nhau cho phép thử nghiệm đại diện cho nhiều nền tảng suy luận và trường hợp sử dụng khác nhau . Sự khác biệt chính giữa các trường hợp này dựa trên cách gửi và nhận truy vấn:

- Ngoại tuyến —Một truy vấn với tất cả các mẫu được gửi đến SUT. SUT có thể gửi kết quả trở lại một hoặc nhiều lần theo bất kỳ thứ tự nào. Số liệu hiệu suất là mẫu mỗi giây.

- Máy chủ —Các truy vấn được gửi đến SUT theo phân phối Poisson (để lập mô hình các sự kiện ngẫu nhiên trong thế giới thực). Một truy vấn có một mẫu. Chỉ số hiệu suất là số truy vấn mỗi giây (QPS) trong giới hạn độ trễ.

- Một luồng —Một mẫu cho mỗi truy vấn được gửi đến SUT. Truy vấn tiếp theo sẽ không được gửi cho đến khi nhận được phản hồi trước đó. Chỉ số hiệu suất là độ trễ phân vị thứ 90.

- Multi-stream —Một truy vấn có N mẫu được gửi với khoảng thời gian cố định. Chỉ số hiệu suất tối đa là N khi độ trễ của tất cả các truy vấn nằm trong giới hạn độ trễ.

Quy tắc suy luận MLPerf mô tả các quy tắc suy luận chi tiết và các ràng buộc về độ trễ. Blog này chỉ tập trung vào các kịch bản Ngoại tuyến và Máy chủ, được thiết kế cho môi trường trung tâm dữ liệu. Các kịch bản một luồng và nhiều luồng được thiết kế cho các cài đặt không phải trung tâm dữ liệu (cạnh và IoT).

Kết quả Suy luận MLPerf có thể được gửi theo một trong các phần sau:

- Bộ phận đóng — Bộ phận Đóng nhằm mục đích cung cấp sự so sánh “táo với táo” về nền tảng phần cứng hoặc khung phần mềm. Nó yêu cầu sử dụng cùng một mô hình và trình tối ưu hóa như cách triển khai tham chiếu.

Bộ phận Đóng yêu cầu sử dụng tiền xử lý, xử lý hậu kỳ và mô hình tương đương với việc triển khai tham chiếu hoặc thay thế. Nó cho phép hiệu chuẩn lượng tử hóa và không cho phép đào tạo lại. MLPerf cung cấp cách triển khai tham chiếu cho từng điểm chuẩn. Việc triển khai điểm chuẩn phải sử dụng một mô hình tương đương, như được xác định trong Quy tắc suy luận MLPerf , với mô hình được sử dụng trong quá trình triển khai tham chiếu.

- Phân chia mở —Phân chia mở nhằm mục đích thúc đẩy các mô hình và trình tối ưu hóa nhanh hơn, đồng thời cho phép mọi phương pháp ML có thể đạt được chất lượng mục tiêu. Nó cho phép sử dụng tiền xử lý hoặc hậu xử lý và mô hình tùy ý, bao gồm cả đào tạo lại. Việc triển khai điểm chuẩn có thể sử dụng một mô hình khác để thực hiện cùng một nhiệm vụ.

Để cho phép so sánh giữa các kết quả của Dell EMC và cho phép khách hàng cũng như đối tác của chúng tôi lặp lại kết quả của chúng tôi, chúng tôi đã chọn tiến hành thử nghiệm trong phần Đóng, như được hiển thị trong kết quả trên blog này.

Tiêu chí để gửi kết quả điểm chuẩn MLPerf Inference v0.7

Bảng sau mô tả các kỳ vọng về điểm chuẩn MLPerf:

Bảng 1: Các điểm chuẩn có sẵn trong phần Đóng cho suy luận MLPerf v0.7 với kỳ vọng của chúng.

| Khu vực | Nhiệm vụ | Người mẫu | Tập dữ liệu | kích thước QSL | Chất lượng yêu cầu | Hạn chế về độ trễ của máy chủ bắt buộc |

| Tầm nhìn | Phân loại hình ảnh | Resnet50-v1.5 | Tập dữ liệu hình ảnh tiêu chuẩn (224 x 224 x 3) | 1024 | 99% FP32 (76,46%) | 15 mili giây |

| Tầm nhìn | Phát hiện đối tượng (lớn) | SSD-ResNet34 | COCO (1200×1200) | 64 | 99% của FP32 (0,20 mAP) | 100 mili giây |

| Tầm nhìn | Phân đoạn hình ảnh y tế | UNET 3D | Áo ngực 2019 (224x224x160) | 16 | 99% FP32 và 99,9% FP32 (điểm DICE trung bình là 0,85300) | không áp dụng |

| Lời nói | Chuyển giọng nói thành văn bản | RNNT | Librispeech dev-clean (mẫu < 15 giây) | 2513 | 99% của FP32 (1 – WER, trong đó WER=7,452253714852645%) | 1000 mili giây |

| Ngôn ngữ | Xử lý ngôn ngữ | BERT | SQuAD v1.1 (max_seq_len=384) | 10833 | 99% của FP32 và 99,9% của FP32 (f1_score=90,874%) | 130 mili giây |

| thương mại | Sự giới thiệu | DLRM | Nhật ký nhấp chuột 1 TB | 204800 | 99% của FP32 và 99,9% của FP32 (AUC=80,25%) | 30 mili giây |

Đối với bất kỳ điểm chuẩn nào, điều cần thiết là kết quả gửi phải đáp ứng tất cả các thông số kỹ thuật trong bảng này. Ví dụ: nếu chúng tôi chọn mô hình Resnet50 thì nội dung gửi phải đáp ứng độ chính xác mục tiêu 76,46% và độ trễ phải trong vòng 15 mili giây đối với tập dữ liệu hình ảnh tiêu chuẩn có kích thước 224 x 224 x 3.

Mỗi điểm chuẩn của trung tâm dữ liệu yêu cầu các kịch bản trong bảng sau:

Bảng 2: Nhiệm vụ và các kịch bản bắt buộc tương ứng đối với bộ điểm chuẩn trung tâm dữ liệu trong suy luận MLPerf v0.7.

| Khu vực | Nhiệm vụ | Kịch bản bắt buộc |

| Tầm nhìn | Phân loại hình ảnh | Bộ trợ giúp không kết nối |

| Tầm nhìn | Phát hiện đối tượng (lớn) | Bộ trợ giúp không kết nối |

| Tầm nhìn | Phân đoạn hình ảnh y tế | Ngoại tuyến |

| Lời nói | Chuyển giọng nói thành văn bản | Bộ trợ giúp không kết nối |

| Ngôn ngữ | Xử lý ngôn ngữ | Bộ trợ giúp không kết nối |

| thương mại | Sự giới thiệu | Bộ trợ giúp không kết nối |

cấu hình SUT

Chúng tôi đã chọn các máy chủ sau với các loại GPU NVIDIA khác nhau làm SUT để tiến hành đo điểm chuẩn suy luận của trung tâm dữ liệu:

Kết quả

Phần sau đây cung cấp kết quả của điểm chuẩn MLPerf Inference v0.7.

Đối với kịch bản Ngoại tuyến, chỉ số hiệu suất là Mẫu ngoại tuyến mỗi giây. Đối với kịch bản Máy chủ, số liệu hiệu suất là số truy vấn mỗi giây (QPS). Nói chung, số liệu thể hiện thông lượng.

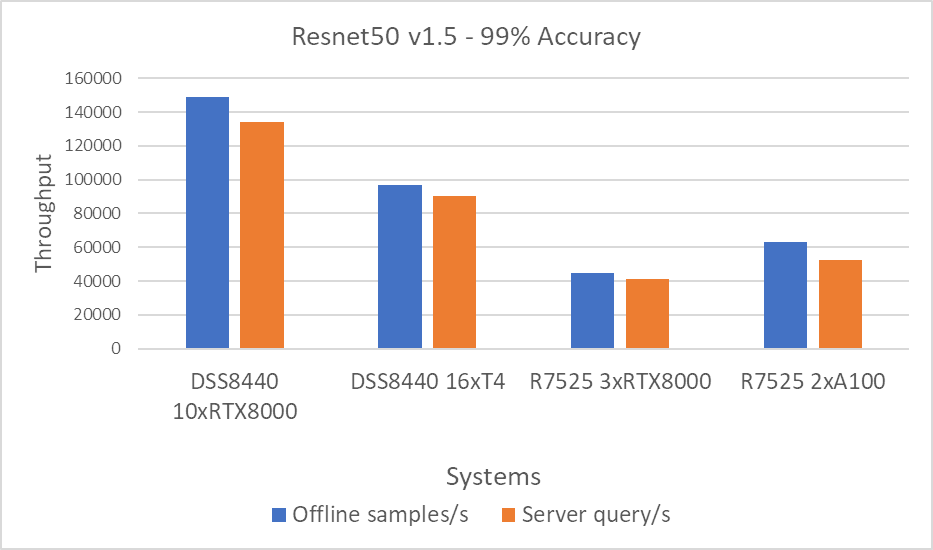

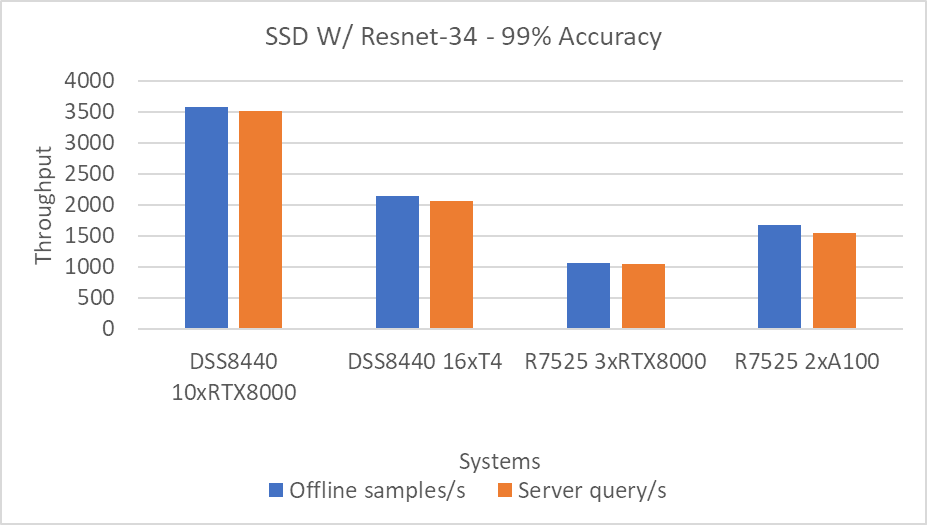

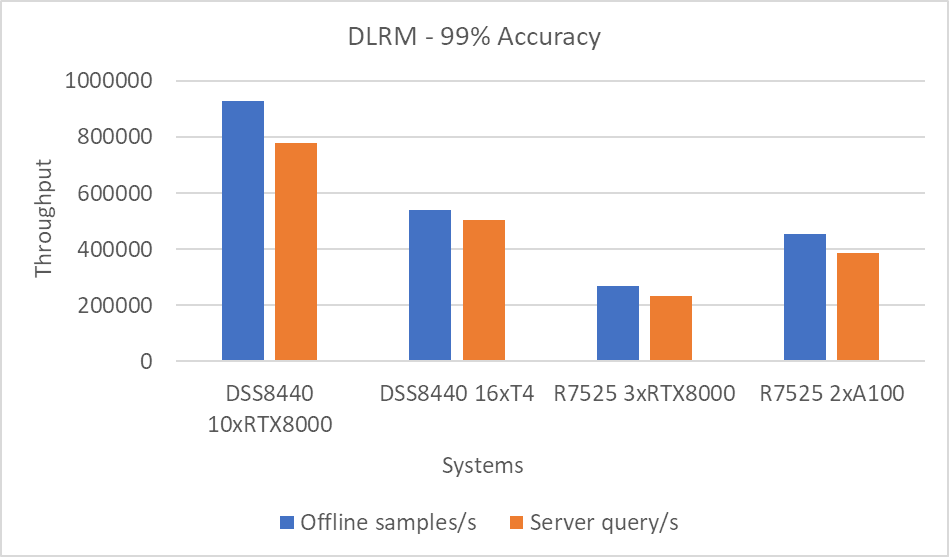

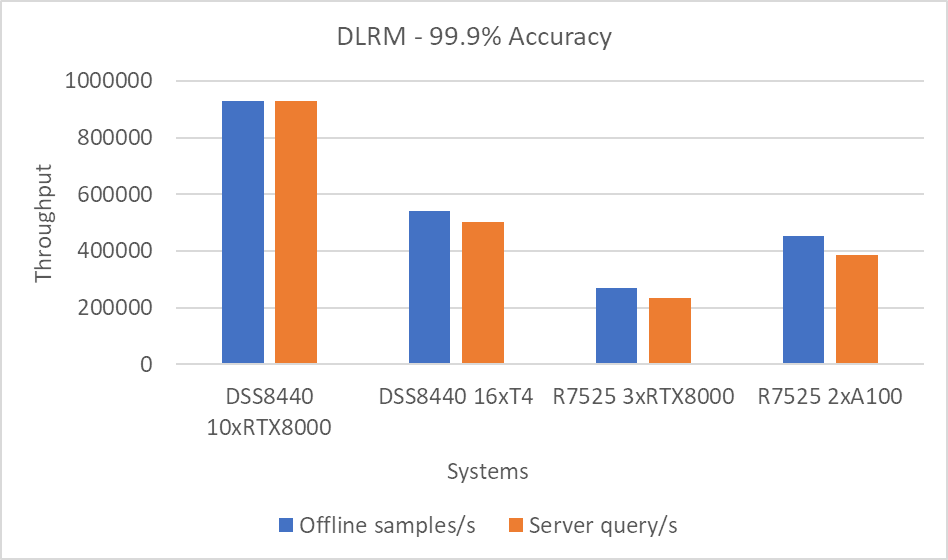

Các biểu đồ sau bao gồm số liệu hiệu suất cho các tình huống Ngoại tuyến và Máy chủ. Thông lượng cao hơn là kết quả tốt hơn.

Hình 1: Kịch bản Resnet50 v1.5 Ngoại tuyến và Máy chủ với mục tiêu chính xác 99%

Hình 2: SSD w/Resnet34 Kịch bản ngoại tuyến và máy chủ với mục tiêu chính xác 99%

Hình 3: Kịch bản máy chủ và ngoại tuyến DLRM với mục tiêu chính xác 99%

Hình 4: Kịch bản máy chủ và ngoại tuyến DLRM với mục tiêu chính xác 99,9%

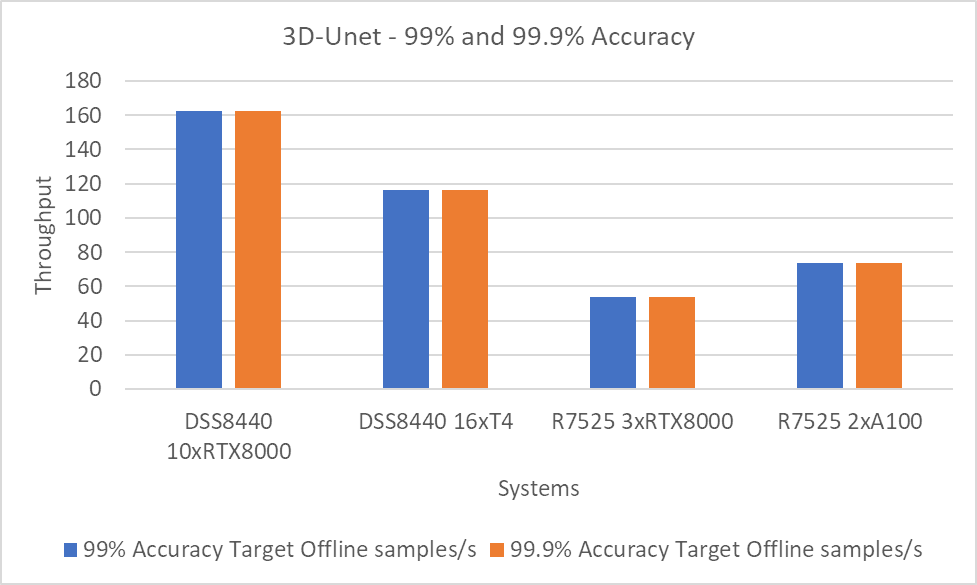

Hình 5: 3D-Unet sử dụng mục tiêu có độ chính xác 99 và 99,9%.

Lưu ý : Các mục tiêu chính xác 99 và 99,9 phần trăm với DLRM và 3D-Unet cho thấy hiệu suất tương tự vì các mục tiêu chính xác đã được đáp ứng sớm.

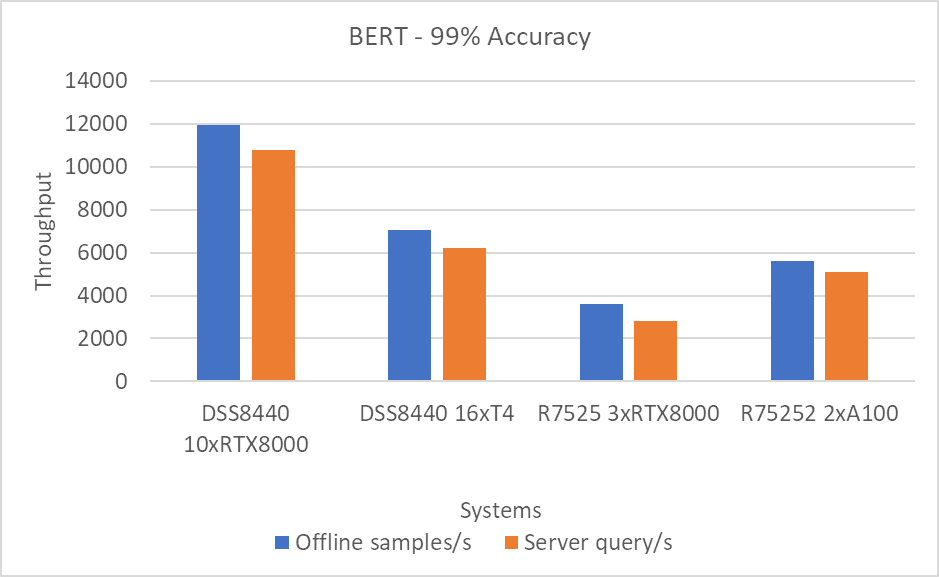

Hình 6: Kịch bản BERT ngoại tuyến và máy chủ với mục tiêu chính xác 99%

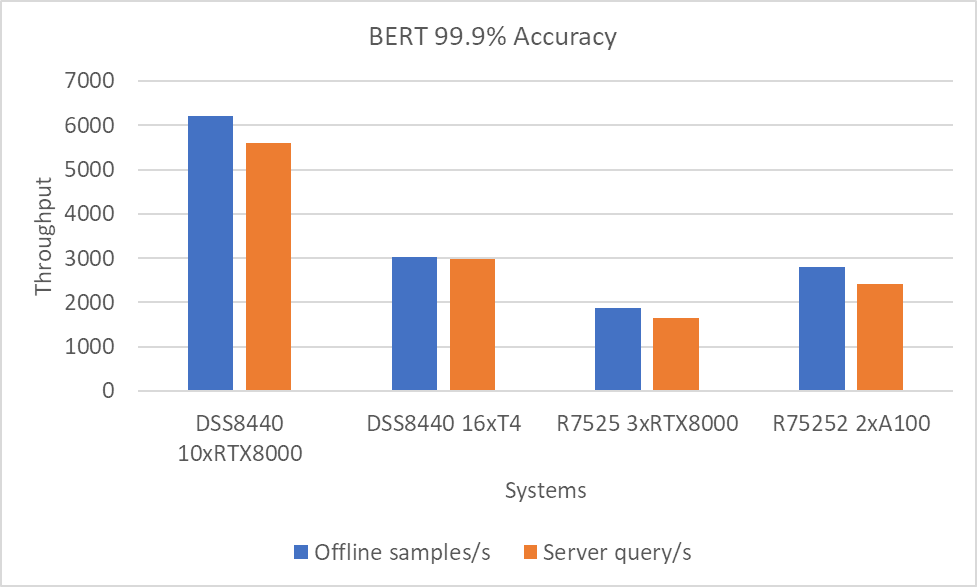

Hình 7: Kịch bản BERT Ngoại tuyến và Máy chủ với mục tiêu chính xác 99,9%.

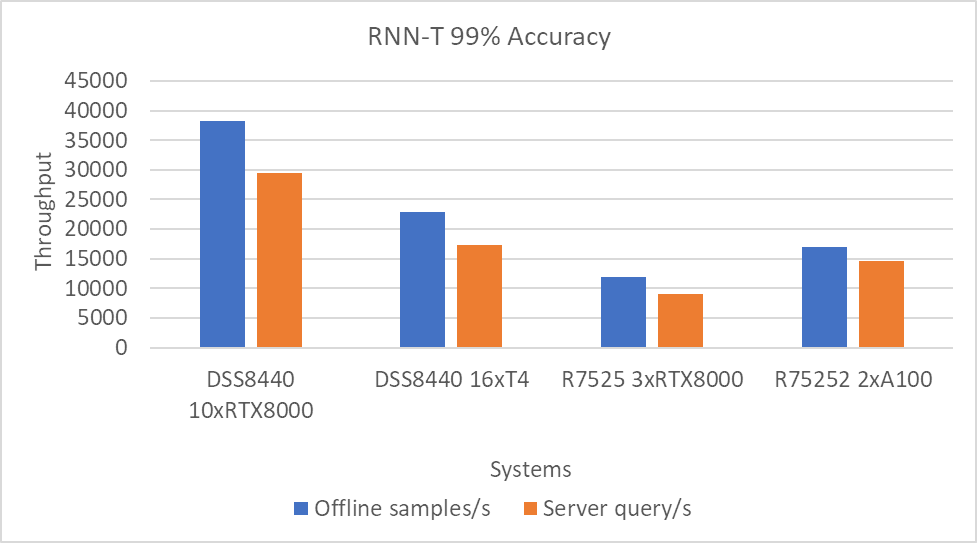

Hình 8: Kịch bản Máy chủ và Ngoại tuyến RNN-T với mục tiêu chính xác 99%

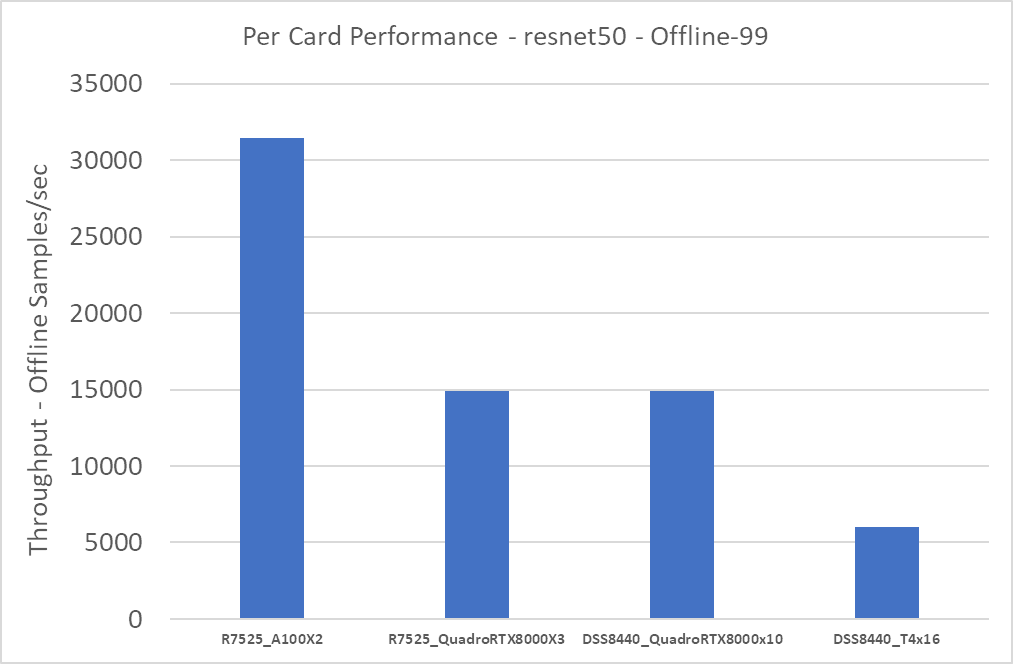

Hiệu suất trên mỗi GPU

Để ước tính hiệu suất trên mỗi GPU, chúng tôi chia kết quả ở phần trước cho số lượng GPU trên hệ thống. Chúng tôi quan sát thấy rằng hiệu suất tăng tuyến tính khi chúng tôi tăng số lượng GPU. Nghĩa là, khi chúng ta thêm nhiều thẻ hơn, hiệu suất của hệ thống sẽ được nhân với số lượng thẻ nhân với hiệu suất trên mỗi thẻ. Chúng tôi sẽ cung cấp thông tin này trong một bài viết blog tiếp theo.

Hình dưới đây hiển thị hiệu suất gần đúng trên mỗi GPU:

Hình 9: Hiệu suất gần đúng trên mỗi thẻ cho kịch bản Resnet50 Ngoại tuyến

Cả hệ thống R7525_QuadroRTX8000x3 và DSS8440_QuadroRTX8000x10 đều sử dụng thẻ RTX8000. Do đó, hiệu suất trên mỗi thẻ của hai hệ thống này là như nhau. Thẻ A100 mang lại hiệu suất cao nhất; thẻ T4 mang lại hiệu suất thấp nhất.

Phần kết luận

Trong blog này, chúng tôi đã định lượng hiệu suất suy luận MLPerf v0.7 trên máy chủ Dell EMC DSS8440 và PowerEdge R7525 với GPU NVIDIA A100, RTX8000 và T4 với Resnet50, SSD w/ Resnet34, DLRM, BERT, RNN-T và 3D-Unet điểm chuẩn. Những điểm chuẩn này bao gồm các nhiệm vụ từ tầm nhìn đến đề xuất. Máy chủ Dell EMC mang lại hiệu suất suy luận hàng đầu được chuẩn hóa theo số lượng bộ xử lý trong số các kết quả có sẵn trên thị trường. Chúng tôi nhận thấy rằng GPU A100 mang lại hiệu suất tổng thể tốt nhất và hiệu suất trên mỗi watt tốt nhất trong khi GPU RTX mang lại hiệu suất trên mỗi đô la tốt nhất. Nếu bị hạn chế trong môi trường năng lượng hạn chế, GPU T4 sẽ mang lại hiệu suất trên mỗi watt tốt nhất.

Bài viết mới cập nhật

Công bố các bản nâng cấp không gây gián đoạn dựa trên Drain (NDU)

Trong quy trình làm việc NDU, các nút được khởi động ...

Tăng tốc khối lượng công việc của Hệ thống tệp mạng (NFS) của bạn với RDMA

Giao thức NFS hiện nay được sử dụng rộng rãi trong ...

Mẹo nhanh về dữ liệu phi cấu trúc – OneFS Protection Overhead

Gần đây đã có một số câu hỏi từ lĩnh vực ...

Giới thiệu Dell PowerScale OneFS dành cho Quản trị viên NetApp

Để các doanh nghiệp khai thác được lợi thế của công ...