Tin tức

MLPerf™ Inference 4.0 trên Máy chủ Dell PowerEdge với CPU Xeon® thế hệ thứ 5 của Intel®

Giới thiệu

Trong blog này, chúng tôi trình bày kết quả suy luận trung tâm dữ liệu MLPerf™ v4.0 thu được trên Dell PowerEdge R760 với Bộ xử lý có khả năng mở rộng Intel® Xeon® thế hệ thứ 5 mới nhất (hệ thống chỉ có CPU).

Các bộ xử lý Intel® Xeon® mới này sử dụng công cụ nhân ma trận Intel® AMX trong mỗi lõi để tăng hiệu năng suy luận tổng thể. Tập trung vào tính dễ sử dụng, Dell Technologies mang lại hiệu suất CPU vượt trội ngay lập tức với cấu hình BIOS được tối ưu hóa giúp phát huy tối đa sức mạnh của phần mềm OneDNN của Intel – một phần mềm được tích hợp hoàn toàn với cả khung PyTorch và TensorFlow. Cấu hình máy chủ và thông số kỹ thuật CPU trong các thử nghiệm điểm chuẩn lần lượt được hiển thị trong Bảng 1 và 2.

Bảng 1. Cấu hình máy chủ Dell PowerEdge R760

| Tên hệ thống | PowerEdge R760 |

| Trạng thái | Có sẵn |

| Loại hệ thống | Trung tâm dữ liệu |

| Số nút | 1 |

| Mô hình bộ xử lý máy chủ | Bộ xử lý có khả năng mở rộng Intel ® Xeon ® thế hệ thứ 5 |

| Bộ xử lý máy chủ trên mỗi nút | 2 |

| Số lượng lõi của bộ xử lý máy chủ | 64 |

| Tần số bộ xử lý máy chủ | Tăng tốc Turbo 1,9 GHz, 3,9 GHz |

| Dung lượng bộ nhớ máy chủ | 2 TB, 16 x 128 GB 5600 MT/s |

| Dung lượng lưu trữ máy chủ | 7,68TB, NVME |

Bảng 2. Thông số kỹ thuật của bộ xử lý có khả năng mở rộng Intel® Xeon® thế hệ thứ 5

| Bộ sưu tập sản phẩm | Bộ xử lý có khả năng mở rộng Intel® Xeon® thế hệ thứ 5 |

| Tên bộ xử lý | Bạch kim 8592+ |

| Trạng thái | Đã ra mắt |

| Số lõi CPU | 64 |

| số chủ đề | 128 |

| Tần số cơ sở | 1,9 GHz |

| Tốc độ Turbo tối đa | 3,9 GHz |

| Bộ đệm L3 | 320MB |

| Loại bộ nhớ | DDR5 5600 tấn/giây |

| Hỗ trợ bộ nhớ ECC | Đúng |

Suy luận MLPerf™ v4.0 – Trung tâm dữ liệu

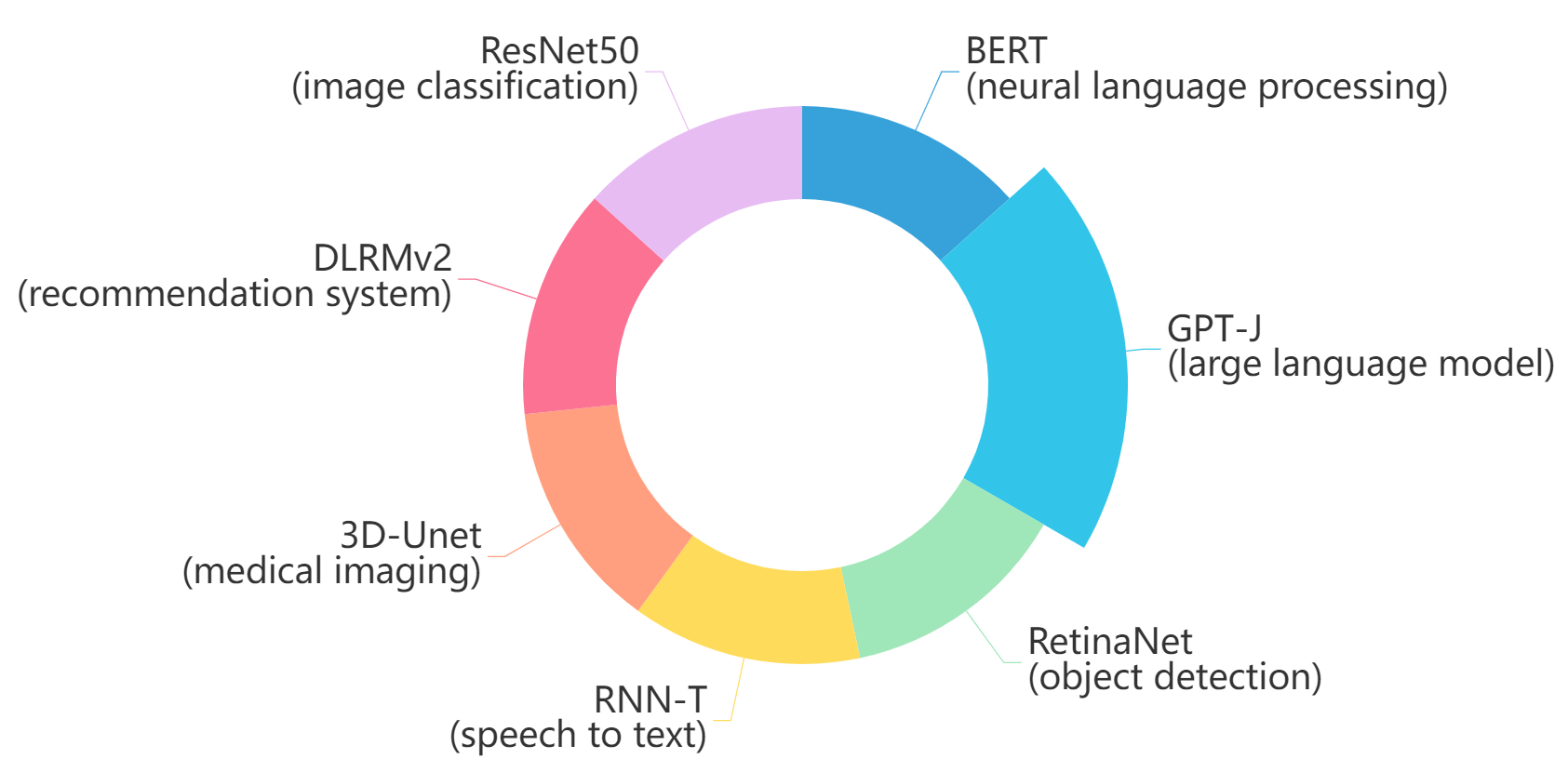

Điểm chuẩn suy luận MLPerf™ đo lường tốc độ hệ thống có thể thực hiện suy luận ML bằng cách sử dụng mô hình được đào tạo với dữ liệu mới trong nhiều tình huống triển khai khác nhau. Có hai bộ điểm chuẩn, một dành cho hệ thống Trung tâm dữ liệu và một dành cho Edge. Hình 1 hiển thị 7 mô hình với mỗi mục tiêu nhắm vào các nhiệm vụ khác nhau trong bản phát hành chính thức v4.0 dành cho danh mục hệ thống Trung tâm dữ liệu đã chạy trên PowerEdge R760 này và được gửi trong danh mục đóng. Tập dữ liệu và mục tiêu chất lượng được xác định cho từng mô hình để đo điểm chuẩn, như được liệt kê trong Bảng 3.

Hình 1. Các mô hình điểm chuẩn cho suy luận trung tâm dữ liệu MLPerf™ v4.0

Bảng 3. Điểm chuẩn của Bộ trung tâm dữ liệu. Nguồn: MLCommons™

| Khu vực | Nhiệm vụ | Người mẫu | Tập dữ liệu | Kích thước QSL | Chất lượng | Độ trễ của máy chủ

hạn chế |

| Tầm nhìn | Phân loại hình ảnh | ResNet50-v1.5 | ImageNet (224×224) | 1024 | 99% FP32 (76,46%) | 15 mili giây |

| Tầm nhìn | Sự vật

phát hiện |

RetinaNet | Hình ảnh mở (800×800) | 64 | 99% của FP32 (0,20 mAP) | 100 mili giây |

| Tầm nhìn | Thuộc về y học

hình ảnh |

3D-Unet | BỘ DỤNG CỤ 2019 (602x512x512) | 16 | 99,9% của FP32 (điểm DICE trung bình là 0,86330) | không áp dụng |

| Lời nói | Chuyển giọng nói thành văn bản | RNN-T | Librispeech dev-clean (mẫu < 15 giây) | 2513 | 99% của FP32 (1 – WER, trong đó WER=7,452253714852645%) | 1000 mili giây |

| Ngôn ngữ | Xử lý ngôn ngữ | BERT-lớn | SQuAD v1.1 (max_seq_len=384) | 10833 | 99% của FP32 và 99,9% của FP32 (f1_score=90,874%) | 130 mili giây |

| Ngôn ngữ | Tóm tắt | GPT-J | CNN Dailymail (v3.0.0, max_seq_len=2048) | 13368 | 99% của FP32 (f1_score=80,25%

rouge1=42,9865, rouge2=20,1235, rougeL=29,9881). |

20 giây |

| thương mại | Sự giới thiệu | DLRMv2 | Criteo 4TB đa nóng | 204800 | 99% của FP32 (AUC=80,25%) | 60 mili giây |

kịch bản

Các mô hình này được triển khai trong nhiều ứng dụng suy luận quan trọng hoặc các trường hợp sử dụng được gọi là “kịch bản”, trong đó mỗi kịch bản yêu cầu các số liệu khác nhau, thể hiện hiệu suất của môi trường sản xuất trong thực tế. Sau đây là mô tả của từng kịch bản. Bảng 4 hiển thị các kịch bản cần thiết cho từng điểm chuẩn của Trung tâm dữ liệu có trong bản gửi v4.0 này.

Kịch bản ngoại tuyến : thể hiện các ứng dụng xử lý dữ liệu đầu vào theo lô dữ liệu có sẵn ngay lập tức và không có giới hạn về độ trễ đối với hiệu suất số liệu được đo bằng mẫu mỗi giây.

Kịch bản máy chủ : thể hiện việc triển khai các ứng dụng trực tuyến với các truy vấn đầu vào ngẫu nhiên. Hiệu suất số liệu được đo bằng truy vấn mỗi giây (QPS) tùy thuộc vào giới hạn độ trễ. Kịch bản máy chủ phức tạp hơn về mặt hạn chế độ trễ và tạo truy vấn đầu vào. Sự phức tạp này được phản ánh trong kết quả suy giảm thông lượng so với kịch bản ngoại tuyến.

Mỗi điểm chuẩn của Trung tâm dữ liệu yêu cầu các tình huống sau:

Bảng 4. Kịch bản điểm chuẩn của bộ trung tâm dữ liệu. Nguồn: MLCommons™

| Khu vực | Nhiệm vụ | Kịch bản bắt buộc |

| Tầm nhìn | Phân loại hình ảnh | Bộ trợ giúp không kết nối |

| Tầm nhìn | Phát hiện đối tượng | Bộ trợ giúp không kết nối |

| Tầm nhìn | Hình ảnh y tế | Ngoại tuyến |

| Lời nói | Chuyển giọng nói thành văn bản | Bộ trợ giúp không kết nối |

| Ngôn ngữ | Xử lý ngôn ngữ | Bộ trợ giúp không kết nối |

| Ngôn ngữ | Tóm tắt | Bộ trợ giúp không kết nối |

| thương mại | Sự giới thiệu | Bộ trợ giúp không kết nối |

Ngăn xếp phần mềm và cấu hình hệ thống

Ngăn xếp phần mềm và cấu hình hệ thống được sử dụng cho lần gửi này được tóm tắt trong Bảng 5.

Bảng 5. Cấu hình hệ thống

| hệ điều hành | CentOS Stream 8 (GNU/Linux x86_64) |

| hạt nhân | 6.7.4-1.el8.elrepo.x86_64 |

| Phần mềm suy luận tối ưu hóa Intel® dành cho MLPerf™ | MLPerf™ Intel® OneDNN được tích hợp với Intel® Extension cho PyTorch (IPEX) |

| Chế độ bộ nhớ ECC | TRÊN |

| Cấu hình bộ nhớ máy chủ | 2TB, 16 x 128 GB, 1 DIMM mỗi kênh, cân bằng tốt |

| Chế độ tăng tốc | TRÊN |

| Bộ điều chỉnh tần số CPU | Hiệu suất |

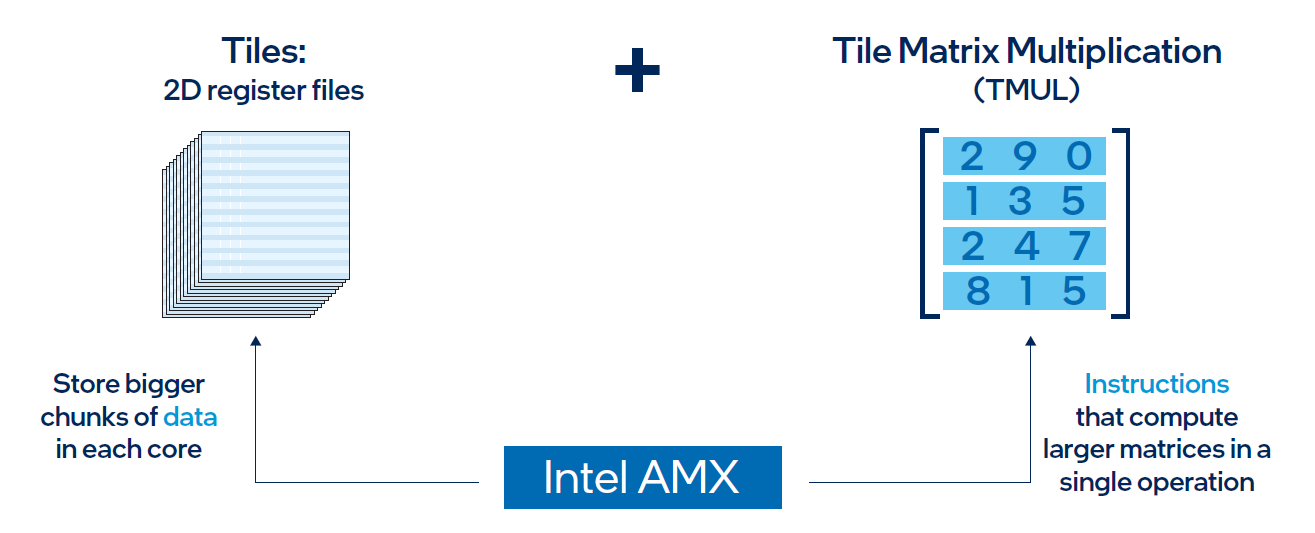

Intel® AMX (Phần mở rộng ma trận nâng cao) là gì?

Intel® AMX là một bộ tăng tốc tích hợp cho phép bộ xử lý có khả năng mở rộng Intel® Xeon® thế hệ thứ 5 tối ưu hóa khối lượng công việc đào tạo và suy luận học sâu (DL). Với phép nhân ma trận tốc độ cao được hỗ trợ bởi Intel® AMX, bộ xử lý có khả năng mở rộng Intel® Xeon® thế hệ thứ 5 có thể nhanh chóng xoay chuyển giữa việc tối ưu hóa điện toán chung và khối lượng công việc AI.

Hãy tưởng tượng một chiếc ô tô có thể vượt trội khi lái trong thành phố và sau đó nhanh chóng chuyển sang mang lại hiệu suất đua xe Công thức 1. Bộ xử lý có khả năng mở rộng Intel® Xeon® thế hệ thứ 5 mang đến mức độ linh hoạt này. Các nhà phát triển có thể mã hóa chức năng AI để tận dụng tập lệnh Intel® AMX cũng như mã hóa chức năng không phải AI để sử dụng kiến trúc tập lệnh bộ xử lý (ISA). Intel® đã tích hợp Thư viện mạng thần kinh sâu oneAPI (oneDNN) – công cụ oneAPI DL của nó – vào các công cụ nguồn mở phổ biến dành cho các ứng dụng AI, bao gồm TensorFlow, PyTorch, PaddlePaddle và ONNX.

Kiến trúc AMX

Kiến trúc Intel® AMX bao gồm hai thành phần, như minh họa trong Hình 1:

- Các ô bao gồm tám thanh ghi hai chiều, mỗi thanh có kích thước 1 kilobyte. Họ lưu trữ khối lượng lớn dữ liệu.

- Phép nhân ma trận ô xếp (TMUL) là một công cụ tăng tốc được gắn vào các ô xếp để thực hiện các phép tính nhân ma trận cho AI.

Hình 2. Kiến trúc Intel ® AMX bao gồm các tệp thanh ghi 2D (ô) và TMUL

Kết quả

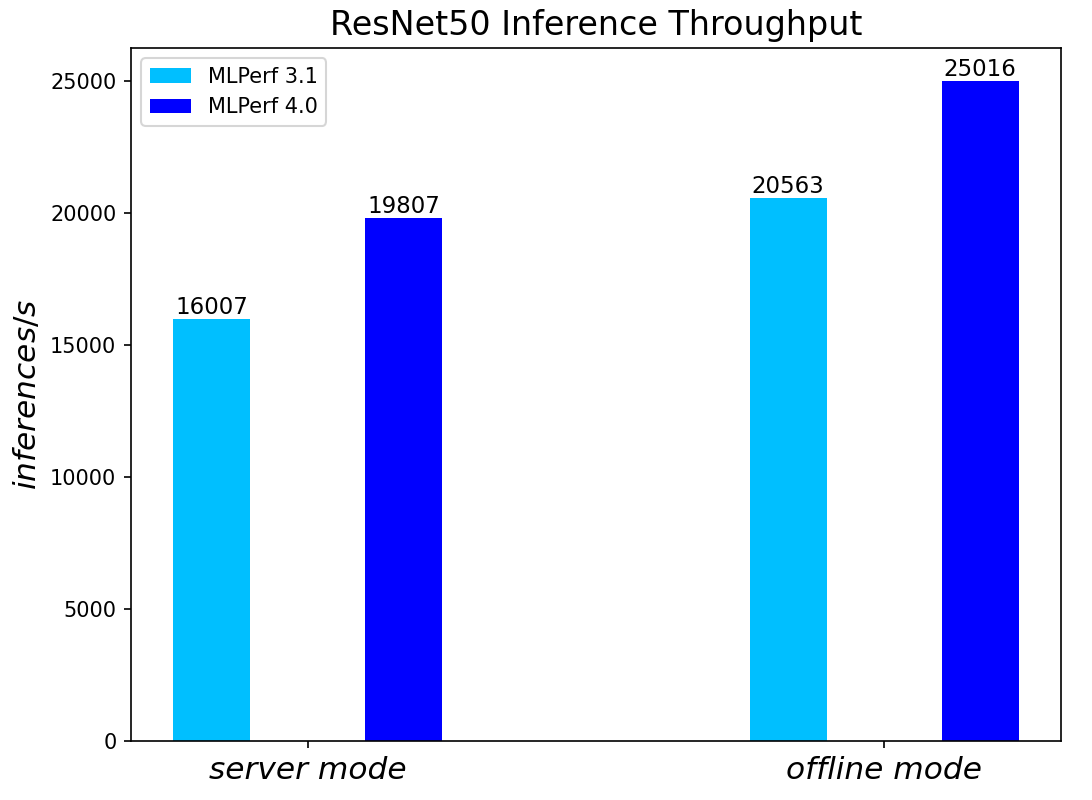

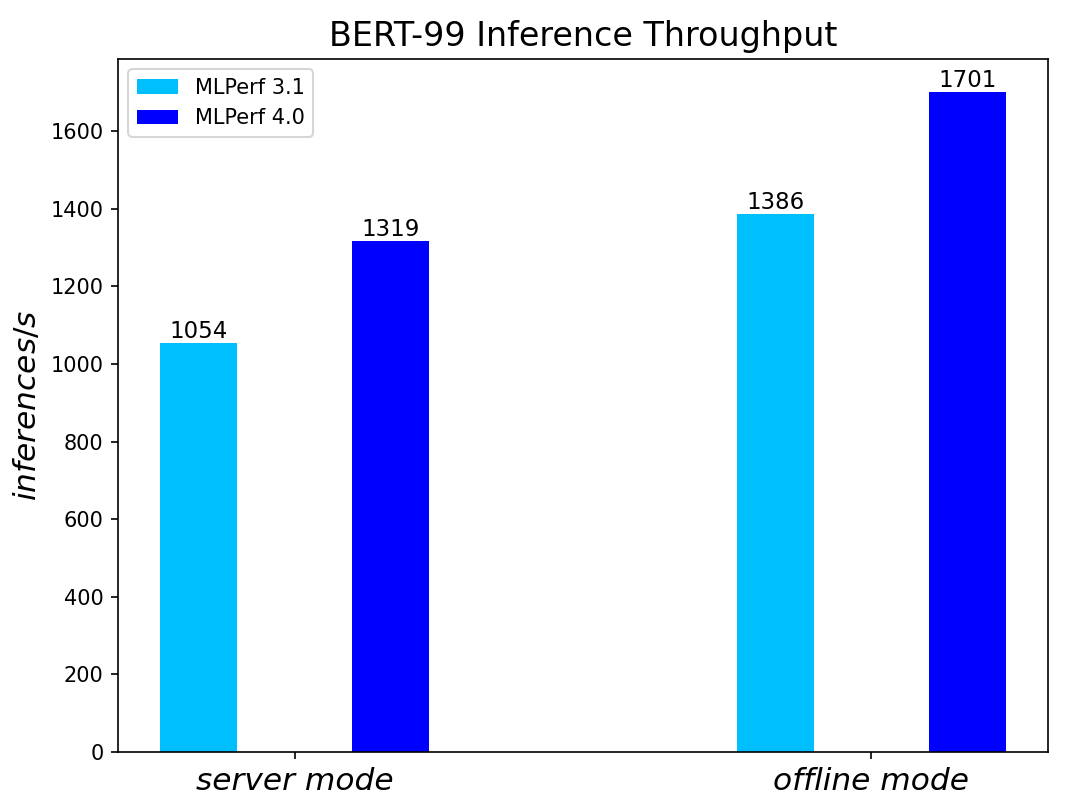

Cả hai kết quả điểm chuẩn MLPerf™ v3.1 và MLPerf™ v4.0 đều dựa trên máy chủ Dell R760 nhưng với các thế hệ CPU Xeon® khác nhau ( CPU Intel ® Xeon ® thế hệ thứ 4 cho MLPerf™ v3.1 so với Intel ® thế hệ thứ 5 CPU Xeon ® cho MLPerf™ v4.0) và các gói phần mềm được tối ưu hóa. Trong phần này, chúng tôi hiển thị hiệu suất ở chế độ so sánh để có thể dễ dàng quan sát thấy sự cải thiện so với lần gửi trước.

So sánh Hiệu suất từ MLPerf TM v4.0 với MLPerf TM v3.1

Máy chủ ResNet50 và các tình huống ngoại tuyến:

Hình 3. Thông lượng suy luận ResNet50 trong các kịch bản máy chủ và ngoại tuyến

Máy chủ Mô hình ngôn ngữ lớn BERT và các kịch bản ngoại tuyến:

Hình 4. Kết quả suy luận BERT cho các kịch bản máy chủ và ngoại tuyến

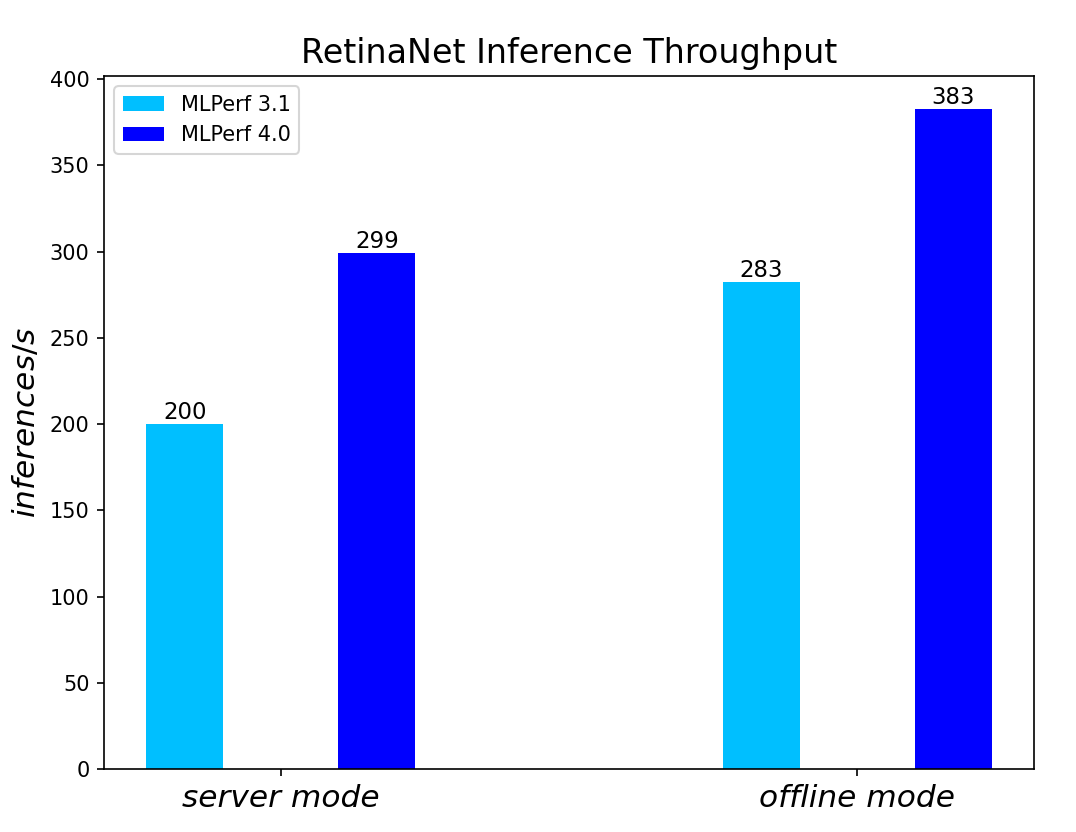

Máy chủ mô hình phát hiện đối tượng RetinaNet và các tình huống ngoại tuyến:

Hình 5. Kết quả suy luận của Mô hình phát hiện đối tượng RetinaNet cho các kịch bản máy chủ và ngoại tuyến

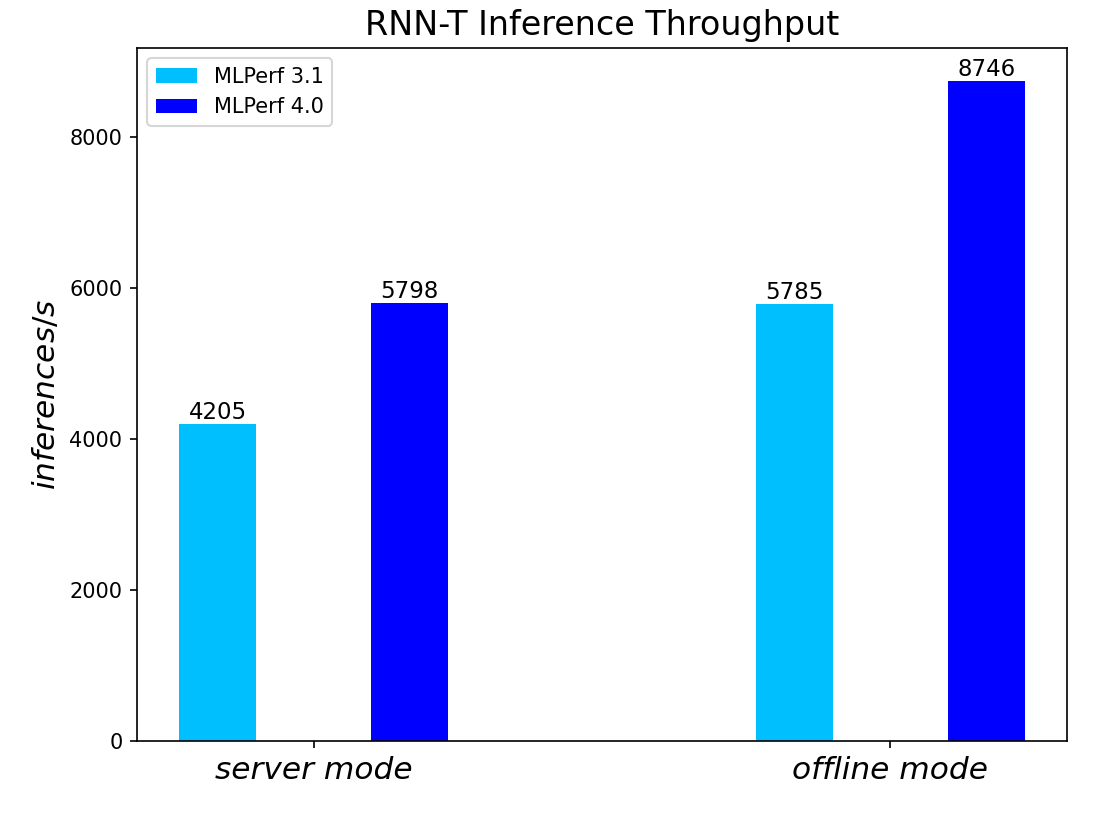

Máy chủ Mô hình chuyển văn bản thành giọng nói RNN-T và các tình huống ngoại tuyến:

Hình 6. Kết quả suy luận mô hình chuyển văn bản thành giọng nói RNN-T cho các kịch bản máy chủ và ngoại tuyến

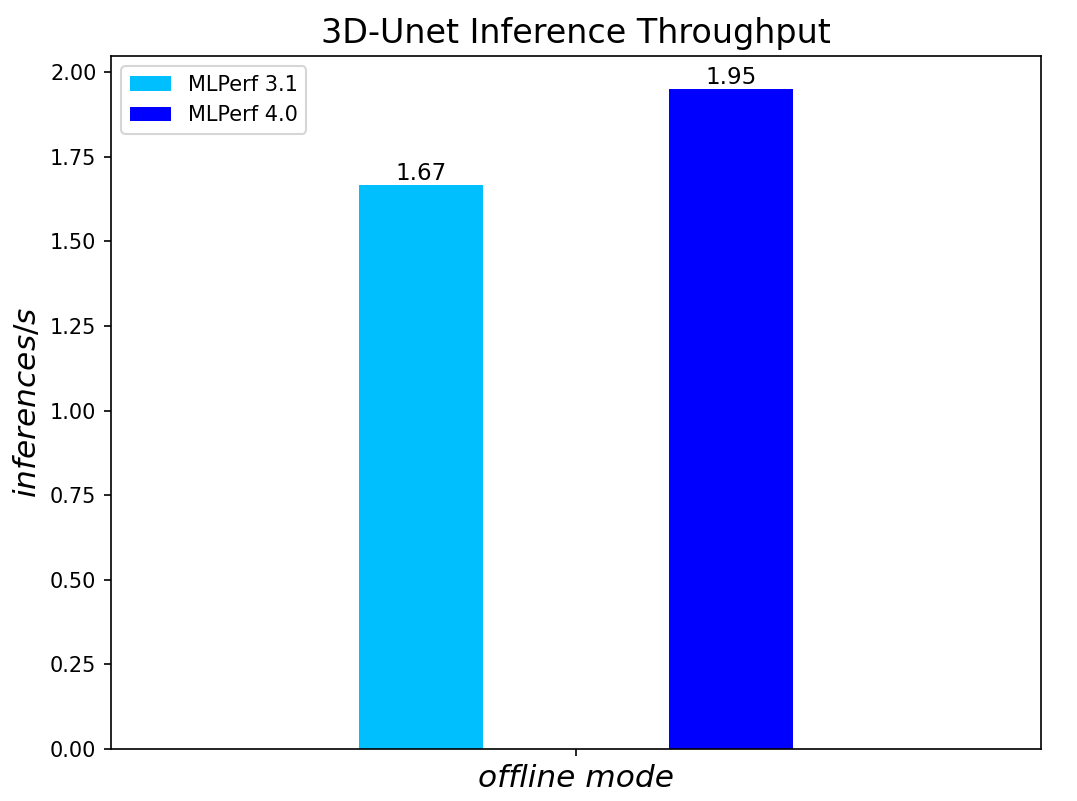

Các tình huống ngoại tuyến của Mô hình hình ảnh y tế 3D-Unet:

Hình 7. Kết quả suy luận mô hình hình ảnh y tế 3D-Unet cho các kịch bản máy chủ và ngoại tuyến

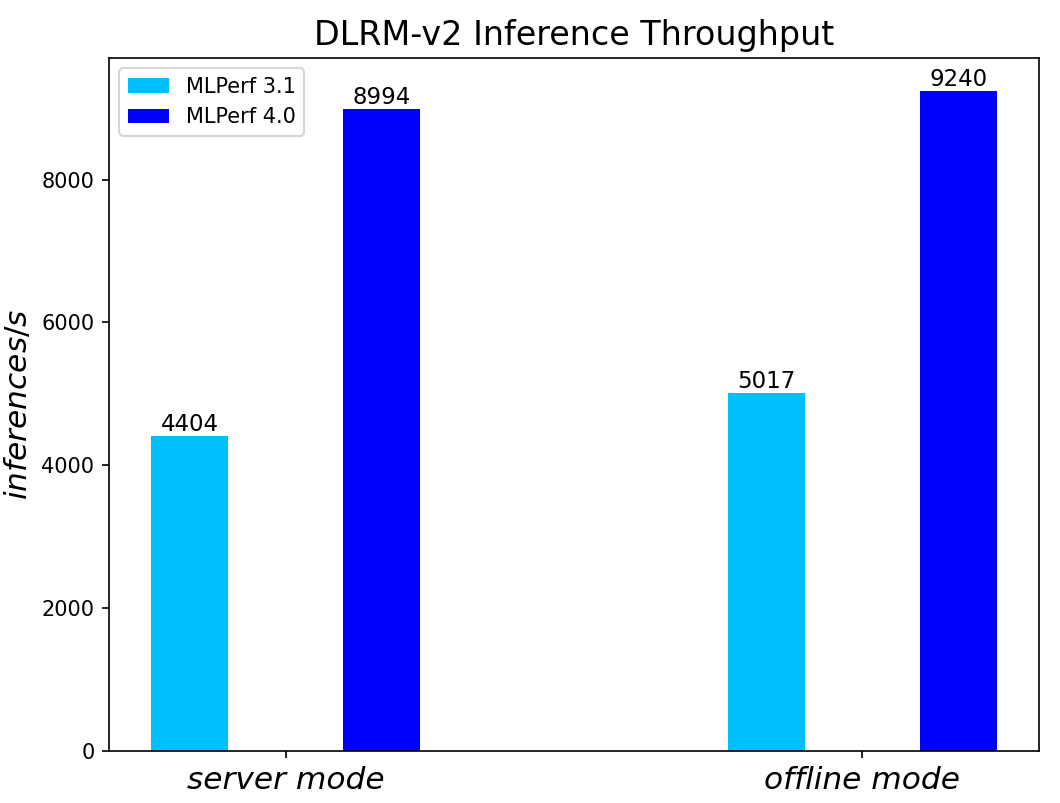

Khuyến nghị DLRMv2-99 Mô hình máy chủ và các tình huống ngoại tuyến:

Hình 8. Kết quả suy luận mô hình khuyến nghị DLRMv2-99 cho các kịch bản máy chủ và ngoại tuyến

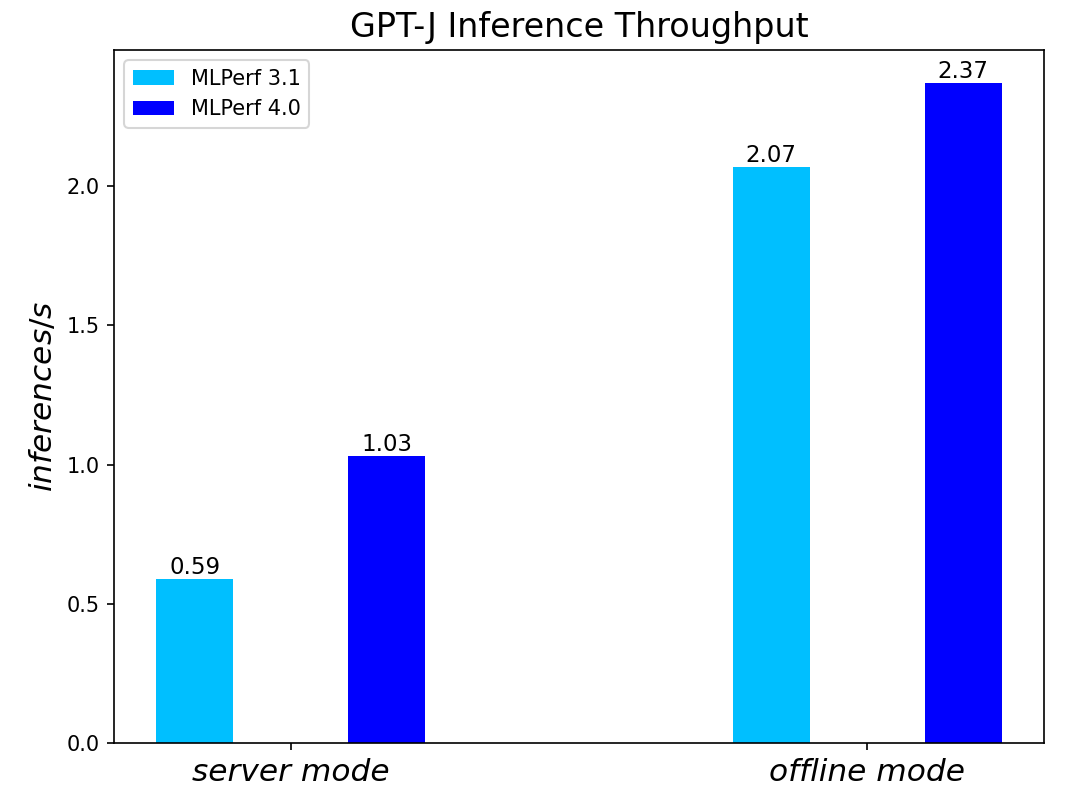

Máy chủ và các tình huống ngoại tuyến của Mô hình tóm tắt GPT-J-99:

Hình 9. Kết quả suy luận mô hình tóm tắt GPT-J-99 cho các kịch bản máy chủ và ngoại tuyến

Phần kết luận

- Máy chủ PowerEdge R760 với Bộ xử lý có khả năng mở rộng Intel® Xeon® thế hệ thứ 5 tạo ra hiệu năng suy luận trung tâm dữ liệu mạnh mẽ, được xác nhận bằng kết quả đo điểm chuẩn phiên bản 4.0 MLPerf TM chính thức từ MLCommons TM .

- Hiệu suất cao và tính linh hoạt được thể hiện qua các hệ thống xử lý ngôn ngữ tự nhiên, phân loại hình ảnh, phát hiện đối tượng, hình ảnh y tế, suy luận từ giọng nói thành văn bản, đề xuất và tóm tắt.

- So với các bản gửi phiên bản 3.0 và 3.1 trước đó được hỗ trợ bởi Bộ xử lý có khả năng mở rộng Intel® Xeon® thế hệ thứ 4 , R760 với Bộ xử lý có khả năng mở rộng Intel® Xeon® thế hệ thứ 5 cho thấy sự cải thiện hiệu suất đáng kể trên các mô hình khác nhau, bao gồm cả các mô hình AI tổng hợp như GPT-J .

- R760 hỗ trợ các kịch bản suy luận học sâu khác nhau trong các kịch bản điểm chuẩn MLPerf TM cũng như các khối lượng công việc phức tạp khác như cơ sở dữ liệu và phân tích nâng cao. Đây là giải pháp lý tưởng cho việc hiện đại hóa trung tâm dữ liệu nhằm nâng cao hiệu quả hoạt động, mang lại năng suất cao hơn và giảm thiểu tổng chi phí sở hữu (TCO).

Bài viết mới cập nhật

Tăng tốc khối lượng công việc của Hệ thống tệp mạng (NFS) của bạn với RDMA

Giao thức NFS hiện nay được sử dụng rộng rãi trong ...

Mẹo nhanh về dữ liệu phi cấu trúc – OneFS Protection Overhead

Gần đây đã có một số câu hỏi từ lĩnh vực ...

Giới thiệu Dell PowerScale OneFS dành cho Quản trị viên NetApp

Để các doanh nghiệp khai thác được lợi thế của công ...

Cơ sở hạ tầng CNTT: Mua hay đăng ký?

Nghiên cứu theo số liệu của IDC về giải pháp đăng ...