Tin tức

Thiết kế được xác thực của Dell cho bộ lưu trữ pixstor HPC – Cập nhật PowerVault ME5

Giới thiệu

Môi trường HPC ngày nay có nhu cầu lưu trữ tốc độ cao ngày càng tăng. Việc lưu trữ đang trở thành nút thắt cổ chai trong nhiều khối lượng công việc do số lượng CPU nhiều hơn, bộ nhớ lớn hơn và nhanh hơn, bus PCIe nhanh hơn và mạng ngày càng nhanh hơn. Hệ thống tệp song song (PFS) thường giải quyết các yêu cầu HPC có nhu cầu cao này. PFS cung cấp quyền truy cập đồng thời vào một tệp hoặc một tập hợp tệp từ nhiều nút, phân phối dữ liệu một cách hiệu quả và an toàn tới nhiều LUN trên một số máy chủ lưu trữ.

Các hệ thống tệp này sử dụng phương tiện quay để cung cấp dung lượng cao nhất với chi phí thấp nhất. Tuy nhiên, tốc độ và độ trễ của phương tiện quay thường không thể theo kịp nhu cầu của nhiều khối lượng công việc HPC hiện đại. Việc sử dụng công nghệ flash (nghĩa là NVMe) dưới dạng bộ đệm liên tục, các tầng nhanh hơn hoặc thậm chí là cào nhanh (cục bộ hoặc phân tán) có thể giảm thiểu vấn đề này. HPC pixstor Storage cung cấp các nút NVMe và tầng dung lượng cao, tiết kiệm chi phí làm thành phần để giải quyết các nhu cầu băng thông cao và cho mô-đun Siêu dữ liệu nhu cầu cao tùy chọn.

Blog này là một phần trong loạt bài về các giải pháp PFS cho môi trường HPC, đặc biệt là cho Bộ lưu trữ pixstor HPC linh hoạt, có thể mở rộng, hiệu quả và đáng tin cậy . Trọng tâm của nó là nâng cấp các nút lưu trữ sử dụng mảng Dell PowerVault ME5084 mới, mang lại hiệu suất tăng đáng kể so với thế hệ trước (mảng ME4084).

Lưu ý : Vì arcastream đã thay đổi nhãn hiệu thành tất cả các ký tự chữ thường nên chúng tôi đã sửa đổi các phiên bản “arcastream”, “pixstor” và “ngenea” cho phù hợp.

Ngành kiến trúc

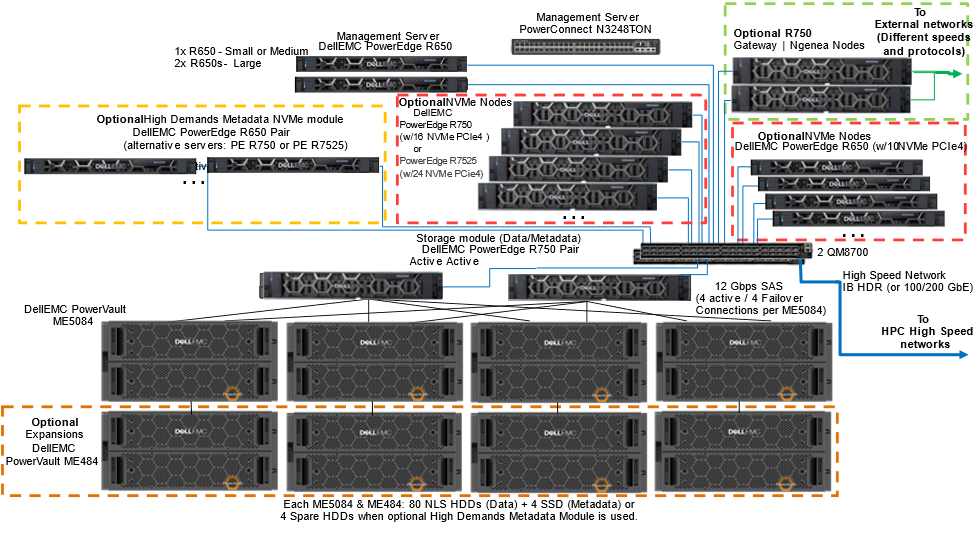

Hình dưới đây thể hiện kiến trúc cho thế hệ mới của Thiết kế được xác thực của Dell cho Bộ lưu trữ pixstor HPC. Nó sử dụng máy chủ Dell PowerEdge R650, R750 và R7525 cũng như mảng lưu trữ PowerVault ME5084 mới, với phần mềm pixstor 6.0 từ công ty đối tác arcastream của chúng tôi.

Hình 1 Kiến trúc tham khảo

Các mảng EBOD PowerVault ME484 tùy chọn có thể tăng dung lượng của giải pháp khi SAS bổ sung vào mảng lưu trữ PowerVault ME5084. Phần mềm pixstor bao gồm Hệ thống tệp song song chung (GPFS) phổ biến rộng rãi, còn được gọi là Thang đo phổ, là thành phần PFS được coi là bộ lưu trữ do phần mềm xác định do tính linh hoạt và khả năng mở rộng của nó. Ngoài ra, phần mềm pixstor bao gồm nhiều thành phần phần mềm arcastream khác như phân tích nâng cao, quản trị và giám sát đơn giản hóa, tìm kiếm tệp hiệu quả, khả năng cổng nâng cao và nhiều tính năng khác.

Các thành phần chính của giải pháp pixstor là:

- Máy chủ quản lý —Máy chủ PowerEdge R650 cung cấp quyền truy cập UI và CLI để quản lý và giám sát giải pháp pixstor, cũng như thực hiện các khả năng tìm kiếm nâng cao, biên soạn một số thông tin siêu dữ liệu trong cơ sở dữ liệu để tăng tốc tìm kiếm và ngăn tìm kiếm tải các đĩa chia sẻ mạng siêu dữ liệu ( NSD).

- Mô-đun lưu trữ —Mô-đun lưu trữ là khối xây dựng chính cho giải pháp lưu trữ pixstor. Mỗi mô-đun bao gồm:

- Một cặp máy chủ lưu trữ

- Một, hai hoặc bốn mảng lưu trữ phụ trợ (ME5084) với khả năng mở rộng dung lượng tùy chọn (ME484)

- Đĩa chia sẻ mạng (NSD) có trong mảng lưu trữ phụ trợ

- Máy chủ lưu trữ (SS) —Máy chủ lưu trữ là một thành phần mô-đun lưu trữ thiết yếu. Cặp máy chủ PowerEdge R750 HA (miền chuyển đổi dự phòng) kết nối với mảng ME5084 bằng cáp SAS 12 Gbps để quản lý NSD dữ liệu và cung cấp quyền truy cập vào NSD bằng giao diện mạng tốc độ cao dự phòng. Đối với cấu hình pixstor tiêu chuẩn, các máy chủ này có vai trò kép là máy chủ siêu dữ liệu và quản lý NSD siêu dữ liệu (sử dụng ổ SSD thay thế tất cả các ổ cứng dự phòng). Hình sau đây hiển thị cách phân bổ bộ điều hợp cho máy chủ PowerEdge R750:

Hình 2 Các nút lưu trữ PowerEdge R750 – Phân bổ khe cắm

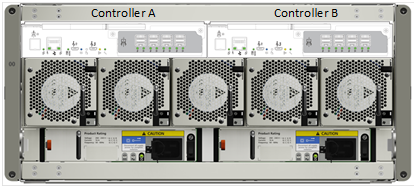

- Lưu trữ phụ trợ —Lưu trữ phụ trợ là một phần của mô-đun lưu trữ lưu trữ dữ liệu hệ thống tệp, như trong Hình 1. Giải pháp sử dụng mảng đĩa 5U PowerVault ME5084 mật độ cao. Hình dưới đây cho thấy mảng ME5084 với hai bộ điều khiển SAS. Hai cổng SAS từ mỗi bộ điều khiển (hai cổng từ A0-A3 và hai cổng từ B0-B3) được kết nối với các HBA khác nhau ở các khe 1, 2, 5 và 7 trên mỗi nút lưu trữ (bốn cáp SAS trên mỗi máy chủ cho mỗi mảng ME5084) . Mảng ME5084 yêu cầu gấp đôi số lượng cáp mà mảng ME4 sử dụng trước đây để phù hợp với hiệu suất ME5. Đầu nối SAS I/O của mỗi bộ điều khiển (cạnh cổng Ethernet quản lý RJ45) được dùng để kết nối Mô-đun I/O (IOM) trong mảng mở rộng ME484 sử dụng cổng I/O 0 (cổng SAS màu xanh bên trái của mỗi mô-đun IOM ) của Mô-đun I/O tương ứng (Bộ điều khiển A đến Mô-đun I/O A, Bộ điều khiển B đến Mô-đun I/O B).

Hình 3 Mảng ME5084 – Bộ điều khiển và cổng SAS

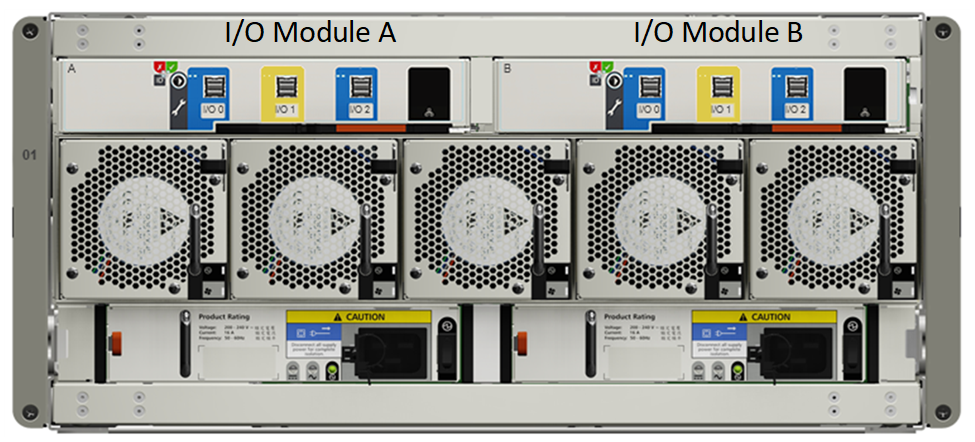

Hình dưới đây cho thấy mặt sau của mảng mở rộng ME484.

- Mở rộng dung lượng lưu trữ —Mở rộng dung lượng PowerVault ME484 tùy chọn (được hiển thị trong hình sau và bên trong hình vuông màu cam chấm trong Hình 1) được kết nối phía sau mảng ME5084 bằng cáp SAS 12 Gbps để mở rộng dung lượng của mô-đun lưu trữ. Đối với các giải pháp pixstor, mỗi mảng ME5084 bị hạn chế chỉ sử dụng một bản mở rộng ME484 để có hiệu suất và độ tin cậy (mặc dù ME5084 chính thức hỗ trợ tối đa ba bản mở rộng ME484).

Hình 4 ME484 – Module I/O và cổng SAS

- Đĩa chia sẻ mạng (NSD) —NSD là thiết bị khối phụ trợ (nghĩa là RAID 6 LUN từ mảng ME5 hoặc thiết bị NVMe sao chép) lưu trữ dữ liệu, siêu dữ liệu hoặc cả hai. Trong giải pháp pixstor, dữ liệu hệ thống tệp và siêu dữ liệu được lưu trữ trong các NSD khác nhau. NSD dữ liệu sử dụng phương tiện quay (HDD NLS SAS3) hoặc NVMe. NSD siêu dữ liệu sử dụng SSD ở cấu hình tiêu chuẩn hoặc thiết bị NVMe được sao chép cho nhu cầu siêu dữ liệu cao (siêu dữ liệu bao gồm thư mục, tên tệp, quyền, dấu thời gian và vị trí của dữ liệu trong các NSD khác).

- Máy chủ siêu dữ liệu nhu cầu cao (HDMD) —Máy chủ HDMD là một thành phần của mô-đun Siêu dữ liệu nhu cầu cao tùy chọn (trong hình vuông chấm màu vàng trong Hình 1). Các cặp máy chủ PowerEdge R650 NVMe có tối đa 10 thiết bị NVMe trong HA (miền chuyển đổi dự phòng) quản lý siêu dữ liệu NSD theo cặp được sao chép và cung cấp quyền truy cập bằng giao diện mạng tốc độ cao dự phòng. Các máy chủ được hỗ trợ khác (máy chủ PowerEdge R750 và PowerEdge R7525) có thể được sử dụng làm nút NVMe thay vì máy chủ PowerEdge R650.

- Nút NVMe —Nút NVMe là thành phần chính của các mô-đun cấp NVMe tùy chọn (trong các ô vuông màu đỏ có chấm ở Hình 2). Các cặp máy chủ PowerEdge mới nhất trong HA (miền chuyển đổi dự phòng) cung cấp tầng dựa trên flash hiệu suất cao cho giải pháp pixstor. Cấp NVMe bao gồm ba máy chủ PowerEdge: máy chủ PowerEdge R650 với 10 ổ đĩa gắn trực tiếp NVMe, máy chủ PowerEdge R750 với 16 thiết bị gắn trực tiếp NVMe hoặc máy chủ PowerEdge R7525 với 24 ổ đĩa gắn trực tiếp. Để duy trì hiệu suất đồng nhất trên các nút NVMe và cho phép phân chia dữ liệu giữa các nút trong cấp, không kết hợp các mô hình máy chủ khác nhau trong cùng một cấp NVMe. Tuy nhiên, hỗ trợ nhiều cấp NVMe với mỗi máy chủ khác nhau và được truy cập bằng các tập hợp tệp khác nhau.

Các máy chủ PowerEdge được chọn hỗ trợ các thiết bị NVMe PCIe4 và PCIe3. Tuy nhiên, việc kết hợp các thiết bị NVMe PCIe4 với các thiết bị PCIe3 hiệu suất thấp hơn không được khuyến nghị cho giải pháp này và giải pháp này không được hỗ trợ cho cùng cấp NVMe. Các cặp nút NVMe bổ sung có thể mở rộng hiệu suất và dung lượng cho cấp NVMe này. Dung lượng tăng được cung cấp bằng cách chọn dung lượng phù hợp cho các thiết bị NVMe được hỗ trợ trên máy chủ hoặc thêm nhiều cặp máy chủ.

Một điểm khác biệt quan trọng so với các bản phát hành pixstor trước đó là NVMesh không còn là một thành phần của giải pháp nữa. Vì mục đích HA, một giải pháp thay thế dựa trên bản sao NSD của GPFS đã được triển khai trên mỗi cặp HA của máy chủ NVMe để có các NSD được phản chiếu về mặt chức năng.

- Phần mềm máy khách gốc —Phần mềm máy khách gốc được cài đặt trên máy khách để cho phép truy cập vào hệ thống tệp. Hệ thống tệp phải được gắn kết để truy cập và xuất hiện dưới dạng một không gian tên duy nhất.

- Các nút cổng —Các nút cổng tùy chọn (trong hình vuông có chấm màu xanh lục trong Hình 1) là các máy chủ PowerEdge R750 (cùng phần cứng với các nút ngenea nhưng có phần mềm khác) trong cụm Cơ sở dữ liệu tầm thường theo cụm (CTDB) Samba cung cấp quyền truy cập NFS hoặc SMB dành cho các máy khách chưa có hoặc không thể cài đặt phần mềm máy khách gốc.

- nút ngenea —Các nút ngenea tùy chọn (trong hình vuông có chấm màu xanh lục trong Hình 1) là các máy chủ PowerEdge R750 (cùng phần cứng với các nút cổng nhưng sử dụng phần mềm khác) cung cấp quyền truy cập vào các hệ thống lưu trữ bên ngoài (ví dụ: lưu trữ đối tượng, lưu trữ đám mây , thư viện băng từ, v.v.) cho phép sử dụng chúng như một tầng khác trong cùng một không gian tên bằng các giao thức doanh nghiệp, bao gồm cả giao thức đám mây.

- Bộ chuyển mạch quản lý —Bộ chuyển mạch Gigabit Ethernet PowerConnect N2248X-ON kết nối các máy chủ và mảng lưu trữ khác nhau. Nó được sử dụng để quản lý giải pháp kết nối tất cả các thành phần.

- Bộ chuyển mạch mạng tốc độ cao — Bộ chuyển mạch Mellanox QM8700 cung cấp khả năng truy cập tốc độ cao bằng cách sử dụng InfiniBand (IB) HDR. Đối với các giải pháp Ethernet, Mellanox SN3700 được sử dụng.

Thành phần giải pháp

Giải pháp này được phát hành cùng với CPU Intel Xeon có khả năng mở rộng thế hệ thứ 3 mới nhất, còn được gọi là Ice Lake và RAM nhanh nhất hiện có (3200 MT/s). Bảng sau liệt kê các thành phần chính của giải pháp. Một số khác biệt đã được đưa ra giữa BOM mong muốn và phần cứng thử nghiệm thực tế vì đối với phần cứng phát hành trước (mức sản xuất) cho dự án của chúng tôi, chỉ có một số mẫu CPU được cung cấp, không bao gồm mô hình vòng đời theo kế hoạch.

Cột Lúc phát hành liệt kê các thành phần dự kiến sẽ được sử dụng khi phát hành và có sẵn cho khách hàng cùng với giải pháp. Cột Giường thử nghiệm liệt kê các thành phần thực sự được sử dụng để mô tả đặc tính hiệu suất của giải pháp. Các ổ đĩa được liệt kê cho dữ liệu (12 TB NLS) đã được sử dụng để mô tả đặc tính hiệu suất, nhưng tất cả các ổ cứng và SSD được hỗ trợ trong Ma trận hỗ trợ PowerVault ME5 đều có thể được sử dụng cho giải pháp. Do bộ điều khiển ME5 không còn là nút thắt cổ chai đầu tiên của bộ lưu trữ phụ trợ nên việc sử dụng ổ đĩa có tốc độ định mức cao hơn (10K, 15K và SSD) có thể giúp tăng hiệu suất tuần tự (dự kiến tối đa khoảng 30 đến 35 phần trăm cho thông lượng) , có thể cung cấp IOPS ngẫu nhiên tốt hơn và có thể cải thiện các hoạt động tạo và xóa siêu dữ liệu. Để dự phòng mạng tốc độ cao hoàn toàn, phải sử dụng hai bộ chuyển mạch tốc độ cao (QM87000 cho IB hoặc SN3700 cho GbE); mỗi switch phải có một bộ chuyển đổi CX6 được kết nối từ mỗi máy chủ.

Các thành phần phần mềm được liệt kê mô tả các phiên bản được sử dụng trong quá trình thử nghiệm ban đầu. Tuy nhiên, các phiên bản phần mềm này có thể thay đổi theo thời gian giữa các bản phát hành chính thức để bao gồm các bản sửa lỗi quan trọng, hỗ trợ các thành phần phần cứng mới hoặc bổ sung các tính năng quan trọng.

Bảng liệt kê các ổ cứng và SSD dữ liệu có thể có, được liệt kê trong Ma trận hỗ trợ Dell PowerVault ME5 .

Bảng 1 . Các thành phần được sử dụng tại thời điểm phát hành và trên giường thử nghiệm

| Thành phần giải pháp | Lúc phát hành | Giường thử nghiệm | |

| Công tắc quản lý nội bộ | Dell PowerSwitch N2248X-ON GbE | Công tắc nguồn S3048-ON | |

| Hệ thống con lưu trữ dữ liệu | 1 x đến 4 x mảng PowerVault ME5084 | 2 x mảng Dell PowerVault ME5084 | |

| Tùy chọn 4x PowerVault ME484 (một cho mỗi mảng ME5084)

Ổ cứng 80 – 12 TB 3,5” NL SAS3 Tùy chọn thay thế: 15K RPM: 900GB; 10K vòng/phút: 1,2 TB, 2,4 TB SSD: 960GB, 1,92 TB, 3,84 TB; NLS: 4 TB, 8 TB, 12 TB, 16 TB, 20 TB 8 LUN, 8+2 RAID 6 tuyến tính, kích thước khối 512 KiB 4 – 1,92 TB (hoặc 3,84 TB hoặc 7,68 TB) SSD SAS3 trên mỗi mảng ME5084 cho siêu dữ liệu – 2 x RAID 1 (hoặc 4 – Ổ cứng dự phòng toàn cầu, nếu sử dụng HDMD tùy chọn) |

|||

| Hệ thống con lưu trữ HDMD tùy chọn | Một hoặc nhiều cặp máy chủ cấp NVMe | ||

| Bộ điều khiển lưu trữ RAID | SAS song công 12 Gbps | ||

| Dung lượng không cần mở rộng (với ổ cứng 12 TB) | Nguyên: 4032 TB (3667 TiB hoặc 3,58 PiB)

Được định dạng: khoảng 3072 GB (2794 TiB hoặc 2,73 PiB) |

||

| Công suất mở rộng (Lớn)

(Ổ cứng 12 TB) |

Nguyên: 8064 TB (7334 TiB hoặc 7,16 PiB)

Được định dạng: khoảng 6144 GB (5588 TiB hoặc 5,46 PiB) |

||

| Bộ xử lý | Cổng/ngenea | 2 x Intel Xeon Gold 6326 2,9 GHz, 16C/32T, 11,2GT/s, 24M Cache, Turbo, HT (185 W) DDR4-3200 | 2 x Intel Xeon Platinum 8352Y

2,2 GHz, 32C/64T, 11,2GT/giây, Bộ nhớ đệm 48M, Turbo, HT (205 W) DDR4-3200 |

| Nút lưu trữ | |||

| Nút quản lý | 2x Intel Xeon Gold 6330 2 GHz, 28C/56T, 11,2GT/s, 42M Cache, Turbo, HT (185 W) DDR4-2933 | ||

| Nút R650 NVMe | 2x Intel Xeon Gold 6354 3,00 GHz, 18C/36T, 11,2GT/s, 39M Cache, Turbo, HT (205 W) DDR4-3200 | ||

| Siêu dữ liệu có nhu cầu cao tùy chọn | 2x Intel Xeon Gold 6354 3,00 GHz, 18C/36T, 11,2GT/s, 39M Cache, Turbo, HT (205 W) DDR4-3200 | ||

| Nút R750 NVMe | 2x Intel Xeon Platinum 8352Y, 2,2 GHz, 32C/64T, 11,2GT/s, 48M Cache, Turbo, HT (205 W) DDR4-3200 | ||

| Các nút NVMe R7525 | 2 x AMD EPYC 7302 3.0 GHz, 16C/32T, 128M L3 (155 W) | 2 x AMD 7H12 2,6 GHz, 64C/64T 256M L3 (280 W) | |

| Ký ức

|

Cổng/ngenea | 16 x 16 GiB 3200 MT/s RDIMM (256 GiB) | |

| Nút lưu trữ | |||

| Nút quản lý | |||

| Hệ điều hành | Red Hat Enterprise Linux 8.5 | ||

| Phiên bản hạt nhân | 4.18.0-348.23.1.el8_5.x86_64 | ||

| phần mềm pixstor | 6.0.3.1-1 | ||

| Thang đo phổ (GPFS) | Thang đo phổ (GPFS) 5.1.3-1 | ||

| Phiên bản OFED | Mellanox OFED 5.6-1.0.3.3 | ||

| NIC hiệu suất cao | Tất cả: 2 x Dell OEM ConnectX-6 Cổng đơn HDR VPI InfiniBand, Cấu hình thấp

Nút cổng và ngenea: 4x bộ điều hợp CX6 VPI, 2x FS & 2x Bên ngoài |

||

| Công tắc hiệu suất cao | Tất cả: 2 x Dell OEM ConnectX-6 Cổng đơn HDR VPI InfiniBand, Cấu hình thấp

Nút cổng và ngenea: 4x bộ điều hợp CX6 VPI, 2x FS & 2x Bên ngoài |

||

| Đĩa cục bộ (hệ điều hành và phân tích/giám sát) | Máy chủ NVMe: BOSS-S2 với 2x M.2 240 GB trong RAID 1

Các máy chủ khác: 3x 480 GB SSD SAS3 (RAID 1 + HS) dành cho hệ điều hành với bộ điều khiển RAID phía trước PERC H345 |

||

| Quản lý hệ thống | iDRAC9 Enterprise + Dell OpenQuản lý 10.0.1-4561 | ||

Đặc tính hiệu suất

Để mô tả thành phần giải pháp mới (mảng ME5084), chúng tôi đã sử dụng các điểm chuẩn sau:

- IOzone N đến N tuần tự

- IOR N tới 1 tuần tự

- IOzone ngẫu nhiên

- kiểm tra MD

Sự chậm trễ trong việc cung cấp mảng ME5084 cần thiết cho việc cập nhật giải pháp đã gây ra hạn chế không mong muốn. Do đó, số lượng nguyên mẫu ME5 có sẵn cho giải pháp đã hạn chế công việc này. Chỉ có hai mảng ME5084 được sử dụng cho các bài kiểm tra điểm chuẩn, tương tự như cấu hình Trung bình. Tuy nhiên, để so sánh kết quả với thế hệ trước của mảng PowerVault (ME4084), tất cả kết quả IOzone và IOR đều được ngoại suy cho cấu hình lớn bằng cách nhân kết quả với 2. Khi mảng ME5084 bổ sung được phân phối, tất cả các bài kiểm tra điểm chuẩn sẽ được lặp lại trên cấu hình Lớn, sau đó sử dụng lại bản mở rộng ME484.

Đối với các điểm chuẩn này, giường thử nghiệm bao gồm các khách hàng trong bảng sau:

Bảng 2 Giường thử nghiệm của khách hàng

| Thành phần | Sự miêu tả |

| Số lượng nút khách hàng | 16 |

| Nút khách hàng | C6420 |

| Bộ xử lý trên mỗi nút máy khách | 11 nút với 2 x Intel Xeon Gold 6230 20 lõi @ 2,1 GHz

5 nút với 2 x Intel Xeon Gold 6248 20 lõi @ 2,4 GHz |

| Bộ nhớ trên mỗi nút máy khách | 6230 nút với RDIMM 12 x 16 GiB 2933 MT/s (192 GiB)

6248 nút với RDIMM 12 x 16 GiB 2666 MT/s (192 GiB) |

| BIOS | 2.8.2 |

| Hệ điều hành | CentOS 8.4.2105 |

| Hạt nhân hệ điều hành | 4.18.0-305.12.1.el8_4.x86_64 |

| phần mềm pixstor | 6.0.3.1-1 |

| Thang đo phổ (GPFS) | 5.1.3-0 |

| Phiên bản OFED | MLNX_OFED_LINUX-5.4-1.0.3.0 |

| CX6 FW | 8 nút có cổng đơn Mellanox CX6: 20.32.1010

8 nút có cổng đơn Dell OEM CX6: 31.20.2006 |

Vì chỉ có 16 nút điện toán có sẵn để thử nghiệm nên khi cần số lượng luồng cao hơn, các luồng đó sẽ được phân bổ đều trên các nút điện toán (nghĩa là 32 luồng = 2 luồng trên mỗi nút, 64 luồng = 4 luồng trên mỗi nút, 128 luồng = 8 luồng trên mỗi nút, 256 luồng = 16 luồng trên mỗi nút, 512 luồng = 32 luồng trên mỗi nút, 1024 luồng = 64 luồng trên mỗi nút). Mục đích là để mô phỏng số lượng máy khách đồng thời cao hơn với số lượng nút điện toán hạn chế. Vì điểm chuẩn hỗ trợ số lượng luồng cao nên giá trị tối đa lên tới 1024 đã được sử dụng (được chỉ định cho từng thử nghiệm), tránh chuyển đổi ngữ cảnh quá mức và các tác dụng phụ liên quan khác.

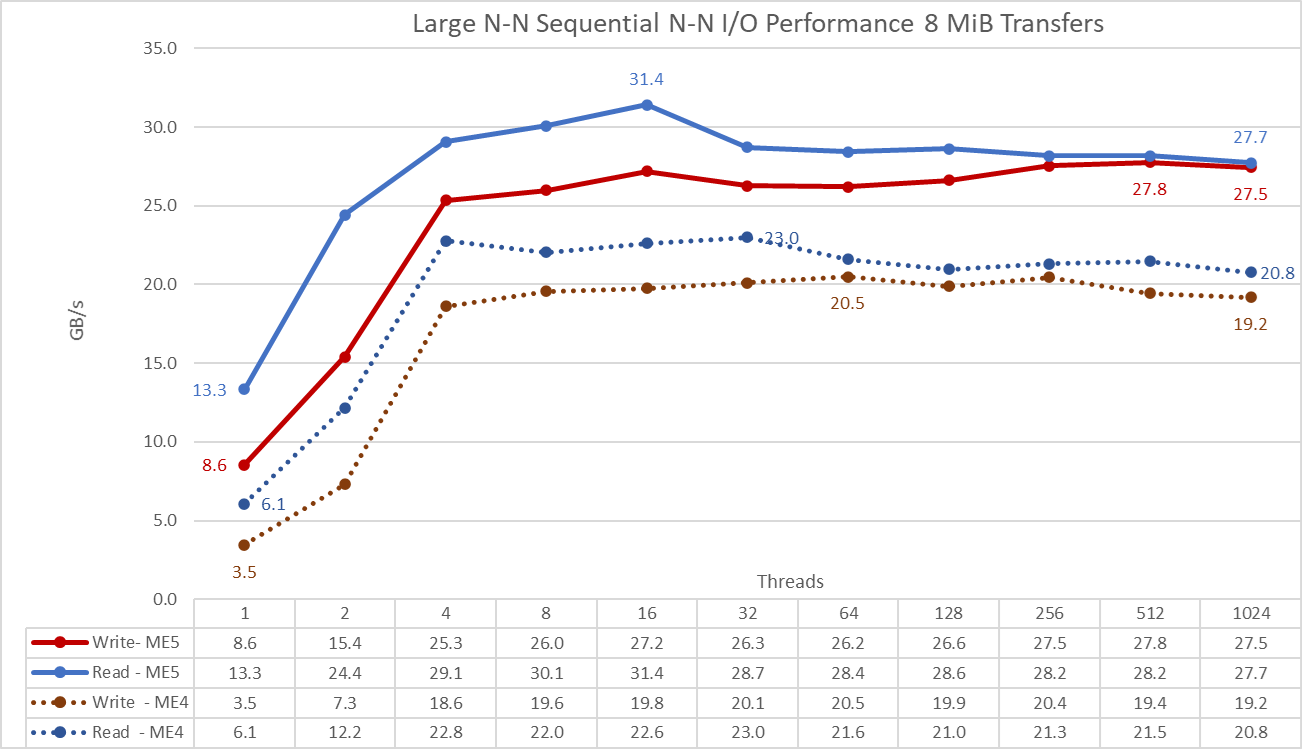

Trình tự IOzone Performance N client tới N file

Hiệu suất từ N máy khách đến N tệp tuần tự được đo bằng IOzone phiên bản 3.492. Các thử nghiệm mà chúng tôi đã chạy khác nhau, từ một luồng đơn cho đến 1024 luồng với lũy thừa là 2.

Chúng tôi đã giảm thiểu hiệu ứng bộ nhớ đệm bằng cách đặt nhóm trang GPFS có thể điều chỉnh thành 16 GiB trên máy khách và sử dụng các tệp lớn hơn gấp đôi kích thước bộ nhớ của máy chủ và máy khách (8 TiB). Lưu ý rằng GPFS đặt lượng bộ nhớ tối đa có thể điều chỉnh được sử dụng để lưu vào bộ đệm dữ liệu, bất kể dung lượng RAM được cài đặt và trống. Trong khi ở các giải pháp Dell HPC khác trong đó kích thước khối để truyền tuần tự lớn là 1 MiB, GPFS được định dạng bằng 8 khối MiB; do đó giá trị kích thước truyền được sử dụng làm điểm chuẩn để có hiệu suất tối ưu. Kích thước khối trên hệ thống tệp có vẻ quá lớn và lãng phí quá nhiều dung lượng, nhưng GPFS sử dụng phân bổ khối con để ngăn chặn tình trạng đó. Trong cấu hình hiện tại, mỗi khối được chia thành 512 khối con, mỗi khối 16 KiB.

Các lệnh sau được sử dụng để chạy điểm chuẩn cho các hoạt động đọc và ghi, trong đó biến $Threads là số lượng luồng được sử dụng (1 đến 1024 tăng theo lũy thừa 2) và danh sách luồng là tệp gán mỗi luồng trên một nút khác nhau , sử dụng phương pháp quay vòng để trải chúng một cách đồng nhất trên 16 nút điện toán.

Để tránh bất kỳ tác động nào có thể xảy ra với bộ nhớ đệm dữ liệu từ máy khách, tổng kích thước dữ liệu của tệp lớn hơn gấp đôi tổng dung lượng RAM mà máy khách và máy chủ có. Nghĩa là, vì mỗi máy khách có 128 GiB RAM (tổng cộng 2 TiB) và mỗi máy chủ có 256 GiB (tổng cộng 1 TiB), tổng số tiền là 3 TiB, nhưng 8 TiB dữ liệu đã được sử dụng. 8 TiB được chia đều cho số lượng luồng được sử dụng.

./iozone -i0 -c -e -w -r 8M -s ${Size}G -t $Threads -+n -+m ./threadlist

./iozone -i1 -c -e -w -r 8M -s ${Size}G -t $Threads -+n -+m ./threadlist

Hình 5 Hiệu suất tuần tự N đến N

QUAN TRỌNG: Để cho phép so sánh trực tiếp các giá trị mảng ME5 với các giá trị thu được trước đó bằng mảng ME4 trên biểu đồ, kết quả IOzone của cấu hình Trung bình (hai mảng ME5084) được nhân với 2 để ước tính hiệu suất của cấu hình Lớn (bốn mảng ME5084) .

Từ kết quả, chúng tôi thấy rằng hiệu suất ghi tăng lên theo số lượng luồng được sử dụng và sau đó đạt đến mức ổn định ở tám luồng cho các hoạt động đọc và ghi (giá trị ở bốn luồng nhỏ hơn một chút). Hiệu suất đọc tăng thêm một chút rồi giảm xuống giá trị ổn định hơn. Hiệu suất ghi có vẻ ổn định hơn hiệu suất đọc với một sự thay đổi nhỏ xung quanh hiệu suất ổn định ở mức ổn định.

Hiệu suất tối đa cho các hoạt động đọc là 31,4 GB/s ở 16 luồng, thấp hơn khoảng 34,5% so với thông số kỹ thuật của mảng ME5084 (khoảng 48 GB/s) và thấp hơn nhiều so với hiệu suất của các liên kết HDR (4 x 25 GB/s hoặc 100 GB/s). Ngay cả khi chỉ sử dụng một liên kết HDR trên mỗi máy chủ lưu trữ (tốc độ trần 50 GB/s), giá trị vẫn cao hơn thông số kỹ thuật của mảng 4 x ME5084. Hiệu suất ghi đạt mức cao nhất ở 512 luồng với tốc độ 27,8 GB/giây, nhưng giá trị tương tự cũng được quan sát thấy ở 32 luồng. Giá trị tối đa thấp hơn khoảng 30,5% so với thông số kỹ thuật ME5 (40 GB/s). Thử nghiệm ME5 ban đầu sử dụng các thiết bị thô có ổ SSD ở RAID (trên mảng ME5024) và ổ cứng HDD ở (8+2) RAID 6 (trên mảng ME5084) và nó có thể đạt được thông số kỹ thuật của bộ điều khiển. Do đó, giả định hiện tại là thời gian tìm kiếm do truy cập phân tán GPFS đưa ra (vị trí ngẫu nhiên của 8 khối GiB trên bề mặt của tất cả các ổ đĩa) đang hạn chế hiệu suất. Việc thêm các bản mở rộng ME484 có thể giúp đạt được hiệu suất gần hơn với thông số kỹ thuật vì việc có gấp đôi LUN sẽ giảm ảnh hưởng của thời gian tìm kiếm trên hệ thống tệp. Sách trắng tiếp theo của chúng tôi sẽ bao gồm hiệu suất của các bản mở rộng ME484 và các bài kiểm tra điểm chuẩn sẽ giải quyết giả định này.

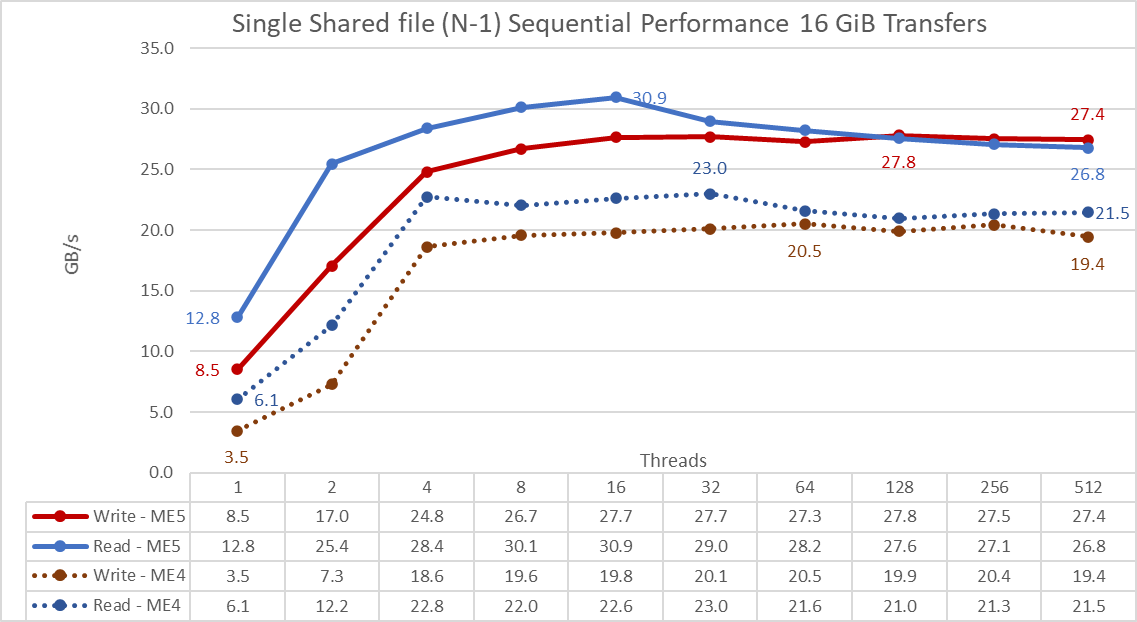

Trình tự IOR Performance N client thành 1 tệp

Hiệu suất của N máy khách tuần tự đối với một tệp chia sẻ duy nhất được đo bằng IOR phiên bản 3.3.0, với OpenMPI v4.1.2A1 để chạy điểm chuẩn trên 16 nút điện toán. Các thử nghiệm mà chúng tôi đã chạy khác nhau từ một luồng lên đến 512 luồng vì không có đủ lõi cho 1024 luồng trở lên. Điểm chuẩn này đã sử dụng 8 khối MiB để có hiệu suất tối ưu. Phần trước cung cấp giải thích đầy đủ hơn về lý do kích thước khối đó được chọn.

Chúng tôi đã giảm thiểu tác động của bộ nhớ đệm dữ liệu bằng cách đặt nhóm trang GPFS có thể điều chỉnh thành 16 GiB và tổng kích thước tệp thành 8192 GiB để đảm bảo cả máy khách và máy chủ đều không thể lưu vào bộ nhớ đệm bất kỳ dữ liệu nào. Một phần bằng nhau trong tổng số 8 TiB đó được chia cho số lượng luồng ( biến $Size trong đoạn mã sau quản lý giá trị đó).

Các lệnh sau được sử dụng để chạy điểm chuẩn cho các hoạt động ghi và đọc, trong đó biến $Threads là số lượng luồng được sử dụng (tăng từ 1 đến 512 theo lũy thừa hai) và my_hosts.$Threads là tệp tương ứng được phân bổ từng luồng trên một nút khác, sử dụng phương pháp quay vòng để phân bổ chúng một cách đồng nhất trên 16 nút điện toán:

mpirun –allow-run-as-root -np $Threads –hostfile my_hosts.$Threads –mca btl_openib_allow_ib 1 –mca pml ucx –oversubscribe –prefix /usr/mpi/gcc/openmpi-4.1.2a1 – -map-by nút /mms1/bench/ior -a POSIX -v -i 1 -d 3 -e -k -o /mms1/perftest/tst.file -w -s 1 -t 8m -b ${Size} G

mpirun –allow-run-as-root -np $Threads –hostfile my_hosts.$Threads –mca btl_openib_allow_ib 1 –mca pml ucx –oversubscribe –prefix /usr/mpi/gcc/openmpi-4.1.2a1 – -map-by nút /mms1/bench/ior -a POSIX -v -i 1 -d 3 -e -k -o /mms1/perftest/tst.file -r -s 1 -t 8m -b ${Size} G

QUAN TRỌNG: Để cho phép so sánh trực tiếp các giá trị mảng ME5 với các giá trị thu được trước đó bằng mảng ME4 trên biểu đồ, kết quả IOzone của cấu hình Trung bình (hai mảng ME5084) được nhân với 2 để ước tính hiệu suất của cấu hình Lớn (bốn mảng ME5084) .

Từ kết quả, chúng tôi thấy rằng hiệu suất đọc và ghi đều cao bất kể nhu cầu tiềm ẩn về cơ chế khóa vì tất cả các luồng đều truy cập vào cùng một tệp. Hiệu năng tăng lên nhanh chóng theo số lượng luồng được sử dụng và sau đó đạt đến mức ổn định ở 8 luồng tương đối ổn định cho đến số lượng luồng tối đa được sử dụng trong bài kiểm tra này. Lưu ý rằng hiệu suất đọc tối đa là 30,9 GB/giây ở 16 luồng, nhưng tương tự như các thử nghiệm N đến N tuần tự, hiệu suất sẽ giảm nhẹ cho đến khi đạt giá trị ổn định hơn. Hiệu suất ghi tối đa 23 GB/giây đã đạt được ở 32 luồng và vẫn ổn định trên số lượng luồng cao hơn.

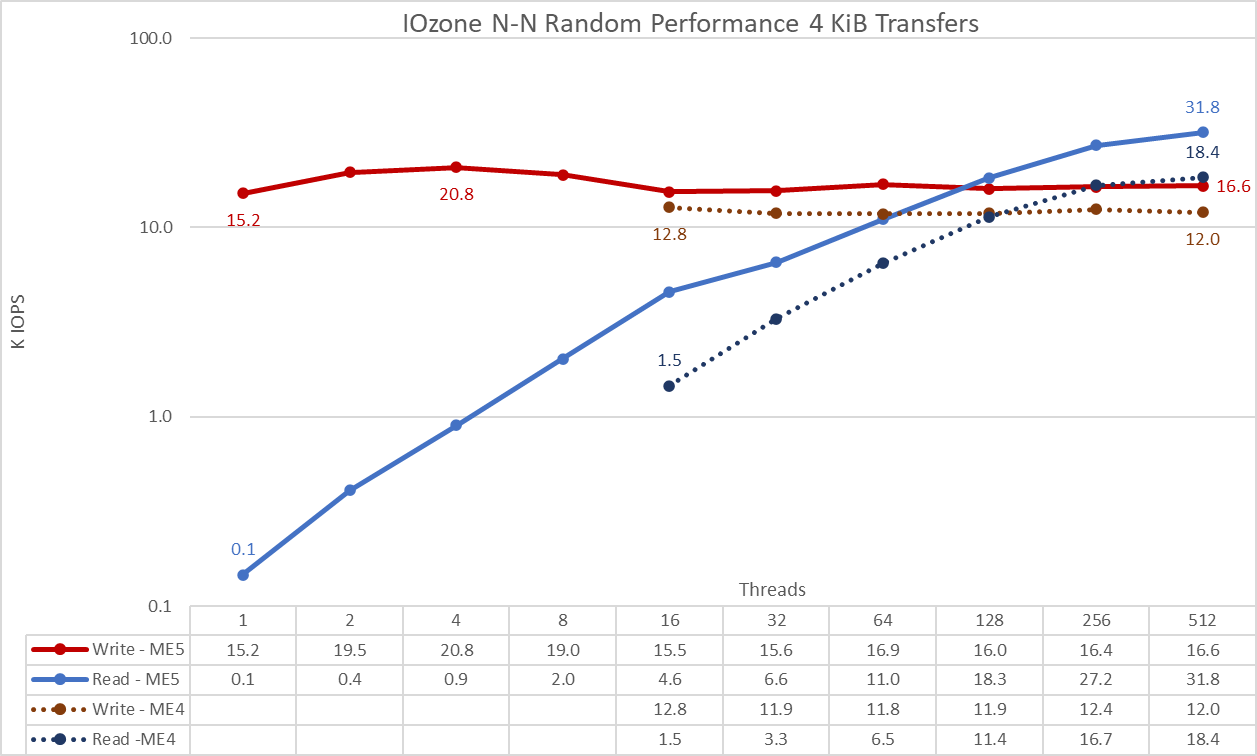

Khối nhỏ ngẫu nhiên IOzone Performance N client thành N file

Hiệu suất N máy khách ngẫu nhiên đến N tệp được đo bằng IOzone phiên bản 3.492. Các thử nghiệm mà chúng tôi đã chạy khác nhau, từ một luồng đơn cho đến 1024 luồng với lũy thừa là 2.

Các thử nghiệm mà chúng tôi đã chạy rất đa dạng, từ một luồng đơn lên tới 512 luồng vì không có đủ lõi máy khách cho 1024 luồng. Mỗi luồng sử dụng một tệp khác nhau và các luồng được chỉ định bằng phương pháp quay vòng trên các nút máy khách. Thử nghiệm điểm chuẩn này sử dụng 4 khối KiB để mô phỏng lưu lượng truy cập khối nhỏ.

Chúng tôi đã giảm thiểu hiệu ứng bộ nhớ đệm bằng cách đặt nhóm trang GPFS có thể điều chỉnh thành 4 GiB và để tránh mọi hiệu ứng bộ nhớ đệm dữ liệu có thể có từ máy khách. Tổng kích thước dữ liệu của các tệp được tạo lại là 8.192 GiB chia cho số luồng ( biến $Size trong đoạn mã sau được sử dụng để quản lý giá trị đó). Tuy nhiên, các hoạt động ngẫu nhiên thực tế được giới hạn ở 128 GiB (4 GiB x 16 máy khách x 2) để tiết kiệm thời gian chạy có thể cực kỳ dài do IOPS trên ổ NLS thấp.

. ./iozone -i0 -I -c -e -w -r 8M -s ${Size}G -t $Threads -+n -+m ./me5_threadlist <= Tạo các tệp tuần tự

./iozone -i2 -I -O -w -r 4k -s ${Size}G -t $Threads -+n -+m ./me5_threadlist <= Thực hiện việc đọc và ghi ngẫu nhiên

Hình 7 Hiệu suất ngẫu nhiên N đến N

QUAN TRỌNG: Để cho phép so sánh trực tiếp các giá trị mảng ME5 với các giá trị thu được trước đó bằng mảng ME4 trên biểu đồ, kết quả IOzone của cấu hình Trung bình (hai mảng ME5084) được nhân với 2 để ước tính hiệu suất của cấu hình Lớn (bốn mảng ME5084) .

Từ kết quả, chúng ta thấy rằng hiệu suất ghi bắt đầu ở giá trị cao là 15,2K IOPS và tăng lên mức cao nhất là 20,8K IOPS ở bốn luồng, sau đó giảm dần cho đến khi đạt đến mức ổn định ở 16 luồng (15-17K IOPS). Hiệu suất đọc bắt đầu ở mức thấp 1,5K IOPS ở 16 luồng và tăng dần theo số lượng luồng được sử dụng (số lượng luồng được nhân đôi cho mỗi điểm dữ liệu) cho đến khi đạt được hiệu suất tối đa 31,8K IOPS ở 512 luồng mà không đạt đến mức ổn định. Việc sử dụng nhiều luồng hơn đòi hỏi phải có hơn 16 nút điện toán để tránh tình trạng thiếu tài nguyên và hoán đổi quá mức có thể làm giảm hiệu suất rõ ràng. Vì ổ cứng NLS tìm kiếm giới hạn thời gian IOPS tối đa từ rất lâu trước khi đạt được thông số kỹ thuật ME5 của bộ điều khiển, nên việc sử dụng phần mở rộng ME484 có thể giúp tăng IOPS; và các ổ đĩa nhanh hơn (10K, 15K hoặc SSD) có thể giúp ích nhiều hơn nữa. Tuy nhiên, cấp NVMe phù hợp hơn để xử lý các yêu cầu IOPS cực cao.

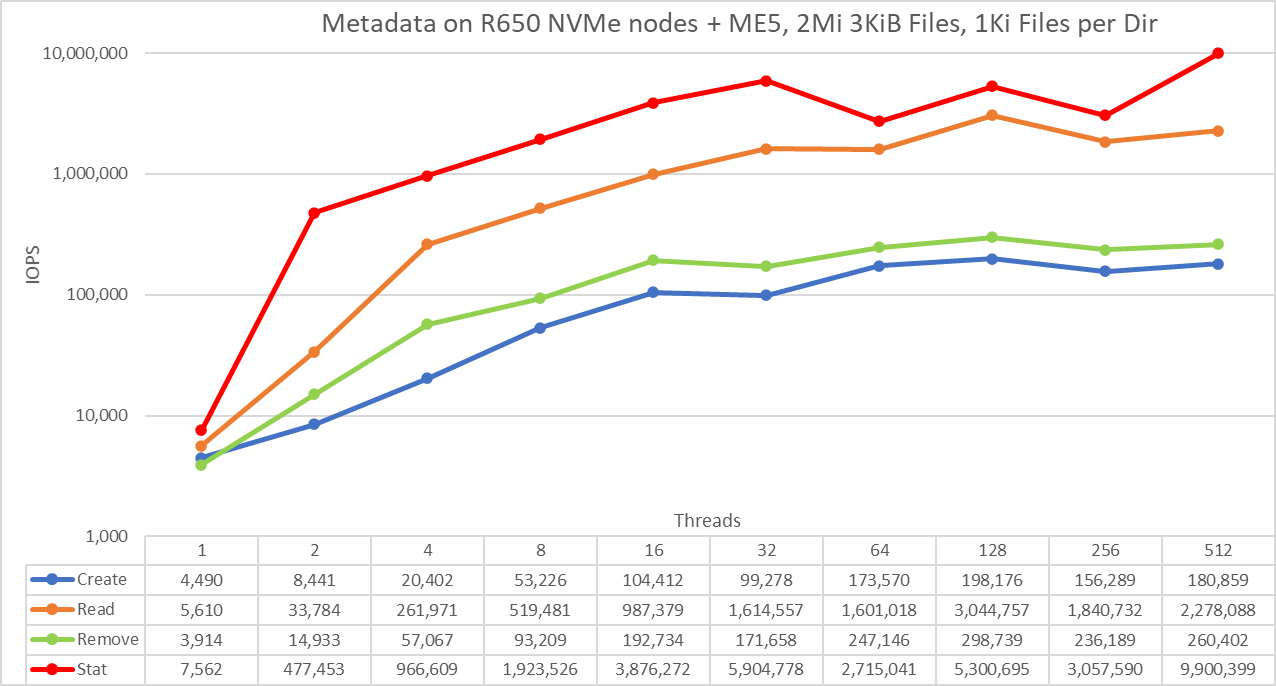

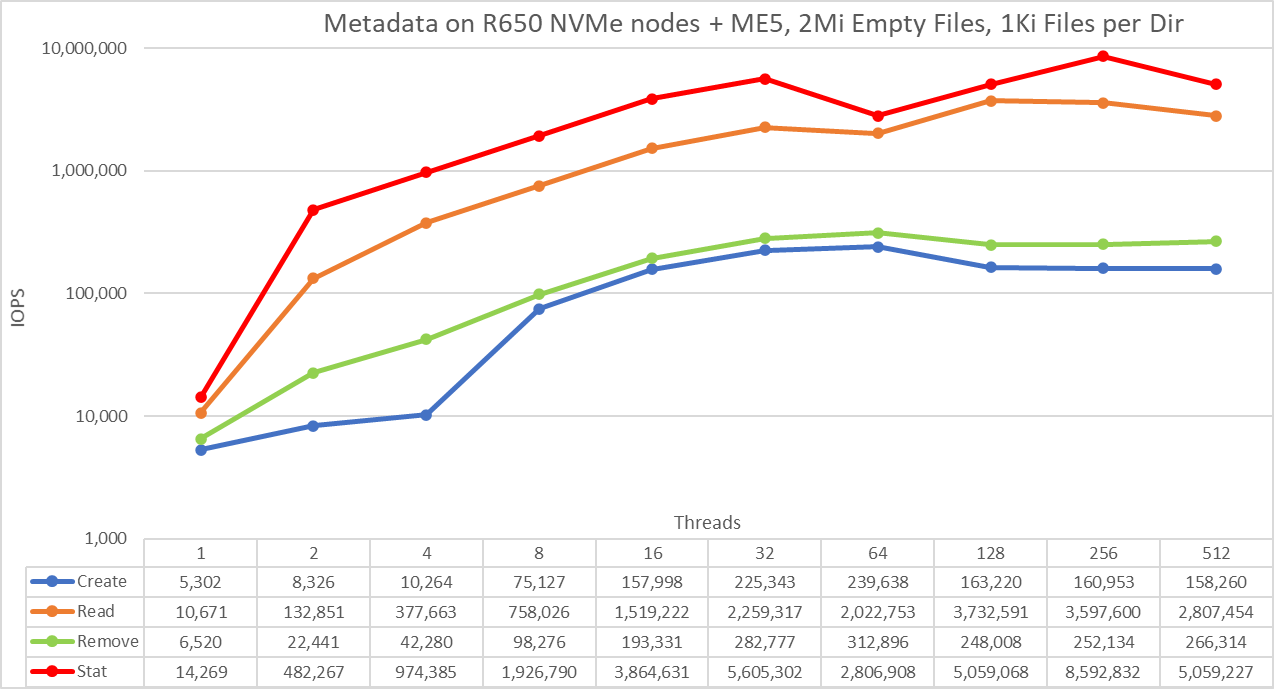

Hiệu suất siêu dữ liệu với MDtest

HDMD tùy chọn được sử dụng trong thử nghiệm này là với một cặp máy chủ PowerEdge R650 với 10 thiết bị PM1735 NVMe PCIe 4 trên mỗi máy chủ. Hiệu suất siêu dữ liệu được đo bằng MDtest phiên bản 3.3.0, với OpenMPI v4.1.2A1 để chạy điểm chuẩn trên 16 nút điện toán. Các thử nghiệm mà chúng tôi đã chạy rất đa dạng, từ một luồng đơn cho đến 512 luồng. Điểm chuẩn chỉ được sử dụng cho các tệp (không có siêu dữ liệu thư mục), lấy số lượng thao tác tạo, thống kê, đọc và xóa mà giải pháp có thể xử lý.

Vì cùng một mô-đun NVMe Siêu dữ liệu có nhu cầu cao đã được sử dụng cho các bài kiểm tra điểm chuẩn trước đây của giải pháp lưu trữ pixstor nên kết quả siêu dữ liệu tương tự với các kết quả trước đó (bậc NVMe). Do đó, nghiên cứu với 3 tệp KiB trống đã được đưa vào để hoàn thiện, nhưng kết quả với 4 tệp KiB phù hợp hơn với blog này. Vì 4 tệp KiB không thể chứa vừa một nút cùng với thông tin siêu dữ liệu nên mảng ME5 được sử dụng để lưu trữ dữ liệu cho mỗi tệp. Do đó, MDtest cũng có thể cung cấp ước tính gần đúng về hiệu suất của các tệp nhỏ cho các hoạt động đọc và phần còn lại của các hoạt động siêu dữ liệu sử dụng mảng ME5.

Lệnh sau được sử dụng để chạy điểm chuẩn, trong đó biến $Threads là số lượng luồng được sử dụng (tăng từ 1 đến 512 theo lũy thừa hai) và my_hosts.$Threads là tệp tương ứng phân bổ từng luồng trên một nút khác nhau, sử dụng phương pháp quay vòng để trải chúng một cách đồng nhất trên 16 nút điện toán. Kích thước tệp cho các thao tác đọc và tạo được lưu trữ trong $FileSize . Giống như điểm chuẩn IO ngẫu nhiên, số lượng luồng tối đa được giới hạn ở 512 vì không có đủ lõi trên các nút máy khách cho 1024 luồng. Chuyển đổi bối cảnh có thể ảnh hưởng đến kết quả, báo cáo con số thấp hơn hiệu suất thực của giải pháp.

mpirun –allow-run-as-root -np $Threads –hostfile my_hosts.$Threads –prefix /usr/mpi/gcc/openmpi-4.1.2a1 –map-by node –mca btl_openib_allow_ib 1 /mms1/ băng ghế dự bị/mdtest -v -P -d /mms1/perftest -i 1 -b $Directories -z 1 -L -I 1024 -u -t -w $FileSize -e $FileSize

Vì tổng số IOPS, số lượng tệp trên mỗi thư mục và số lượng luồng có thể ảnh hưởng đến kết quả hiệu suất nên chúng tôi quyết định giữ tổng số tệp cố định thành 2 tệp MiB (2^21 = 2097152), số lượng các tệp trên mỗi thư mục được cố định ở mức 1024 và số lượng thư mục thay đổi khi số lượng luồng thay đổi, như được hiển thị trong bảng sau:

Bảng 3 Phân phối MDtest của tệp trên thư mục

| Số của chủ đề | Số lượng thư mục trên mỗi chủ đề | Tổng số tập tin |

| 1 | 2048 | 2.097.152 |

| 2 | 1024 | 2.097.152 |

| 4 | 512 | 2.097.152 |

| số 8 | 256 | 2.097.152 |

| 16 | 128 | 2.097.152 |

| 32 | 64 | 2.097.152 |

| 64 | 32 | 2.097.152 |

| 128 | 16 | 2.097.152 |

| 256 | số 8 | 2.097.152 |

| 512 | 4 | 2.097.152 |

Hình 8 Hiệu suất siêu dữ liệu – các tệp trống

Thang đo được chọn là logarit với cơ số 10 để cho phép so sánh các phép toán có sự khác biệt ở một số bậc độ lớn; nếu không, một số thao tác sẽ xuất hiện giống như một đường thẳng gần bằng 0 trên thang tuyến tính. Biểu đồ log có cơ số 2 phù hợp hơn vì số lượng chuỗi được tăng theo lũy thừa 2. Biểu đồ như vậy trông tương tự, nhưng mọi người có xu hướng nhận thức và ghi nhớ các số dựa trên lũy thừa 10 tốt hơn.

Các tệp trống không liên quan đến tất cả các mảng ME5 và chỉ thể hiện hiệu suất trên máy chủ PowerEdge R650 có ổ NVMe. Hệ thống cho kết quả tốt với các thao tác chỉ số đạt giá trị cao nhất ở 256 luồng với gần 8,6M op/s và sau đó giảm xuống ở 512 luồng. Các thao tác tạo đạt tối đa 239,6K op/s ở 64 luồng và sau đó giảm nhẹ cho đến khi đạt mức ổn định ở 128 luồng. Hoạt động đọc đạt tối đa 3,7M op/s ở 128 luồng, sau đó giảm dần. Loại bỏ đỉnh hoạt động ở mức 312,9K op/s ở 64 luồng, sau đó giảm nhẹ và dường như đạt đến trạng thái ổn định.

Hiệu suất siêu dữ liệu với 3 tệp KiB

Hình 9 Hiệu suất siêu dữ liệu – 3 tệp KiB

Thang đo được chọn là logarit với cơ số 10 để cho phép so sánh các phép toán có sự khác biệt ở một số bậc độ lớn; nếu không, một số thao tác sẽ xuất hiện giống như một đường thẳng gần bằng 0 trên thang tuyến tính. Biểu đồ log có cơ số 2 phù hợp hơn vì số lượng chuỗi được tăng theo lũy thừa 2. Biểu đồ như vậy trông tương tự, nhưng mọi người có xu hướng nhận thức và ghi nhớ các số dựa trên lũy thừa 10 tốt hơn.

Lưu ý rằng 3 file KiB vẫn nằm gọn hoàn toàn trên các inode và do đó không liên quan đến mảng ME5 mà chỉ thể hiện hiệu năng trên các máy chủ PowerEdge R650 có ổ NVMe. Hệ thống cung cấp kết quả tốt với các hoạt động chỉ số đạt giá trị cao nhất ở 512 luồng với 9,9M op/s. Các hoạt động tạo đạt tối đa 192,2K op/s ở 128 luồng và dường như đạt đến mức ổn định. Hoạt động đọc đạt tối đa 3M op/s ở 128 luồng. Hoạt động loại bỏ đạt đỉnh điểm là 298,7K op/s ở 128 luồng.

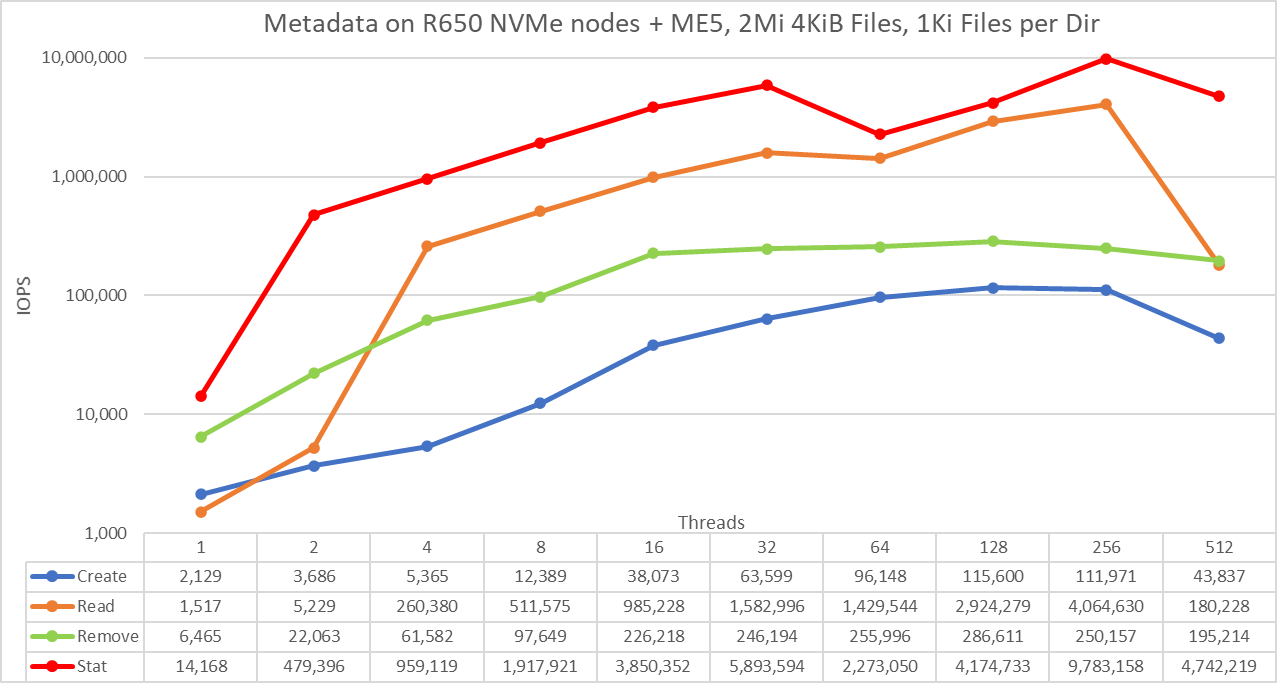

Hiệu suất siêu dữ liệu với 4 tệp KiB

Thang đo được chọn là logarit với cơ số 10 để cho phép so sánh các phép toán có sự khác biệt ở một số bậc độ lớn; nếu không, một số thao tác sẽ xuất hiện giống như một đường thẳng gần bằng 0 trên thang tuyến tính. Biểu đồ log có cơ số 2 phù hợp hơn vì số lượng chuỗi được tăng theo lũy thừa 2. Biểu đồ như vậy trông tương tự, nhưng mọi người có xu hướng nhận thức và ghi nhớ các số dựa trên lũy thừa 10 tốt hơn.

Hệ thống cho kết quả tốt với các thao tác chỉ số đạt giá trị cao nhất ở 256 luồng với gần 9,8M op/s và sau đó giảm xuống ở 512 luồng. Các thao tác tạo đạt tối đa 115,6K op/s ở 128 luồng và sau đó giảm nhẹ cho đến khi đạt 512 luồng trong đó giá trị giảm xuống dưới 40% so với mức đỉnh. Hoạt động đọc đạt tối đa 4M IOPS ở 256 luồng, có vẻ quá cao đối với ổ NLS (có thể ngụ ý rằng hệ thống tệp đang lưu trữ tất cả dữ liệu cần thiết cho hầu hết các điểm dữ liệu), đột ngột giảm xuống còn 512 luồng. Cần phải làm nhiều việc hơn để hiểu được sự sụt giảm đột ngột của các hoạt động tạo và hiệu suất đọc cao. Cuối cùng, loại bỏ mức hoạt động cao nhất ở 286,6K op/s ở 128 luồng và giảm ở số lượng luồng cao hơn.

Kết luận và công việc tương lai

Mảng ME5 mới mang lại hiệu suất tăng đáng kể (71% cho hoạt động đọc và 82% cho hoạt động ghi theo thông số kỹ thuật). Các mảng mới trực tiếp tăng hiệu suất cho giải pháp pixstor, nhưng không đến mức mong đợi từ thông số kỹ thuật, như được thấy trong Bảng 4. Vì giải pháp pixstor sử dụng quyền truy cập phân tán theo mặc định nên dự kiến các bản mở rộng ME484 sẽ giúp tiến gần hơn đến mục tiêu giới hạn của bộ điều khiển ME5.

Giải pháp này cung cấp cho khách hàng HPC một hệ thống tệp song song đáng tin cậy (Thang phổ phổ – còn được gọi là GPFS) được nhiều cụm HPC Top500 sử dụng. Ngoài ra, nó còn cung cấp khả năng tìm kiếm đặc biệt mà không làm giảm hiệu suất cũng như giám sát và quản lý nâng cao. Bằng cách sử dụng các giao thức tiêu chuẩn như NFS, SMB và các giao thức khác, các cổng tùy chọn cho phép chia sẻ tệp với nhiều máy khách nếu cần. Các nút ngenea tùy chọn cho phép phân tầng các bộ lưu trữ Dell khác như Dell PowerScale, Dell ECS, các nhà cung cấp khác và thậm chí cả bộ lưu trữ đám mây.

Bảng 4 Hiệu suất cao nhất và bền vững với mảng ME5084

| Điểm chuẩn | Hiệu suất cao điểm | Hiệu suất bền vững | ||

| Viết | Đọc | Viết | Đọc | |

| N máy khách tuần tự lớn tới N tệp | 31,4 GB/giây | 27,8 GB/giây | 28 GB/giây | 26 GB/giây |

| Máy khách N tuần tự lớn cho một tệp được chia sẻ | 30,9 GB/giây | 27,8 GB/giây | 27,3 GB/giây | 27 GB/giây |

| Ngẫu nhiên Khối nhỏ N client vào N file | 31,8K IOPS | 20,8K IOPS | 15,5K IOPS | 27K IOPS |

| Siêu dữ liệu Tạo 4 tệp KiB | 115,6K IOPS | 50K IOPS | ||

| Tệp siêu dữ liệu Stat 4 KiB | 9,8 triệu IOPS | IOPS 1,4 triệu | ||

| Siêu dữ liệu Xóa 4 tệp KiB | 286,7K IOPS | 195K IOPS | ||

Khi hai ME5084 bổ sung được thêm vào giải pháp pixstor, nó sẽ được đo điểm chuẩn đầy đủ dưới dạng Cấu hình lớn (bốn mảng ME5084). Nó cũng sẽ được điểm chuẩn đầy đủ sau khi thêm mảng mở rộng (bốn mảng ME484). Một tài liệu khác sẽ được phát hành cùng với thông tin này và bất kỳ thông tin bổ sung nào.

Bài viết mới cập nhật

Công bố các bản nâng cấp không gây gián đoạn dựa trên Drain (NDU)

Trong quy trình làm việc NDU, các nút được khởi động ...

Tăng tốc khối lượng công việc của Hệ thống tệp mạng (NFS) của bạn với RDMA

Giao thức NFS hiện nay được sử dụng rộng rãi trong ...

Mẹo nhanh về dữ liệu phi cấu trúc – OneFS Protection Overhead

Gần đây đã có một số câu hỏi từ lĩnh vực ...

Giới thiệu Dell PowerScale OneFS dành cho Quản trị viên NetApp

Để các doanh nghiệp khai thác được lợi thế của công ...