Tin tức

Tôi có thể thực hiện chức năng AI trên Dell PowerFlex không?

Câu trả lời đơn giản là Có, bạn có thể thực hiện điều AI đó với Dell PowerFlex. Đối với những ai có thể đang bận rộn với những thứ khác, AI là viết tắt của Artificial Intelligence (Trí tuệ nhân tạo) và dựa trên các mô hình được đào tạo cho phép máy tính “suy nghĩ” theo cách mà máy móc không thể làm được trong quá khứ. Các mô hình được đào tạo này (mạng nơ-ron) về cơ bản là một tập hợp dài các câu lệnh IF (lớp) được xếp chồng lên nhau và mỗi IF có một “trọng số”. Sau khi một thứ gì đó hoạt động thông qua mạng nơ-ron, các trọng số sẽ cung cấp xác suất về đối tượng đó. Vì vậy, hệ thống AI có thể chắc chắn 95% rằng nó đang xem một bát súp hoặc một sự kiện thể thao lớn. Ít nhất thì đó là mô tả quá đơn giản của tôi về cách thức hoạt động của AI. Thuật ngữ này mang nhiều ý nghĩa vì nó đã tồn tại hơn 70 năm và định nghĩa đã thay đổi theo thời gian. (Xem Lịch sử của Trí tuệ nhân tạo .)

Gần đây nhất, AI đã trở nên nổi tiếng nhờ các mô hình ngôn ngữ lớn (LLM) cho các ứng dụng AI đàm thoại như ChatGPT. Mặc dù các ứng dụng này đã làm dấy lên nỗi sợ rằng AI sẽ chiếm lấy thế giới và hủy diệt nhân loại, nhưng điều đó vẫn chưa xảy ra. Máy tính vẫn chỉ có thể làm những gì con người bảo chúng làm, ngay cả LLM, và điều đó có nghĩa là nếu có điều gì đó không ổn, chúng ta, những người tạo ra chúng, cuối cùng sẽ phải chịu trách nhiệm. (Xem ‘Bố già của AI’ rời Google, cảnh báo về những nguy hiểm của công nghệ .)

Thực tế là hầu hết các tổ chức không xây dựng LLM phá hủy thế giới, họ đang xây dựng các hệ thống để đảm bảo rằng mỗi chiếc pizza được làm trong nhà máy của họ có đúng 12 lát pepperoni được phân bổ đều trên đầu pizza. Hoặc có thể họ đang tìm cách phòng ngừa mất mát, hoặc thời gian đèn giao thông tốt hơn, hoặc họ chỉ muốn có một menu điện thoại hỗ trợ kỹ thuật tốt hơn. Tất cả những điều này đều là ứng dụng của AI và mỗi ứng dụng được xây dựng khác nhau (họ sử dụng các loại mạng nơ-ron khác nhau).

Chúng tôi sẽ không đi sâu vào các trường hợp sử dụng này trong blog này vì chúng tôi cần bắt đầu với cơ sở hạ tầng cơ bản giúp biến tất cả những ý tưởng đó thành “khả năng AI”. Chúng tôi sẽ bắt đầu với cơ sở hạ tầng và những gì mà nhiều người hiện coi là trình phân loại hình ảnh cơ bản (theo tiêu chuẩn ngày nay) được gọi là ResNet-50 v1.5. (Xem ResNet-50: Những điều cơ bản và Hướng dẫn nhanh .)

Đó cũng là những gì nhóm Kỹ thuật Giải pháp PowerFlex đã làm trong thiết kế đã được xác thực mà họ mới công bố gần đây. Thiết kế này nêu chi tiết việc sử dụng ResNet-50 v1.5 trong môi trường VMware vSphere sử dụng NVIDIA AI Enterprise như một phần của môi trường PowerFlex. Họ bắt đầu với những điều cơ bản về cách GPU NVIDIA ảo hóa hoạt động tốt trong môi trường PowerFlex. Đó là những gì chúng ta sẽ khám phá trong blog này – bắt đầu với khối lượng công việc AI, chứ không phải cách bạn xây dựng siêu máy tính AI tiếp theo (mặc dù bạn cũng có thể làm điều đó với PowerFlex).

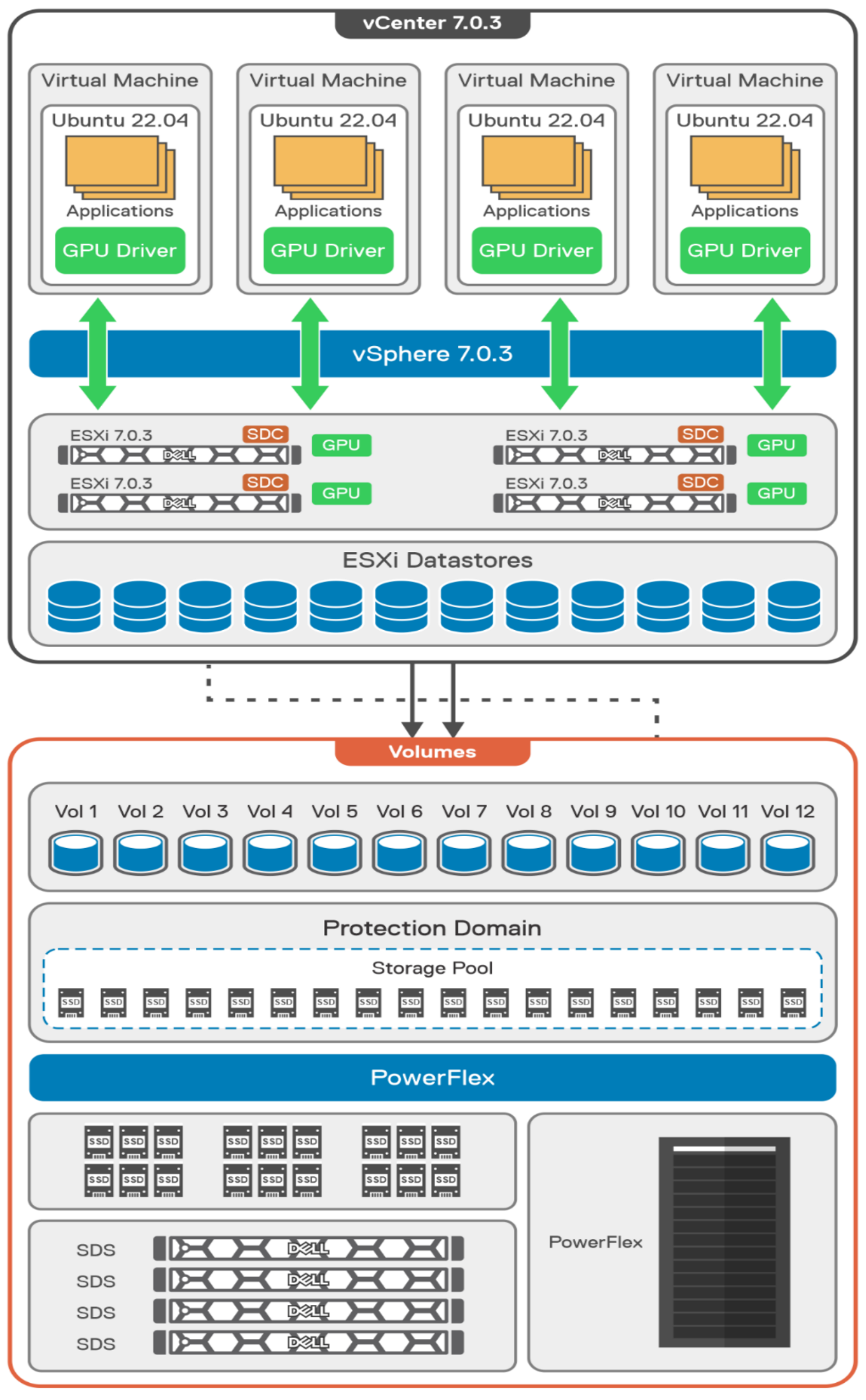

Trong thiết kế đã được xác thực này, họ sử dụng GPU NVIDIA A100 (PCIe) và ảo hóa nó trong VMware vSphere như một GPU ảo hoặc vGPU. Với cơ sở hạ tầng đã có, họ đã xây dựng các máy ảo Linux sẽ chứa khối lượng công việc ResNet-50 v1.5 và vGPU. Ngoài việc chỉ làm việc với các vGPU truyền thống mà nhiều người có thể quen thuộc, họ còn làm việc với công nghệ GPU đa phiên bản (MIG) của NVIDIA .

Công nghệ MIG của NVIDIA cho phép quản trị viên phân vùng GPU thành tối đa bảy phiên bản GPU. Có thể thực hiện điều này giúp kiểm soát tốt hơn các tài nguyên GPU, đảm bảo rằng khối lượng công việc lớn và nhỏ có được lượng tài nguyên GPU phù hợp mà chúng cần mà không lãng phí bất kỳ tài nguyên nào.

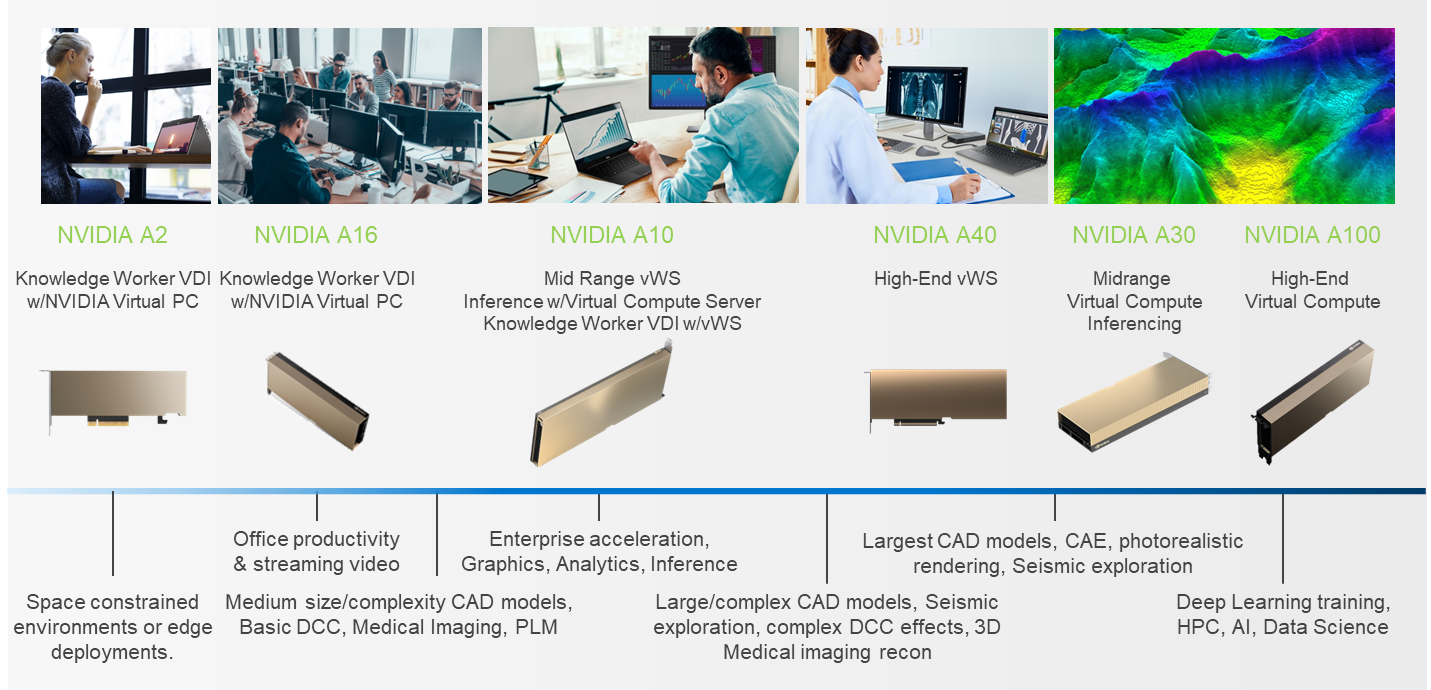

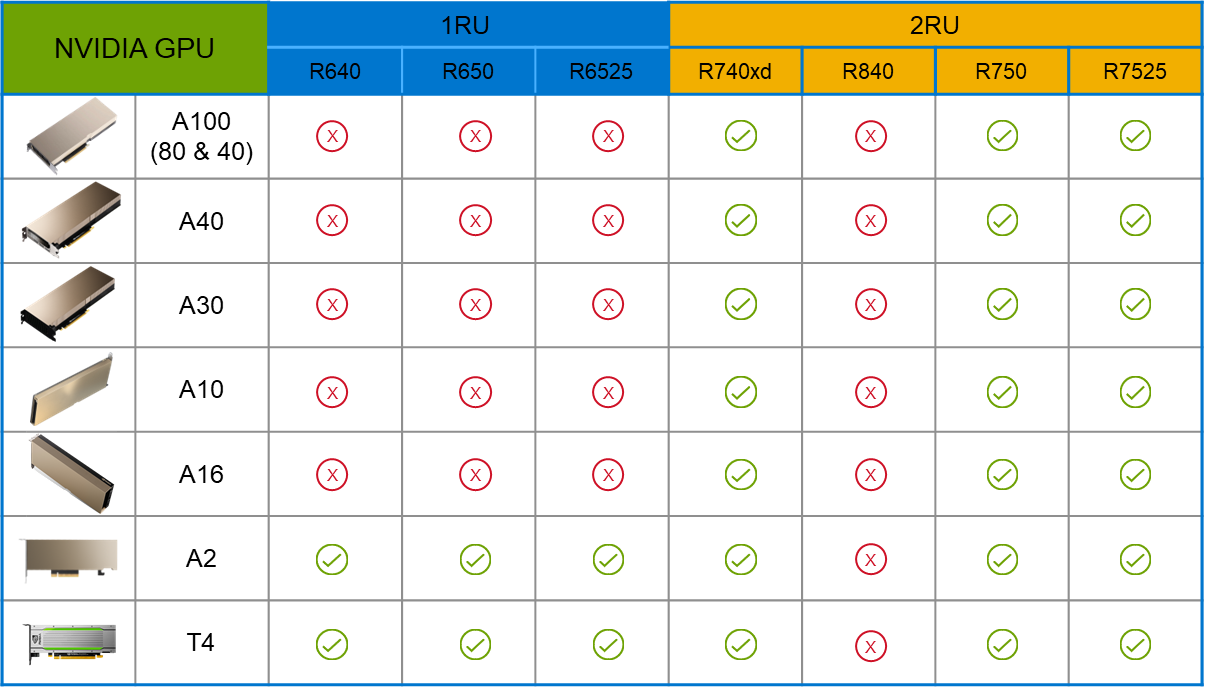

PowerFlex hỗ trợ nhiều loại GPU NVIDIA cho khối lượng công việc, từ VDI (Máy tính để bàn ảo) đến khối lượng công việc tính toán ảo cao cấp như AI. Bạn có thể thấy điều này trong sơ đồ sau, trong đó có các giải pháp cho môi trường “bị hạn chế về không gian” và “biên”, cho đến các GPU được sử dụng cho các mô hình suy luận lớn. Trong bảng bên dưới sơ đồ, bạn có thể thấy GPU nào được hỗ trợ trong từng loại nút PowerFlex. Điều này cung cấp một lượng linh hoạt to lớn tùy thuộc vào khối lượng công việc của bạn.

Thiết kế đã được xác thực mô tả các bước để cấu hình kiến trúc và cung cấp các liên kết chi tiết đến tài liệu NVIDIA và VMware để cấu hình vGPU cũng như quy trình cấp phép cho NVIDIA AI Enterprise.

Đây là những bước chính khi xây dựng môi trường AI. Tôi biết từ kinh nghiệm làm việc với nhiều tổ chức khác nhau và từ việc giảng dạy rằng nhiều người không quen làm việc với vGPU trong Linux. Điều này đang dần thay đổi trong ngành. Nếu bạn chưa dành nhiều thời gian làm việc với vGPU trong Linux, hãy chắc chắn chú ý đến các chi tiết được cung cấp trong hướng dẫn . Điều này rất quan trọng và có thể tạo ra sự khác biệt lớn trong hiệu suất của bạn.

Sơ đồ sau đây cho thấy kiến trúc logic của thiết kế đã được xác thực. Ở đầu sơ đồ, bạn có thể thấy bốn máy ảo Linux Ubuntu 22.04 có trình điều khiển NVIDIA vGPU được tải trong đó. Chúng đang chạy trên máy chủ PowerFlex với VMware ESXi được triển khai. Mỗi máy ảo chứa một GPU NVIDIA A100 được cấu hình cho các hoạt động MIG. Cấu hình này tận dụng kiến trúc hai tầng, trong đó lưu trữ được cung cấp bởi các nút lưu trữ được xác định bằng phần mềm (SDS) PowerFlex riêng biệt.

Thiết kế như thế này cho phép khả năng mở rộng độc lập cho khối lượng công việc của bạn. Ý tôi là trong giai đoạn đào tạo của một mô hình, có thể cần lưu trữ đáng kể cho dữ liệu đào tạo, nhưng khi mô hình xóa xác thực và đưa vào sản xuất, yêu cầu lưu trữ có thể khác biệt đáng kể. Với PowerFlex, bạn có sự linh hoạt để cung cấp dung lượng lưu trữ và hiệu suất bạn cần ở mỗi giai đoạn.

Điều này đưa chúng ta đến với việc thử nghiệm môi trường. Một lần nữa, đối với bài báo này, nhóm kỹ sư đã xác thực nó bằng ResNet-50 v1.5 sử dụng bộ dữ liệu ImageNet 1K. Đối với quá trình xác thực này, họ đã kích hoạt một số tính năng TensorFlow ResNet-50 v1.5. Chúng bao gồm đào tạo Multi-GPU với Horovod , NVIDIA DALI và Automatic Mixed Precision (AMP) . Những tính năng này giúp kích hoạt nhiều khả năng khác nhau trong mô hình ResNet-50 v1.5 có trong môi trường. Sau đó, bài báo mô tả cách thiết lập và cấu hình ResNet-50 v1.5, các tính năng được đề cập ở trên và thông tin chi tiết về việc tải xuống dữ liệu ImageNet.

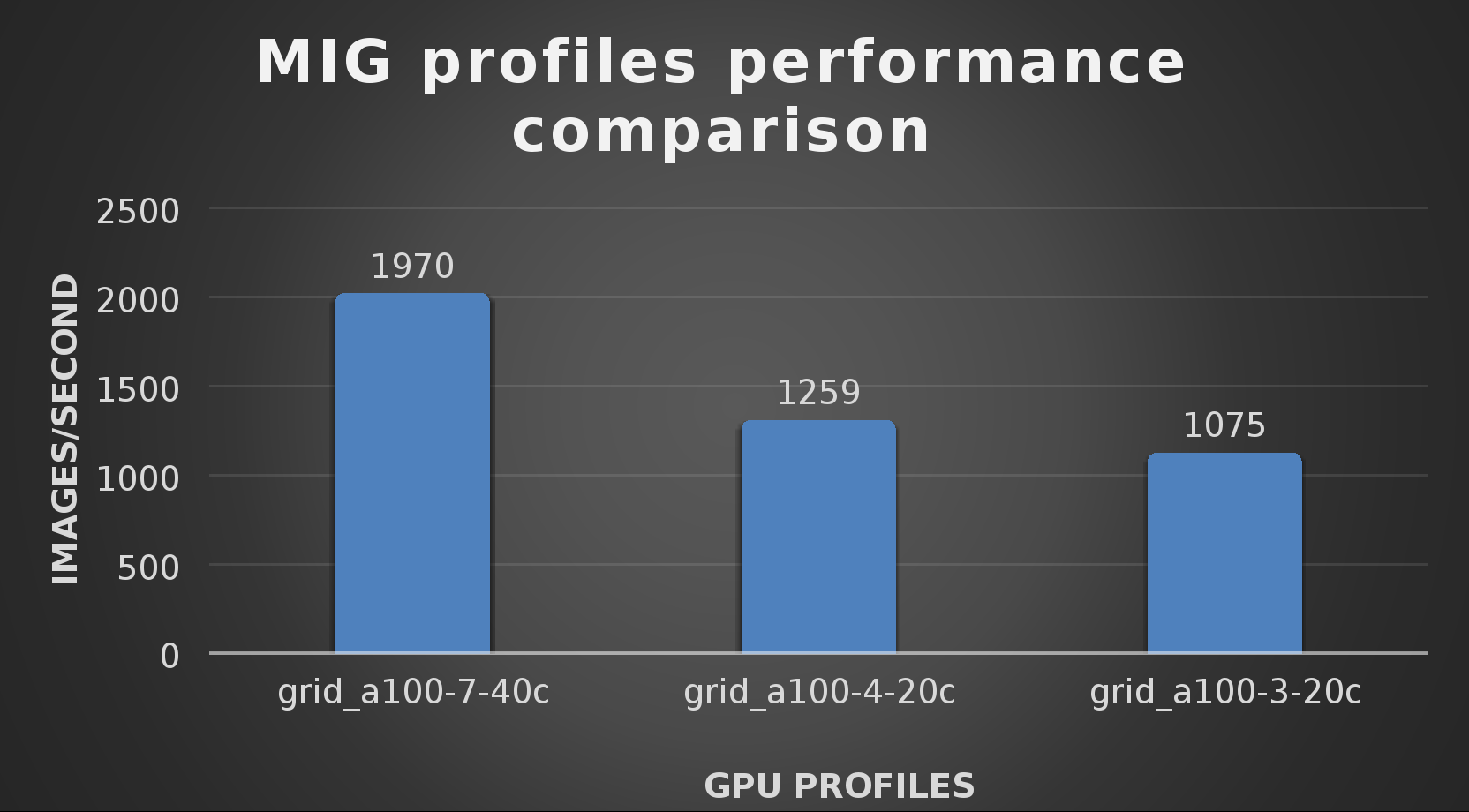

Ở giai đoạn này, họ đã có thể đào tạo triển khai ResNet-50 v1.5. Lần đào tạo đầu tiên sử dụng cấu hình NVIDIA A100-7-40C vGPU . Sau đó, họ lặp lại thử nghiệm với cấu hình A100-4-20C vGPU và cấu hình A100-3-20C vGPU. Bạn có thể thắc mắc về cấu hình A100-2-10C vGPU và cấu hình A100-1-5C. Mặc dù các cấu hình vGPU đó có sẵn, nhưng chúng phù hợp hơn với suy luận, vì vậy chúng không được thử nghiệm.

Kết quả từ việc xác thực khối lượng công việc đào tạo cho từng cấu hình vGPU được hiển thị trong biểu đồ sau. Các vGPU chạy gần 98% công suất theo nvitop trong mỗi lần kiểm tra. Mức sử dụng CPU là 14% và không có nút thắt cổ chai với bộ lưu trữ trong các lần kiểm tra.

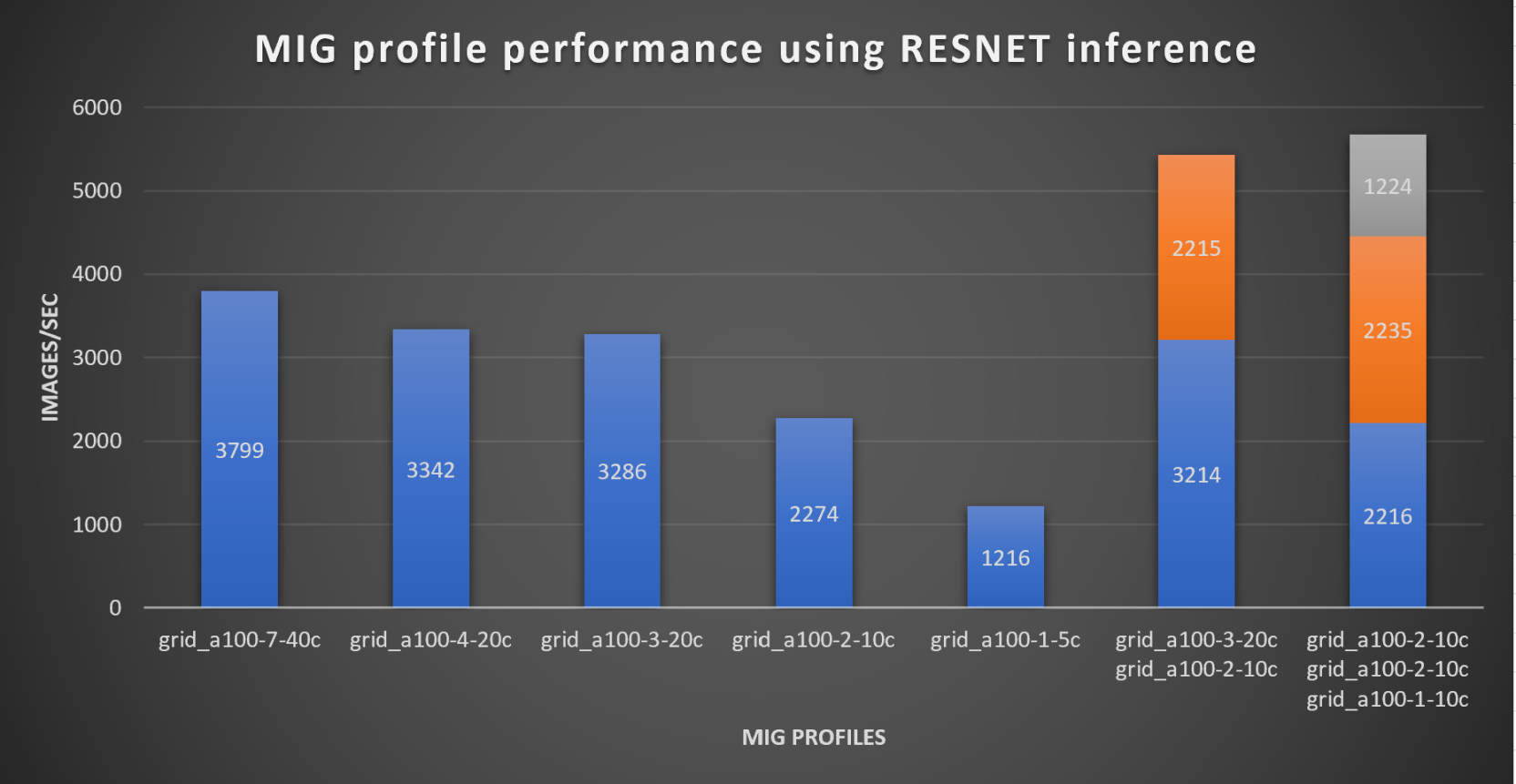

Với các mô hình được đào tạo, hướng dẫn sau đó sẽ xem xét cách suy luận chạy tốt như thế nào trên các cấu hình MIG. Biểu đồ sau đây hiển thị hình ảnh suy luận mỗi giây của các cấu hình MIG khác nhau với ResNet-50 v1.5.

Cần lưu ý rằng hai cột cuối cùng cho thấy quá trình suy luận chạy trên nhiều VM, trên cùng một máy chủ ESXi, đang tận dụng các cấu hình MIG. Điều này cũng cho thấy tài nguyên GPU được phân vùng bằng MIG và tài nguyên có thể được kiểm soát chính xác, cho phép nhiều loại tác vụ chạy trên cùng một GPU mà không ảnh hưởng đến các tác vụ đang chạy khác.

Điều này mở ra cơ hội cho các tổ chức sắp xếp việc sử dụng tài nguyên vGPU trong môi trường ảo. Nói cách khác, nó cho phép CNTT cung cấp “hiển thị lại” việc sử dụng cơ sở hạ tầng trong tổ chức. Vì vậy, nếu một bộ phận chỉ cần một hồ sơ vGPU suy luận, thì đó là những gì họ nhận được, không nhiều hơn, không ít hơn.

Điều đáng chú ý là kết quả từ việc sử dụng vGPU là 88% và sử dụng CPU là 11% trong quá trình thử nghiệm suy luận.

Những xác thực này cho thấy môi trường Dell PowerFlex có thể hỗ trợ các thành phần cơ bản của AI hiện đại. Nó cũng cho thấy giá trị của công nghệ MIG của NVIDIA đối với các tổ chức ở mọi quy mô: cho phép họ đạt được hiệu quả hoạt động trong trung tâm dữ liệu và cho phép truy cập vào AI.

Điều này một lần nữa trả lời câu hỏi của blog này, tôi có thể thực hiện điều AI đó trên Dell PowerFlex không… Có, bạn có thể chạy điều AI đó! Nếu bạn muốn tìm hiểu thêm về cách chạy điều AI của mình trên PowerFlex, hãy đảm bảo liên hệ với đại diện Dell của bạn.

Bài viết mới cập nhật

Tăng tốc khối lượng công việc của Hệ thống tệp mạng (NFS) của bạn với RDMA

Giao thức NFS hiện nay được sử dụng rộng rãi trong ...

Mẹo nhanh về dữ liệu phi cấu trúc – OneFS Protection Overhead

Gần đây đã có một số câu hỏi từ lĩnh vực ...

Giới thiệu Dell PowerScale OneFS dành cho Quản trị viên NetApp

Để các doanh nghiệp khai thác được lợi thế của công ...

Cơ sở hạ tầng CNTT: Mua hay đăng ký?

Nghiên cứu theo số liệu của IDC về giải pháp đăng ...