Tin tức

Trao quyền cho doanh nghiệp bằng AI sáng tạo: MLPerf™ hỗ trợ các yêu cầu như thế nào?

AI sáng tạo đã phát triển thành một khối lượng công việc quan trọng trong hệ sinh thái học sâu. Trong thế giới AI thế hệ, năm 2023 là một năm tăng trưởng bùng nổ khi AI thế hệ tiếp tục đạt được những tiến bộ to lớn bằng cách cải thiện chất lượng và khả năng tiếp cận dễ dàng vào các hệ sinh thái này. Với sự ra đời của ChatGPT, Stable Diffusion, v.v., đã trở nên phổ biến đáng kể, chúng ta có thể coi AI tổng quát là một trong những trường hợp sử dụng quan trọng đưa AI ra thế giới. Chúng tôi hy vọng sẽ thấy AI có tính sáng tạo sẽ thúc đẩy các giới hạn mới và tạo ra sự bùng nổ về năng suất. Blog này cung cấp thông tin tổng quan về AI tổng quát và mức độ liên quan của nó với tiêu chuẩn hệ thống MLCommons TM AI mà chúng tôi thường xuyên gửi đến.

Giới thiệu về AI sáng tạo

AI sáng tạo là một hiện tượng trong đó các hệ thống AI (bao gồm phần cứng và phần mềm) có thể tạo ra các kết xuất hình ảnh, âm thanh, video, văn bản, mã, kết xuất 3D, v.v. khi được đưa ra lời nhắc hướng dẫn. Lời nhắc có thể là văn bản, giọng nói hoặc các hình thức khác. Một số ví dụ phổ biến bao gồm ChatGPT, trình tạo hình ảnh Khuếch tán ổn định và công cụ chuyển văn bản thành giọng nói.

Các hệ thống AI này có thể cho phép tăng năng suất đáng kể bằng cách tạo và sửa đổi các phần nội dung hiện có để cải thiện hiệu quả quy trình làm việc của người dùng.

Những hệ thống AI này có thể làm gì?

AI sáng tạo có khả năng tạo và tối ưu hóa:

- Trò chuyện và nhắn tin ─Phương thức này hữu ích cho việc hỗ trợ khách hàng, tạo blog, bản sao quảng cáo, hướng dẫn thiết kế và báo cáo kỹ thuật, đọc và thực hiện hành động, trả lời câu hỏi, tóm tắt tài liệu lớn, tạo mã có thể chạy trực tiếp, truyền cảm hứng cho các nhà phát triển viết cải tiến mã, v.v.

- Thế hệ video:

- Video nói chuyện bằng đầu ─Những video này có thể hữu ích cho nhà sản xuất nội dung, hướng dẫn viên, v.v. trong đó các nhân vật có thể giao tiếp bằng giọng nói, hát nhép và cảm xúc, những video này rất hữu ích cho việc hỗ trợ khách hàng và các dịch vụ tương tác khác.

- NERF ( trường bức xạ thần kinh) – Với một vài góc độ từ hình ảnh, nó có thể tạo ra toàn bộ cảnh quay mượt mà trông như thật. NERF có thể hữu ích trong việc cung cấp nhiều góc nhìn hơn cho một cảnh và tạo ra nhiều góc nhìn thú vị hơn.

- Hình ảnh có độ phân giải cao ─Những hình ảnh sáng tạo này có thể được sử dụng cho nhiều mục đích bao gồm B-roll, giải thích ý tưởng và khái niệm mô phỏng, hiệu ứng đặc biệt, vectơ đồ họa, đồ họa thông tin, phông nền, cảnh, v.v.

- Âm thanh có độ trung thực cao ─Các mẫu âm thanh này có thể là giọng nói, âm nhạc, v.v. Giọng nói có thể truyền tải cảm xúc, có chất lượng cao như thuyết minh và truyền tải lời nói cho quảng cáo. Mẫu âm thanh cũng có thể là bài hát karaoke, bài hát có beat, hỗ trợ khách hàng, v.v.

- Thế hệ 3D ─Những kết xuất này rất hữu ích để tạo ra một thế giới mới chỉ bằng trí tưởng tượng. Chúng có tác dụng mạnh mẽ đối với VFX, VR và các trải nghiệm sống động khác. Những thế hệ 3D này có thể được sử dụng để tạo các bản sao kỹ thuật số của thế giới thực, trò chơi, quảng cáo, phim, v.v.

Blog này không nêu bật nhiều trường hợp sử dụng khác. Với nhiều đổi mới và nghiên cứu hơn, sẽ có sự bùng nổ kỷ Cambri với nhiều trường hợp sử dụng hơn được thúc đẩy bởi AI tổng hợp. Những mô hình này cũng có thể tạo ra nội dung được cá nhân hóa cho người dùng cuối thay vì cung cấp nội dung chung chung.

Cần loại tính toán nào để đào tạo các hệ thống AI này?

Đào tạo các hệ thống AI tổng quát là một nhiệm vụ đòi hỏi nhiều tính toán. Thông thường, việc tạo văn bản, chatbot và người theo dõi hướng dẫn có hàng tỷ tham số và sử dụng hàng nghìn giờ GPU. Nhiệm vụ này đặt ra một vấn đề lớn cần các cơ chế song song hóa khác nhau, tối ưu hóa cập nhật đào tạo, bao gồm tối ưu hóa toàn bộ ngăn xếp (phần cứng và phần mềm), v.v.

Chẳng hạn, mô hình GPT3 có 175 tham số B và mô hình Megatron có khoảng 530 tham số B. Quy trình đào tạo và suy luận cho các hệ thống này khác biệt đáng kể so với các mô hình học sâu truyền thống không có nhiều tham số. Ví dụ: các mô hình ngôn ngữ lớn (LLM) yêu cầu thiết lập suy luận lớn bao gồm suy luận đa nút, đào tạo mở rộng quy mô thành một nghìn tỷ mô hình tham số cần các cơ chế khác nhau bao gồm độ thưa động, tối ưu hóa chi phí truyền thông, tự điều chỉnh, v.v.

Về bản chất, nhu cầu tính toán cho AI tổng quát ngày càng tăng theo những cách độc đáo. Mặc dù việc đào tạo các mô hình AI tổng quát vẫn rất quan trọng đối với nhu cầu tính toán, nhưng nhu cầu tính toán tiếp theo có thể xuất phát từ nhu cầu tinh chỉnh và suy luận.

Tại sao phải thích nghi bây giờ?

AI sáng tạo đã được phát triển trong nhiều năm nay; Máy biến áp, Wavenet, GAN, Bộ mã hóa tự động với bộ giải mã, v.v. đã xuất hiện từ khá lâu. Đã có nhiều đổi mới trong các lĩnh vực này và tiếp tục được kết hợp và kết hợp để đạt được kết quả hiệu quả. Ví dụ: sự phát triển của các mô hình đa phương thức (các mô hình sử dụng các loại đầu vào khác nhau) tạo điều kiện thuận lợi cho quy trình làm việc mang tính hợp tác hơn. Các mô hình đa phương thức tạo thành nền tảng cho việc kích hoạt trí thông minh gần giống con người cho một nhiệm vụ cụ thể. Mặc dù có rất ít cơ hội đạt được hiệu suất ở cấp độ con người nói chung, nhưng những mô hình đa phương thức này có thể tạo ra những kết quả đáng tin cậy. Người tiêu dùng của các hệ thống này có thể lấy kết quả đầu ra, sửa đổi và sử dụng chúng trong quy trình làm việc của mình. Các hệ thống này hiển thị đầu ra nhanh chóng so với nỗ lực thủ công và cung cấp nhiều lớp sáng tạo hơn.

Những kết xuất hợp lý, khả năng truy cập dễ dàng và phát triển nguồn mở này là nguồn nhiên liệu đáng kinh ngạc để phổ biến các hệ thống AI tổng hợp. Bước tiếp theo là thúc đẩy các hệ thống này hoạt động tốt hơn, bằng cách cải thiện chất lượng dịch vụ hoặc cải thiện thông lượng. Cải thiện chất lượng dịch vụ và thông lượng là một vấn đề đã được thiết lập. Để cải thiện khả năng hội tụ và thông lượng, nhiều điểm chuẩn đã cố gắng tối ưu hóa hệ thống AI.

Mối quan hệ với MLCommons

Điểm chuẩn Đào tạo MLCommons là công cụ giúp cải thiện đáng kể khả năng hội tụ thời gian đào tạo của hệ thống bằng cách có cái nhìn toàn diện về phần cứng và phần mềm. Điểm chuẩn suy luận MLCommons đã giúp tối ưu hóa khả năng suy luận của hệ thống AI.

Hơn nữa, MLCommons có các điểm chuẩn AI tổng quát trong lộ trình của họ. Ví dụ: LLM là một phần của chương trình đào tạo MLCommons v3.0; Khuếch tán ổn định dự kiến sẽ được đưa vào như một phần của chương trình đào tạo MLCommons v3.1.

Nhu cầu liên tục cải tiến hệ thống là điều cần thiết, đặc biệt là đối với các trường hợp sử dụng AI tổng quát. Chúng ta có thể thấy rằng cộng đồng MLCommons đã có những cải thiện đáng kể về hiệu suất hàng năm. Những tối ưu hóa này từ các nhà cung cấp, điểm chuẩn và cộng đồng deep learning tiếp tục phục vụ nỗ lực sáng tạo AI này. Tất cả những nỗ lực này làm cho việc áp dụng AI sáng tạo trở nên hấp dẫn hơn hiện nay.

Mô hình

Một số mô hình cơ bản được sử dụng cho khối lượng công việc AI tổng hợp trong điểm chuẩn MLPerf bao gồm:

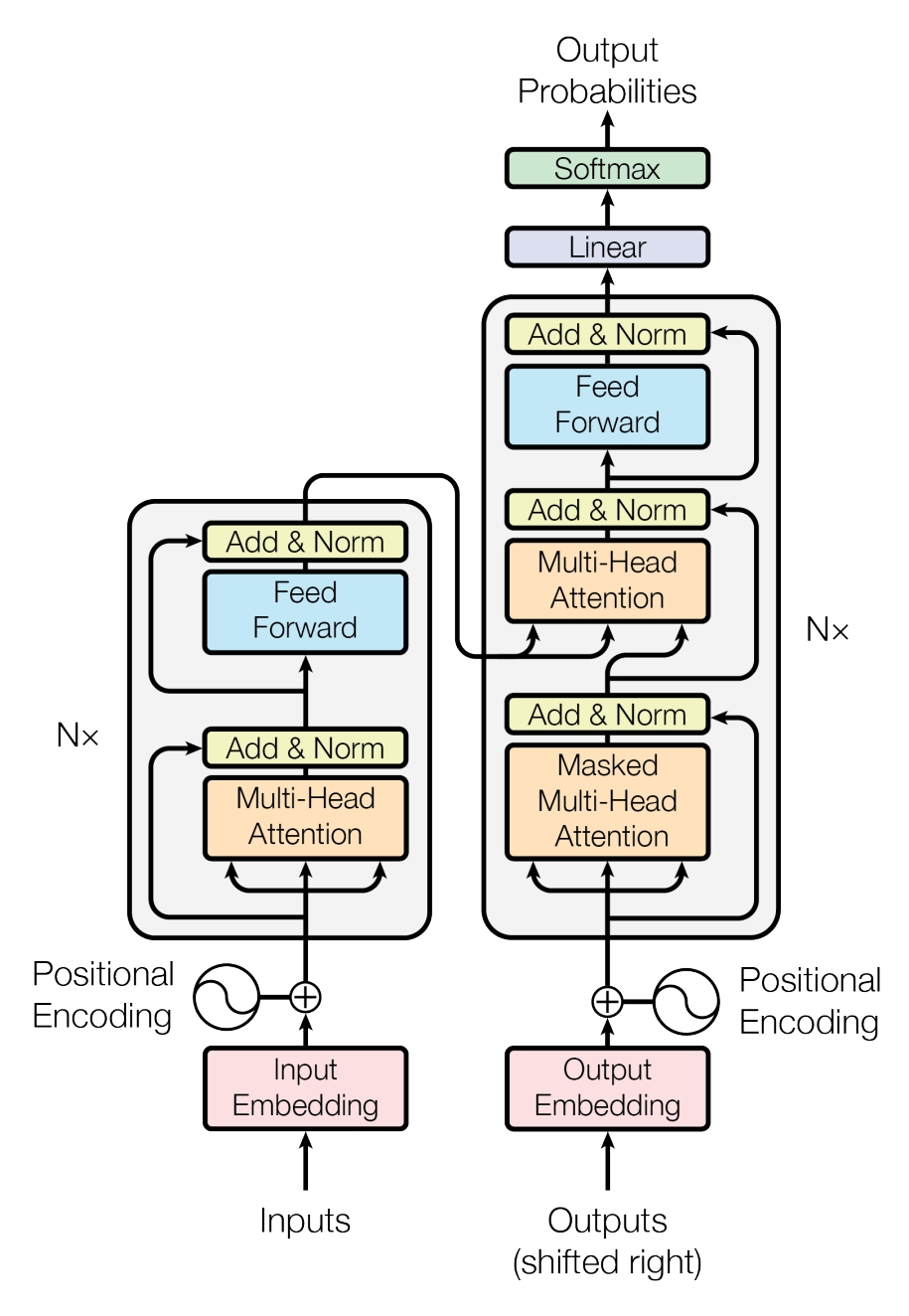

Hình 1: Cấu trúc máy biến áp

- Máy biến áp ─Mô hình này sử dụng cơ chế chú ý để mô hình hóa các lĩnh vực quan tâm trong một bối cảnh cụ thể. Phương pháp này cho phép xây dựng các mối quan hệ biểu thị cách một yếu tố liên quan đến các yếu tố khác.

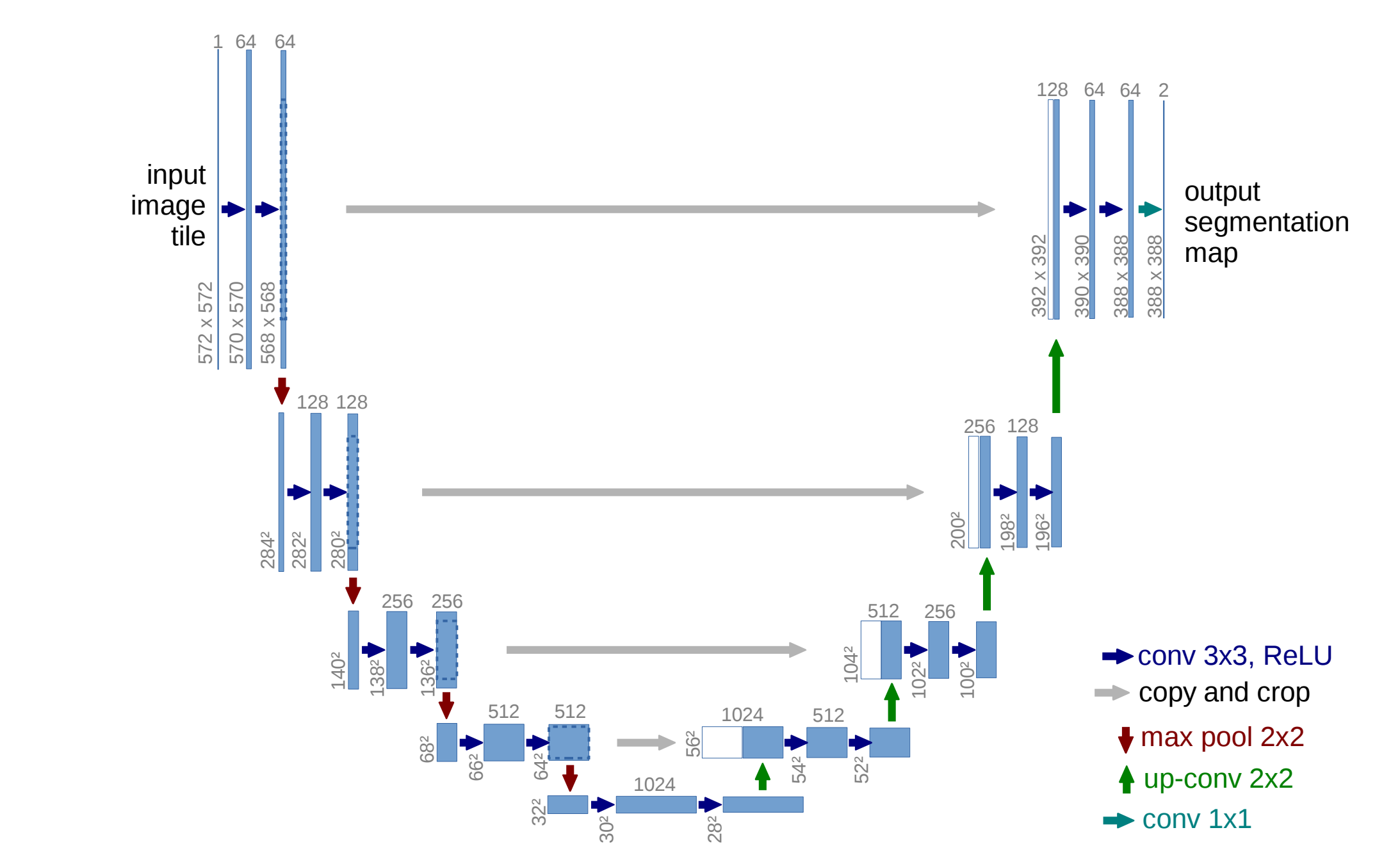

Hình 2: Kiến trúc U-Net

- 3d-UNet ─Mô hình này sử dụng các khối tích chập và gộp chung để thiết lập một đường dẫn co lại và mở rộng tạo ra nút thắt cổ chai. Hình ảnh được xây dựng lại từ nút cổ chai này. Nút thắt cổ chai nắm bắt việc nén dữ liệu; chỉ những thông tin quan trọng mới được sử dụng để tái tạo lại hình ảnh.

AI tổng quát có liên quan như thế nào đến Đào tạo và Suy luận MLPerf?

MLPerf Training sử dụng mô hình ngôn ngữ BERT. Nhiều khối lượng công việc AI tổng hợp dựa trên văn bản là LLM. Mặc dù BERT không lớn bằng GPT3 (khoảng 1/500 kích thước của GPT3 dựa trên một số tham số (340 M so với 175 B)) nhưng nó có các khối cơ bản mà GPT3 sử dụng.

Ví dụ: BERT sử dụng nhiều Đầu chú ý, Layernorms SoftMax, v.v., GPT3 cũng sử dụng. Mặc dù các tham số, số lớp và kích thước mô hình đối với GPT3 lớn hơn nhưng BERT về cơ bản sử dụng các quy trình tương tự cần thiết cho quá trình đào tạo.

Ngược lại, Khuếch tán ổn định sử dụng các lớp UNet. Phương pháp này rất hữu ích để xây dựng hình ảnh có chất lượng cao. Nó lấy văn bản được mã hóa và sử dụng nút cổ chai UNet để kích hoạt quy trình khử nhiễu một cách hiệu quả. 3D-UNet là một phần của điểm chuẩn MLPerf, được tối ưu hóa.

Các ví dụ trước cho thấy rằng các tối ưu hóa được sử dụng trong MLPerf có thể chuyển đổi được và chúng tôi có thể sử dụng các mô hình MLPerf hiện tại làm proxy tương đối cho khối lượng công việc AI tổng hợp.

Hơn nữa, MLPerf bao gồm LLM và Khuếch tán ổn định trên lộ trình cho các phiên bản gửi đào tạo sắp tới. Chúng tôi có thể mong đợi các phiên bản tối ưu hóa của những triển khai này sẽ được cung cấp cho công chúng.

Các liên kết trong tài liệu tham khảo hiển thị các tối ưu hóa do NVIDIA thực hiện cho điểm chuẩn. Khách hàng có thể lấy các tài liệu tham khảo đã được tối ưu hóa và sử dụng chúng cho các trường hợp sử dụng AI tổng quát của mình.

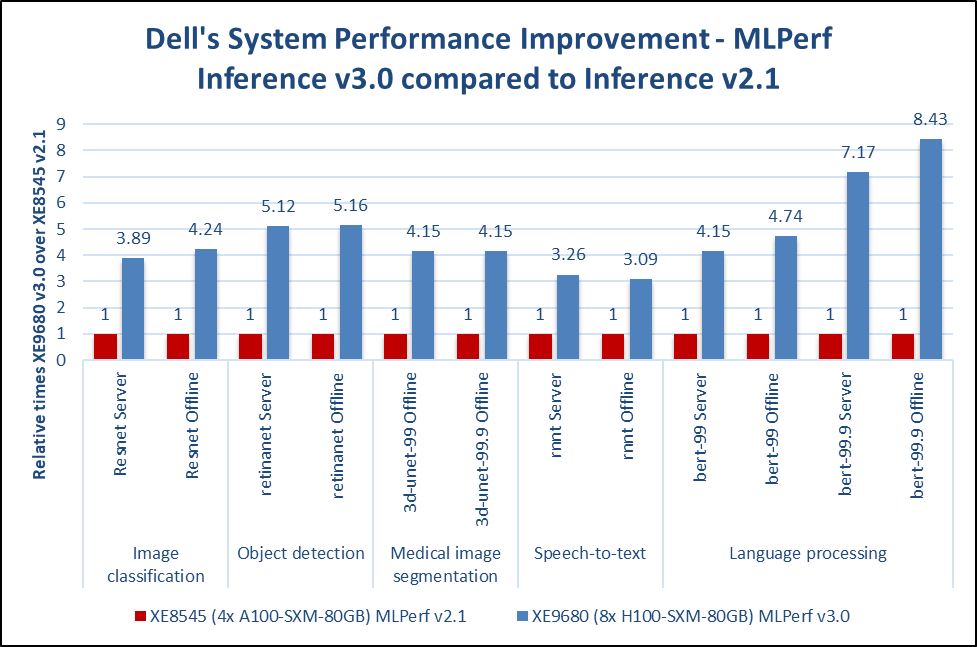

Chúng tôi nhận thấy tầm quan trọng của khối lượng công việc AI, bao gồm cả AI tổng hợp. Do đó, chúng tôi tuân theo các tiêu chuẩn MLCommons để cung cấp các so sánh tương tự với các OEM và nhà cung cấp khác nhau. Quy mô là một khía cạnh quan trọng của khối lượng công việc AI tổng hợp. Chúng tôi đã giới thiệu máy chủ PowerEdge XE9680 mới mang lại hiệu suất vượt trội trên quy mô lớn. Hình dưới đây cho thấy sự cải thiện hiệu suất từ Suy luận MLPerf v2.1 đến Suy luận MLPerf v3.0.

* ID MLPerf 2.1-0014 và ID MLPerf 3.0-0013

Hình 3: Cải thiện hiệu suất MLPerf Inference 3.0 so với Inference 2.1 từ máy chủ XE9680 có GPU 8xH100 so với XE8545 có GPU 4xA100

Hệ thống PowerEdge XE9680 và XE8545 là sự lựa chọn tuyệt vời cho khối lượng công việc AI tổng quát. Khách hàng có thể mong đợi thời gian đánh giá nhanh hơn và các hệ thống này có quy mô rất tốt, nhờ kết quả đào tạo MLPerf .

Phần kết luận

Trong khi AI tạo ra sự phấn khích to lớn, thì có nhiều thách thức như kết quả đầu ra sai lệch, câu trả lời sai, ảo giác, sự bất ổn, v.v. đòi hỏi phải có sự giám sát và kiểm soát. Các hệ thống AI sáng tạo vẫn không thể đưa ra quyết định tự chủ gắn liền với các thuật toán khác cho các ứng dụng quan trọng.

Kết quả MLPerf Inference 3.0 mới nhất cho thấy sự cải thiện gấp ba đến tám lần cho tất cả các danh mục. Những cải tiến này thể hiện cam kết của Dell Technologies trong việc liên tục cho phép cải thiện hiệu suất. Chúng tôi hiểu AI tổng quát là một loại khối lượng công việc AI quan trọng; Phần cứng của Dell hỗ trợ những khối lượng công việc này. Bằng cách nâng cấp lên các máy chủ mới nhất, chẳng hạn như máy chủ PowerEdge XE9680, khách hàng có thể rút ra thời gian định giá nhanh hơn. Dell Technologies có thể giúp khách hàng điều chỉnh và triển khai khối lượng công việc AI tổng hợp.

Tóm lại, tính toán, chất lượng dịch vụ (đầu ra hợp lý), phát triển nguồn mở và khả năng truy cập dễ dàng là những động lực chính cho việc áp dụng hàng loạt AI sáng tạo. Các tổ chức có thể tận dụng những trình điều khiển này để tạo ra kết quả đầu ra cho quy trình làm việc của họ. Kích hoạt các hệ thống này với sự tham gia của con người là những bước đầu tiên tốt để tăng năng suất. Dell Technologies đã và đang gửi MLPerf để cho thấy các máy chủ của chúng tôi có thể mang lại hiệu suất xuất sắc như thế nào. Các tối ưu hóa được thực hiện cho MLPerf có thể được chuyển sang khối lượng công việc AI tổng hợp.

Bài viết mới cập nhật

Công bố các bản nâng cấp không gây gián đoạn dựa trên Drain (NDU)

Trong quy trình làm việc NDU, các nút được khởi động ...

Tăng tốc khối lượng công việc của Hệ thống tệp mạng (NFS) của bạn với RDMA

Giao thức NFS hiện nay được sử dụng rộng rãi trong ...

Mẹo nhanh về dữ liệu phi cấu trúc – OneFS Protection Overhead

Gần đây đã có một số câu hỏi từ lĩnh vực ...

Giới thiệu Dell PowerScale OneFS dành cho Quản trị viên NetApp

Để các doanh nghiệp khai thác được lợi thế của công ...