Tin tức

Trung tâm dữ liệu hiện đại dành cho AI quy mô lớn

Hệ thống Israel-1

Israel-1 là sự hợp tác giữa Dell Technologies và NVIDIA nhằm xây dựng cơ sở trí tuệ nhân tạo (AI)/máy học (ML) quy mô lớn, hiện đại đặt tại trung tâm dữ liệu của NVIDIA ở Israel. Israel-1 sẽ có 2.048 GPU NVIDIA H100 Tensor Core mới nhất sử dụng 256 máy chủ Dell PowerEdge XE9680 AI và mạng lưới AI NVIDIA S pectrum-X Ethernet lớn có bộ chuyển mạch Spectrum-4 và NVIDIA BlueField-3 SuperNIC . Sau khi hoàn thành, nó sẽ là một trong những hệ thống AI nhanh nhất trên thế giới, đóng vai trò là bản thiết kế chi tiết và nền tảng thử nghiệm cho thế hệ cụm AI quy mô lớn tiếp theo. Hệ thống này sẽ được sử dụng để đánh giá khối lượng công việc AI, phân tích các mô hình liên lạc để tối ưu hóa và phát triển các phương pháp hay nhất để sử dụng Ethernet làm kết cấu AI.

Trong hệ thống Israel-1, mỗi Dell PowerEdge XE9680 được trang bị hai DPU NVIDIA BlueField-3, tám SuperNIC BlueField-3 và tám GPU H100. GPU H100 trong mỗi máy chủ được kết nối với kết cấu bên trong NVIDIA NVLink được chuyển đổi để cung cấp băng thông liên lạc giữa GPU với GPU là 900GB/giây. Các máy chủ Dell PowerEdge XE9680 được kết nối với cơ sở hạ tầng Spectrum-X Ethernet AI.

Mỗi bộ chuyển mạch Ethernet Spectrum-4 cung cấp thông lượng 51,2 Tb/s và được triển khai cùng với SuperNIC BlueField-3 400 Gb/s để kết nối 2.048 GPU trong hệ thống. Trong mỗi Dell PowerEdge XE9680, tám SuperNIC BlueField-3 được kết nối với cấu trúc máy chủ Spectrum-X và hai DPU BlueField-3 được kết nối với cấu trúc lưu trữ, điều khiển và truy cập, như trong Hình 1. BlueField-3 SuperNIC là một lớp bộ tăng tốc mạng mới, được thiết kế cho tính toán song song quy mô lớn, sử dụng nhiều mạng.

Sự kết hợp giữa NVIDIA Spectrum-4 và BlueField-3 SuperNIC thể hiện khả năng tồn tại của kết cấu Ethernet được xây dựng có mục đích để kết nối nhiều GPU cần thiết cho khối lượng công việc AI (GenAI) tổng hợp. Các giải pháp có quy mô như Israel-1 dự kiến sẽ ngày càng trở nên phổ biến hơn trong tương lai. Dell PowerEdge XE9680 có thể tận dụng mọi công nghệ kết cấu để kết nối máy chủ của các hệ thống như vậy.

Máy chủ Dell PowerEdge XE9680

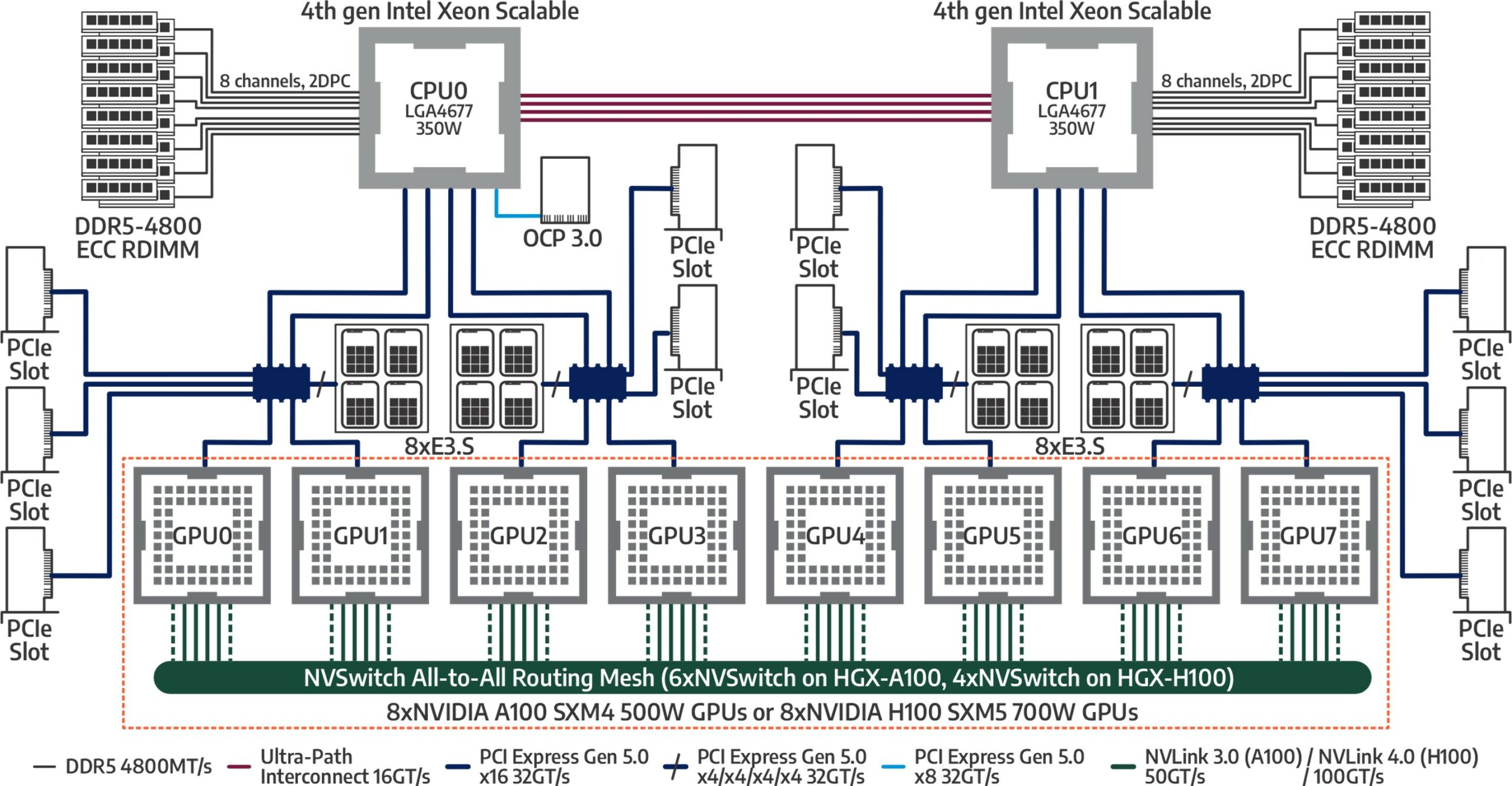

Dell PowerEdge XE9680 được thiết kế dành riêng cho các mẫu máy lớn AI/ML có yêu cầu khắt khe nhất. Đây là nền tảng máy chủ Dell đầu tiên được trang bị tám GPU được kết nối thông qua các kết nối NVLink băng thông cao được chuyển đổi. Với 10 khe cắm PCIe có sẵn, Dell PowerEdge XE9680 được định vị độc đáo để trở thành nền tảng được lựa chọn cho các ứng dụng AI/ML. Thiết kế mô-đun sáng tạo của nó được thể hiện trong Hình 2.

Phần trên cùng của khung máy chứa các hệ thống con điện toán và bộ nhớ, với hai Bộ xử lý Intel Xeon thế hệ thứ 4 và RAM lên tới 4TB. Phần dưới cùng của khung cung cấp 10 khe cắm PCIe Gen5, có thể chứa tối đa 10 thiết bị có chiều cao đầy đủ PCIe Gen5 và khả năng kết nối PCIe Gen5 với nhiều mô-đun GPU, bao gồm hệ thống GPU H100 được sử dụng trong siêu máy tính Israel-1. Hệ thống GPU Dell PowerEdge XE9680 H100 bao gồm cơ sở hạ tầng chuyển mạch NVLink và được hiển thị trong Hình 3.

Kiến trúc PCIe bên trong của Dell PowerEdge XE9680 được thiết kế dành cho các ứng dụng AI. GPU và phần mềm NVIDIA triển khai GPUDirect RDMA , cho phép GPU trên các máy chủ riêng biệt giao tiếp qua mạng hỗ trợ RDMA (chẳng hạn như RoCE) mà không cần sự tham gia của CPU chủ. Điều này giúp giảm độ trễ và cải thiện thông lượng cho hoạt động liên lạc giữa các máy chủ GPU-GPU thường gặp trong khối lượng công việc AI. Hình 4 thể hiện cái nhìn chi tiết bên trong của Dell PowerEdge XE9680.

Mỗi trong số tám khe cắm Dell PowerEdge XE9680 PCIe được thiết kế để kết nối trực tiếp với một trong tám GPU thông qua bộ chuyển mạch PCIe nhúng với các làn x16 PCIe 5.0, mỗi khe cung cấp băng thông đầy đủ 400 Gb/s cho mỗi cặp GPU. Điều này cho phép các GPU giao tiếp hiệu quả giữa các máy chủ với nhau thông qua SuperNIC BlueField-3 và mang lại thông lượng cao nhất cùng với độ trễ thấp nhất cho GPUDirect và giao tiếp RDMA khác.

Kết nối mạng cho AI

Mạng là một thành phần quan trọng trong việc xây dựng hệ thống AI. Với sự xuất hiện của các mô hình AI như mô hình ngôn ngữ lớn hoặc GenAI đa mô hình, thiết kế và hiệu suất mạng đã đóng vai trò trung tâm trong việc xác định hiệu suất khối lượng công việc AI. Có hai lý do chính để sử dụng kết cấu mạng được thiết kế đặc biệt cho khối lượng công việc AI:

- Giao tiếp giữa các nút máy chủ để xử lý song song. Khi kích thước mô hình và kích thước dữ liệu tăng lên, việc đào tạo mô hình sẽ cần nhiều sức mạnh tính toán hơn. Thường cần phải sử dụng song song, một kỹ thuật sử dụng nhiều máy chủ để huấn luyện một mô hình lớn trong thời gian hợp lý. Điều này đòi hỏi băng thông dữ liệu hiệu quả cao với độ trễ rất ngắn để trao đổi độ dốc trên các máy chủ. Thông thường, mô hình được huấn luyện càng lớn thì lượng dữ liệu cần trao đổi ở mỗi lần lặp càng lớn. Chức năng này được cung cấp bởi kết cấu mạng Spectrum-X.

- Truy cập dữ liệu. Truy cập dữ liệu là rất quan trọng trong quá trình đào tạo AI. Dữ liệu thường được lưu trữ trên kho lưu trữ trung tâm và được các máy chủ riêng lẻ truy cập qua mạng. Trong đào tạo mô hình lớn, cũng cần phải lưu trạng thái đào tạo theo các khoảng thời gian định kỳ. Quá trình này được gọi là điểm kiểm tra và cần thiết để tiếp tục đào tạo trong trường hợp có lỗi trong quá trình kéo dài. Chức năng này thường được cung cấp bởi kết cấu mạng lưu trữ để cách ly mạng liên lạc giữa máy chủ với máy chủ khỏi mạng truy cập I/O và tránh để một loại lưu lượng truy cập can thiệp vào loại lưu lượng khác, điều này sẽ tạo ra nhiều nguy cơ tắc nghẽn hơn.

Nguyên tắc thiết kế của cụm Israel-1 có tính đến các yêu cầu này, với tám SuperNIC BlueField-3 trong mỗi chiếc Dell PowerEdge XE9680 dành riêng cho giao tiếp giữa máy chủ với máy chủ, cùng với hai DPU BlueField-3 bổ sung xử lý lưu lượng I/O lưu trữ dữ liệu , đồng thời đóng vai trò là mặt phẳng điều khiển cho hệ thống.

Việc sử dụng SuperNIC BlueField-3, cùng với các bộ chuyển mạch Spectrum-4, là một trong những điểm thiết kế quan trọng nhất của hệ thống Israel-1. Do khối lượng công việc AI trao đổi lượng dữ liệu khổng lồ trên nhiều GPU, nên mạng Ethernet truyền thống có thể gặp phải vấn đề tắc nghẽn khi quy mô kết cấu tăng lên. NVIDIA đã kết hợp các cơ chế cải tiến như Ethernet không mất dữ liệu, định tuyến thích ứng RDMA, cách ly tiếng ồn và kiểm soát tắc nghẽn dựa trên phép đo từ xa bằng cách sử dụng bộ chuyển mạch BlueField-3 SuperNIC và Spectrum-4. Những khả năng này cải thiện đáng kể khả năng mở rộng khối lượng công việc AI so với mạng Ethernet tiêu chuẩn.

Sự kết hợp phù hợp cho hệ thống AI quy mô lớn

Sự kết hợp giữa máy chủ Dell PowerEdge XE9680 AI với 10 khe cắm PCIe Gen5, NVIDIA DPU và SuperNIC mới nhất, mô-đun GPU NVIDIA HGX 8x H100 và Spectrum-X Ethernet cho mạng AI tạo ra các khối xây dựng lý tưởng cho hệ thống AI. Dell đang hợp tác với NVIDIA trên hệ thống này và mong muốn chia sẻ những kiến thức cũng như hiểu biết sâu sắc thu thập được từ việc chạy và thử nghiệm khối lượng công việc AI trên hệ thống để giúp các tổ chức xây dựng hệ thống được tối ưu hóa cho AI. Tìm hiểu thêm về các dịch vụ AI của Dell tại đây.

Bài viết mới cập nhật

Công bố các bản nâng cấp không gây gián đoạn dựa trên Drain (NDU)

Trong quy trình làm việc NDU, các nút được khởi động ...

Tăng tốc khối lượng công việc của Hệ thống tệp mạng (NFS) của bạn với RDMA

Giao thức NFS hiện nay được sử dụng rộng rãi trong ...

Mẹo nhanh về dữ liệu phi cấu trúc – OneFS Protection Overhead

Gần đây đã có một số câu hỏi từ lĩnh vực ...

Giới thiệu Dell PowerScale OneFS dành cho Quản trị viên NetApp

Để các doanh nghiệp khai thác được lợi thế của công ...