Tin tức

Nghiên cứu hiệu suất của cụm HPC ảo hóa VMware vSphere 7

Điện toán hiệu năng cao (HPC) liên quan đến việc xử lý các vấn đề khoa học và kỹ thuật phức tạp ở tốc độ cao trên một cụm các nút điện toán. Hiệu suất là một trong những tính năng quan trọng nhất của HPC. Mặc dù hầu hết các ứng dụng HPC đều chạy trên máy chủ kim loại trần, nhưng ngày càng có nhiều người quan tâm đến việc chạy các ứng dụng HPC trong môi trường ảo. Ngoài việc cung cấp khả năng phục hồi và dự phòng cho các nút ảo, ảo hóa còn mang đến sự linh hoạt để nhanh chóng khởi tạo một cụm HPC ảo an toàn.

Hầu hết mọi người có xu hướng chạy khối lượng công việc HPC của họ trên phần cứng chuyên dụng, phần cứng này thường bao gồm các nút điện toán của máy chủ được kết nối với nhau bằng mạng tốc độ cao để tối đa hóa hiệu suất của chúng. Ngoài ra, ảo hóa trừu tượng hóa phần cứng bên dưới và thêm một lớp phần mềm mô phỏng phần cứng này. Với suy nghĩ này, các kỹ sư tại Dell Technologies HPC & AI Innovation Lab và VMware đã tiến hành một nghiên cứu hiệu suất để so sánh hiệu suất của việc chạy và thay đổi quy mô khối lượng công việc HPC trên các nút kim loại trần chuyên dụng với cơ sở hạ tầng ảo hóa dựa trên vSphere 7. Nhóm cũng điều chỉnh cơ sở hạ tầng vật lý và ảo để đạt được hiệu suất ảo tối ưu, đồng thời chia sẻ những phát hiện và đề xuất này.

Chi tiết kiểm tra hiệu suất

Nhóm của chúng tôi đã đánh giá các ứng dụng HPC được liên kết chặt chẽ hoặc khối lượng công việc dựa trên giao diện truyền thông báo (MPI) và quan sát thấy các kết quả đầy hứa hẹn. Các ứng dụng này bao gồm các quy trình song song (xếp hạng MPI) tận dụng nhiều lõi và được kiến trúc để mở rộng quy mô tính toán cho nhiều máy chủ tính toán (hoặc máy ảo) nhằm giải quyết mô hình toán học phức tạp hoặc mô phỏng khoa học một cách kịp thời. Ví dụ về khối lượng công việc HPC được kết hợp chặt chẽ bao gồm tính toán động lực học chất lỏng (CFD) được sử dụng để lập mô hình luồng không khí trong thiết kế ô tô và máy bay, nghiên cứu thời tiết và mô hình dự báo để dự đoán thời tiết và mã mô phỏng hồ chứa để khám phá dầu.

Để đánh giá hiệu suất của các ứng dụng HPC được liên kết chặt chẽ này, chúng tôi đã xây dựng cụm HPC 16 nút bằng cách sử dụng các nút Dell PowerEdge R640 vSAN Ready. Dell Power Edge R640 là máy chủ ổ cắm kép 1U với bộ xử lý Intel® Xeon® Scalable. Cụm tương tự đã được định cấu hình vừa là cụm HPC kim loại trần vừa là cụm ảo chạy VMware vSphere.

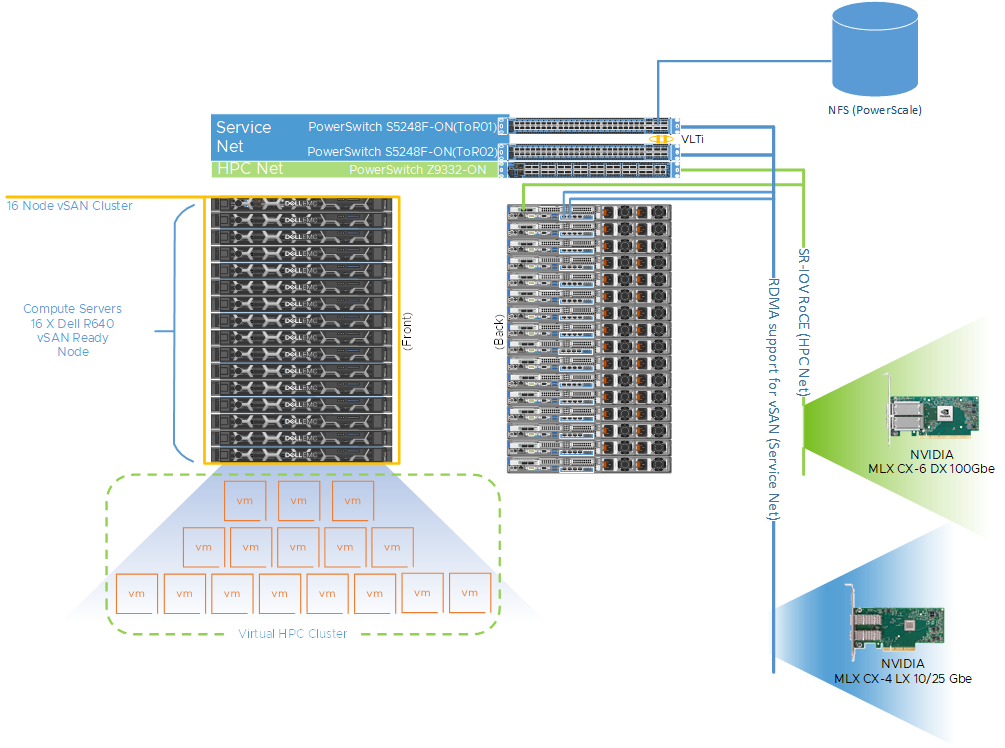

Hình 1 cho thấy cấu trúc liên kết mạng đại diện của cụm này. Cụm được kết nối với hai mạng vật lý riêng biệt. Chúng tôi đã sử dụng các thành phần sau cho cụm này:

- Bộ chuyển mạch Dell PowerSwitch Z9332 kết nối bộ điều hợp NVIDIA® Connect®-X6 100 GbE để cung cấp mạng HPC dựa trên RDMA 100 GbE băng thông cao có độ trễ thấp cho khối lượng công việc HPC dựa trên MPI

- một cặp thiết bị chuyển mạch Dell PowerSwitch S5248 25 GbE dựa trên giá đỡ (ToR) riêng biệt để quản lý trình ảo hóa, truy cập VM và mạng VMware vSAN cho cụm ảo

Các bộ chuyển mạch VM cung cấp khả năng dự phòng và được kết nối bằng một kết nối vận chuyển đường dẫn ảo (VLTi). Một cụm VMware vSAN đã được tạo để lưu trữ VMDK cho các máy ảo. Để tối đa hóa việc sử dụng CPU RDMA, chúng tôi cũng tận dụng hỗ trợ cho vSAN. Điều này cung cấp quyền truy cập bộ nhớ trực tiếp giữa các nút tham gia vào cụm vSAN mà không liên quan đến hệ điều hành hoặc CPU. RDMA cung cấp độ trễ thấp, thông lượng cao và IOP cao, khó đạt được hơn với các mạng dựa trên TCP truyền thống. Nó cũng cho phép khối lượng công việc HPC tiêu thụ nhiều CPU hơn cho công việc của họ mà không ảnh hưởng đến hiệu suất vSAN.

Hình 1 : Giường thử nghiệm cụm HPC 16 nút

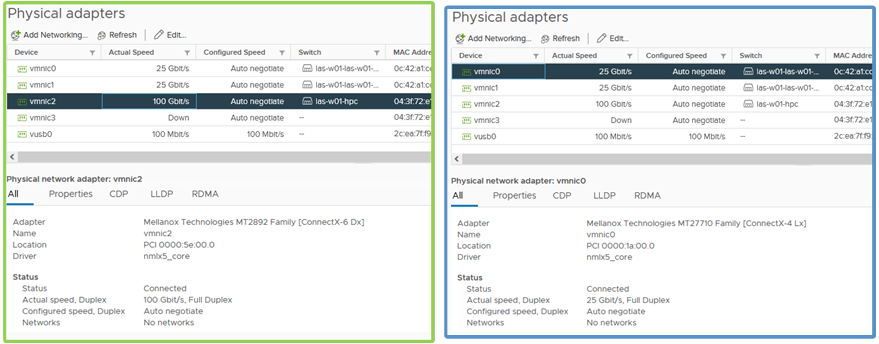

Hình 2 : Cấu hình bộ điều hợp vật lý cho mạng HPC và mạng dịch vụ

Bảng 1 mô tả chi tiết cấu hình của các nút vật lý và kết nối mạng. Đối với cụm ảo, một máy ảo duy nhất trên mỗi nút đã được cung cấp cho tổng số 16 máy ảo hoặc nút điện toán ảo. Mỗi VM được định cấu hình với 44 vCPU và 144 GB bộ nhớ, CPU VM và dự trữ bộ nhớ đã được bật và chúng tôi đặt độ nhạy độ trễ của VM thành cao. Hình 1 cũng cung cấp một ví dụ về cách các máy chủ được kết nối với từng loại vải. Một cổng từ mỗi máy chủ được kết nối với bộ điều hợp NVIDIA Mellanox ConnectX-6 và với Dell PowerSwitch Z9332 cho cấu trúc mạng HPC. Đối với kết cấu mạng dịch vụ, hai cổng được kết nối từ bộ điều hợp NVIDIA Mellanox ConnectX-4 với bộ chuyển mạch Dell PowerSwitch S5248 ToR.

Bảng 1 : Chi tiết cấu hình cho các cụm kim loại trần và ảo

| Môi trường | kim loại trần | Ảo |

| Người phục vụ | Nút sẵn sàng PowerEdge R640 vSAN | |

| bộ vi xử lý | 2 x Intel Xeon thế hệ 2 6240R | |

| lõi | Tất cả 48 lõi được sử dụng | 44 vCPU đã sử dụng |

| Kỉ niệm | 12 x 16GB @3200 MT/s Đã sử dụng hết 192 GB |

144 GB dành riêng cho VM |

| Hệ điều hành | CentOS 8.3 | Hệ điều hành máy chủ: VMware vSphere 7.0u2 Hệ điều hành khách: CentOS 8.3 |

| Mạng HPC NIC | 100 GbE NVIDIA Mellanox Connect-X6 | |

| Mạng dịch vụ NIC | 10/25 GbE NVIDIA Mellanox Connect-X4 | |

| Công tắc mạng HPC | Dell PowerSwitch Z9332F-ON | |

| Chuyển mạng dịch vụ | Dell PowerSwitch S5248F-ON | |

Bảng 2 cho thấy một loạt các ứng dụng HPC khác nhau trên nhiều miền dọc cùng với bộ dữ liệu điểm chuẩn được sử dụng để so sánh hiệu suất.

Bảng 2: Chi tiết ứng dụng và điểm chuẩn

| Đăng kí | Miền dọc | Bộ dữ liệu điểm chuẩn |

| OpenFOAM | Sản xuất – Động lực học chất lỏng tính toán (CFD) | Lưới ô tô xe máy 20M |

| Dự báo và Nghiên cứu Thời tiết (WRF) | Thời tiết và Môi trường | Côn Đảo 2.5KM |

| Trình mô phỏng song song nguyên tử/phân tử quy mô lớn (LAMMPS) | Động lực học phân tử | Tiêu chuẩn chất rắn kim loại EAM |

| GROMACS | Khoa học sự sống – Động lực học phân tử | Điểm chuẩn HECBioSim – Nguyên tử 3M |

| Động lực học phân tử kích thước nano (NAMD) | Khoa học sự sống – Động lực học phân tử | STMV – 1,06 triệu nguyên tử |

Kết quả hoạt động

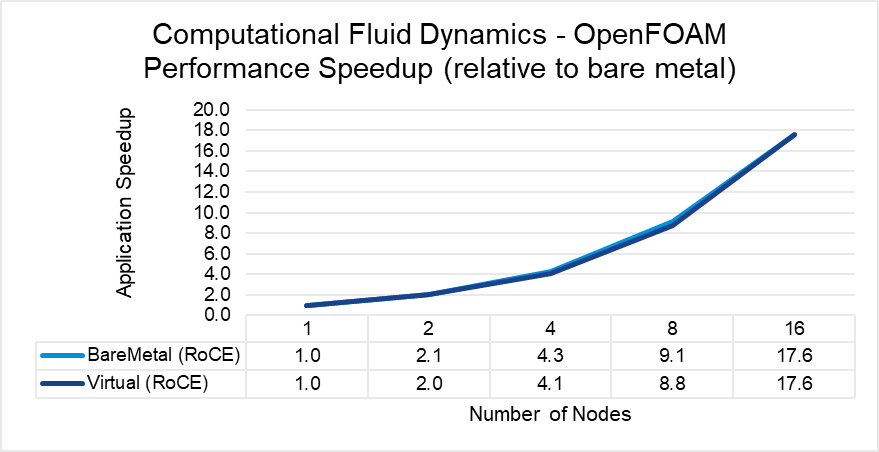

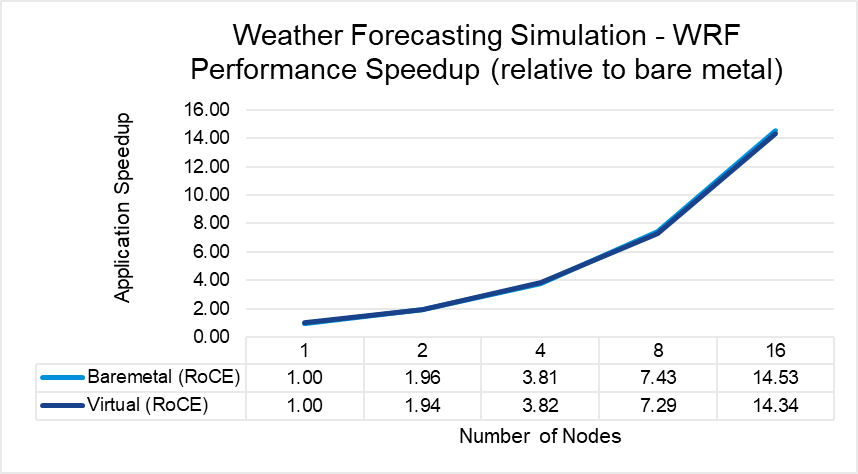

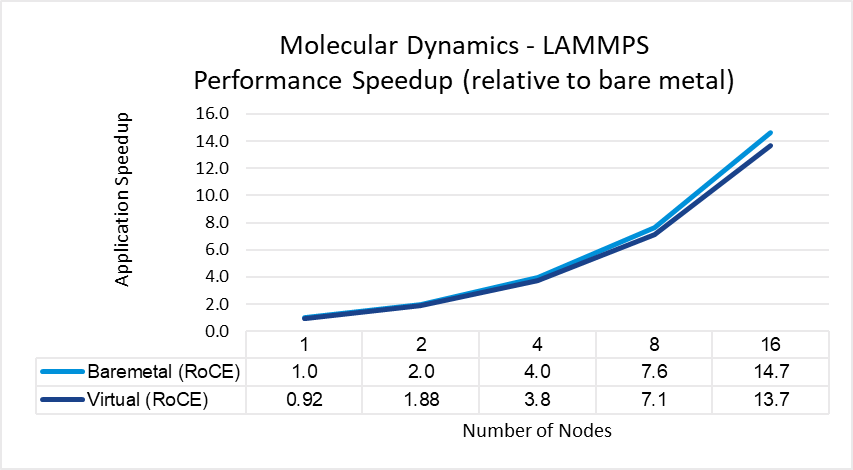

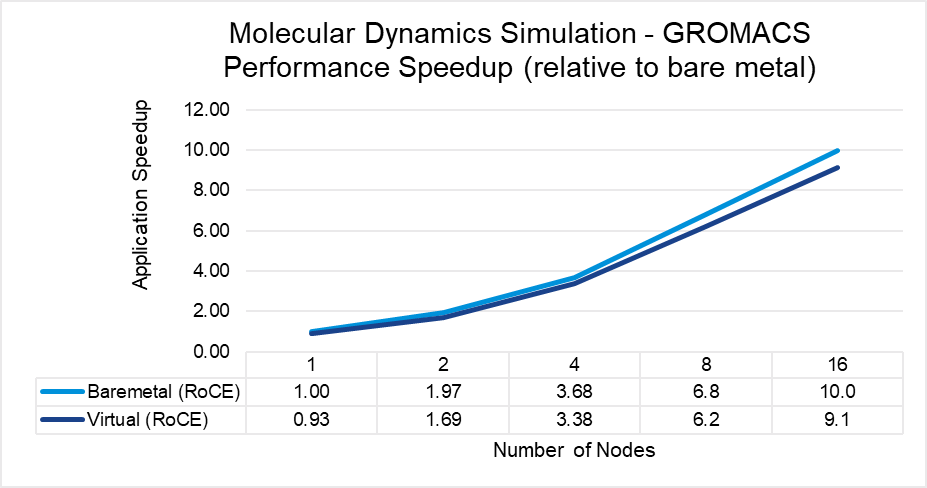

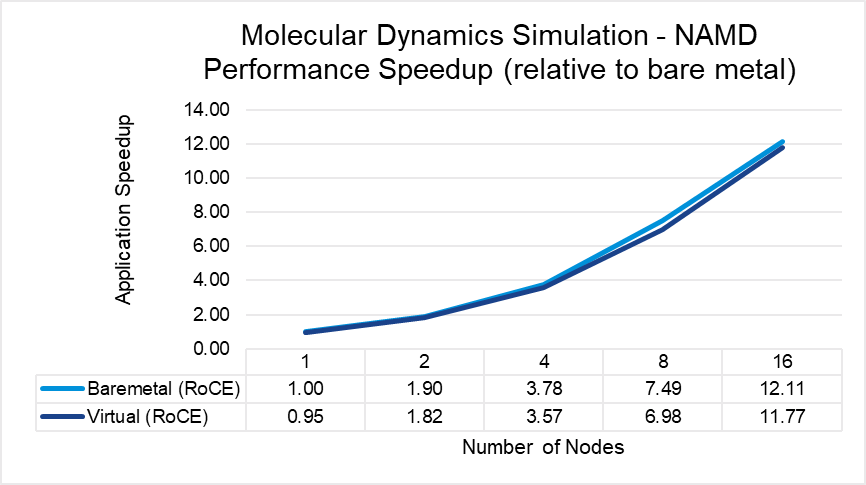

Các hình từ 3 đến 7 cho thấy hiệu suất, khả năng mở rộng và sự khác biệt về hiệu suất của năm ứng dụng HPC đại diện trong các lĩnh vực CFD, thời tiết và khoa học. Mỗi ứng dụng được chạy theo tỷ lệ từ 1 nút đến 16 nút trên kim loại trần và cụm ảo. Tất cả năm ứng dụng đều thể hiện khả năng tăng tốc hiệu quả khi tính toán được mở rộng cho nhiều hệ thống. Tốc độ tăng tốc tương đối cho ứng dụng được vẽ trên biểu đồ (đường cơ sở là hiệu suất của ứng dụng trên một nút kim loại trần).

Kết quả chỉ ra rằng hiệu suất của ứng dụng MPI chạy trong cơ sở hạ tầng ảo hóa (với sự điều chỉnh phù hợp và tuân theo các phương pháp hay nhất dành cho các ứng dụng nhạy cảm với độ trễ trong môi trường ảo) gần bằng hiệu suất trong cơ sở hạ tầng kim loại trần. Đồng bằng hiệu suất nút đơn dao động từ không có sự khác biệt đối với WRF đến mức chênh lệch tối đa 8 phần trăm được quan sát với LAMMPS. Tương tự như vậy, khi các nút được chia tỷ lệ, hiệu suất quan sát được trên các nút ảo tương đương với hiệu suất trên cơ sở hạ tầng kim loại trần với đồng bằng lớn nhất là 10% khi chạy LAMMPS trên 16 nút.

Hình 3: So sánh hiệu năng OpenFOAM giữa hệ thống ảo và hệ thống bare-metal

Hình 4 : So sánh hiệu suất WRF giữa các hệ thống ảo và hệ thống kim loại trần

Hình 5 : So sánh hiệu suất LAMMPS giữa các hệ thống ảo và hệ thống kim loại trần

Hình 6 : So sánh hiệu suất GROMACS giữa các hệ thống ảo và kim loại trần

Hình 7: So sánh hiệu suất NAMD giữa các hệ thống ảo và hệ thống kim loại trần

Điều chỉnh cho hiệu suất tối ưu

Một trong những yếu tố chính để đạt được giải pháp HPC ảo hóa khả thi là các phương pháp hay nhất về điều chỉnh cho phép đạt được hiệu suất tối ưu. Chúng tôi nhận thấy đã đạt được một cải tiến đáng kể sau khi thực hiện một số điều chỉnh nhỏ từ cấu hình sẵn dùng. Những cải tiến này là một thành phần quan trọng để đảm bảo khách hàng có thể và sẽ đạt được kết quả không chỉ cho phép triển khai môi trường HPC ảo mà còn áp dụng hệ sinh thái sẵn sàng cho đám mây hơn, mang lại hiệu quả hoạt động và hỗ trợ nhiều khối lượng công việc.

Bảng 3 phác thảo các tham số mà chúng tôi thấy là hoạt động tốt nhất cho các ứng dụng MPI. Do bản chất của MPI dành cho giao tiếp song song và sự phụ thuộc nhiều vào mạng có độ trễ thấp, chúng tôi khuyên bạn nên triển khai cài đặt Độ nhạy độ trễ của máy ảo có sẵn trong vSphere 7.0. Cài đặt này cho phép người dùng tối ưu hóa độ trễ lập lịch cho các ứng dụng nhạy cảm với độ trễ bằng cách 1) cấp quyền truy cập độc quyền vào tài nguyên vật lý để giảm tranh chấp tài nguyên, 2) bỏ qua các lớp ảo hóa không cung cấp giá trị cho các khối lượng công việc này và 3) điều chỉnh các lớp ảo hóa để giảm bất kỳ chi phí không cần thiết. Chúng tôi cũng đã phác thảo các điều chỉnh máy chủ vật lý và trình ảo hóa bổ sung để hoàn thiện các phương pháp hay nhất này bên dưới.

Bảng 3: Các lượt hiệu suất được đề xuất cho khối lượng công việc HPC được liên kết chặt chẽ

| Cài đặt | Giá trị |

| Máy chủ vật lý | |

| Cấu hình nguồn BIOS | Hiệu suất trên mỗi watt (OS) |

| BIOS siêu phân luồng | Trên |

| Nút BIOS xen kẽ | Tắt |

| BIOS SR-IOV | Trên |

| siêu giám sát | |

| Chính sách năng lượng ESXi | Hiệu suất cao |

| Máy ảo | |

| Độ nhạy trễ của VM | Cao |

| Dự trữ CPU VM | Đã bật |

| Dự trữ bộ nhớ VM | Đã bật |

| Định cỡ máy ảo | Kích thước VM tối đa với dự trữ CPU/bộ nhớ |

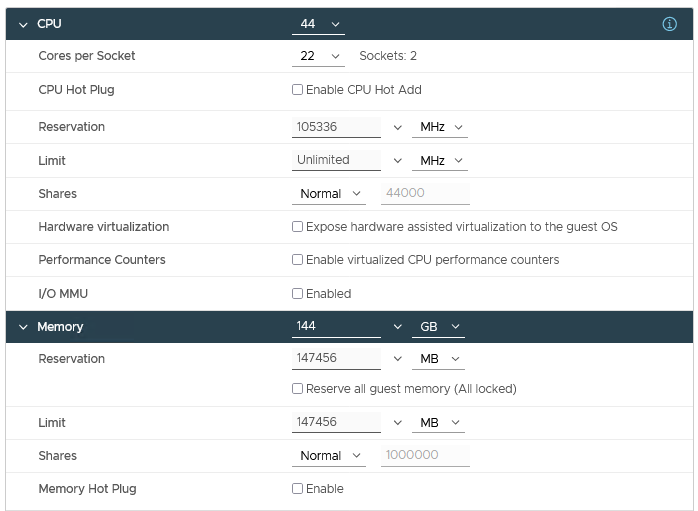

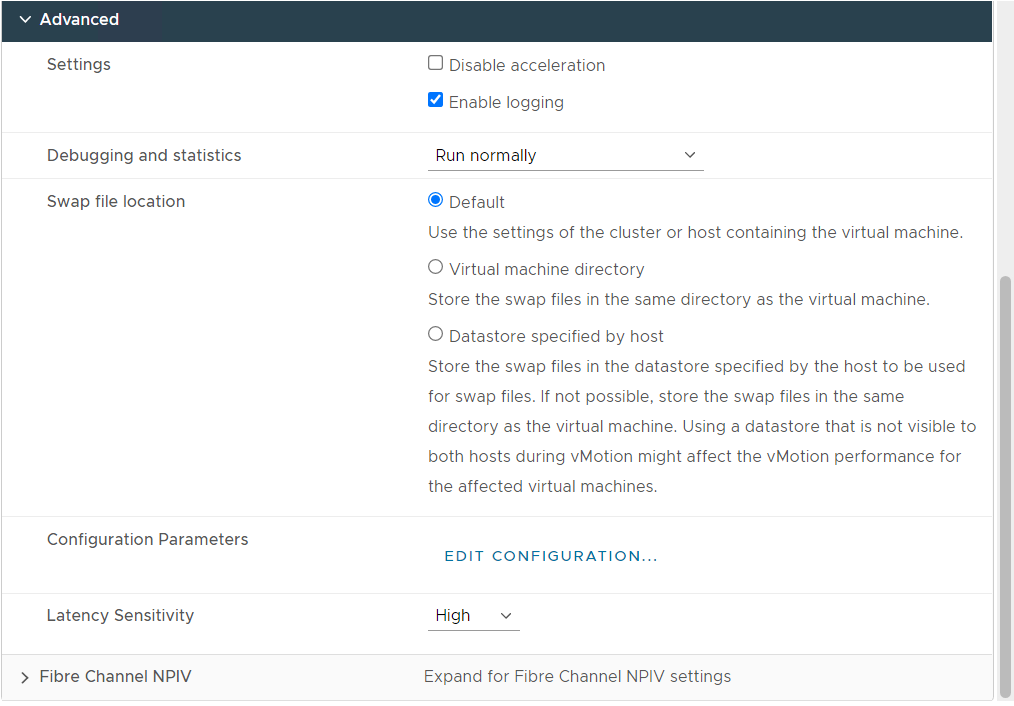

Hình 8: Cấu hình máy ảo với các cài đặt điều chỉnh được khuyến nghị

Hình 8 hiển thị ảnh chụp nhanh các cài đặt điều chỉnh được khuyến nghị áp dụng cho máy ảo được sử dụng làm nút ảo trên cụm HPC.

Sự kết luận

Đạt được hiệu suất tối ưu là yếu tố quan trọng cần cân nhắc khi chạy ứng dụng HPC. Mặc dù hầu hết các ứng dụng HPC đều được hưởng các lợi ích về hiệu suất do phần cứng kim loại trần chuyên dụng mang lại, nhưng kết quả của chúng tôi cho thấy rằng với việc điều chỉnh phù hợp, khoảng cách hiệu suất giữa các nút kim loại ảo và kim loại trần đã được thu hẹp, khiến việc chạy một số ứng dụng HPC nhất định trong môi trường ảo hóa trở nên khả thi. Chúng tôi cũng quan sát thấy rằng các ứng dụng HPC đã thử nghiệm này thể hiện khả năng tăng tốc hiệu quả khi tính toán được mở rộng ra nhiều nút ảo.

Bài viết mới cập nhật

PowerFlex và PowerProtect: Giữ cho Vương quốc CNTT của bạn không có Ransomware

“Tồn tại hay không tồn tại? Đó là câu hỏi.” Đáng ...

Giới thiệu về nền tảng Unified PowerFlex Manager

Chúng ta đều đã nghe câu nói nổi tiếng rằng “Thay ...

Giới thiệu NVMe qua TCP (NVMe/TCP) trong PowerFlex 4.0

Bất kỳ ai đã sử dụng hoặc quản lý PowerFlex đều ...

Khả năng dịch vụ tập tin mới của PowerFlex 4.0

“Chỉ cần lưu trữ”, họ nói, và câu hỏi hiển nhiên ...